30. OKTOBER 2024

KI-Agenten mit der Gemini API in die Produktion bringen

Das Erstellen und Bereitstellen von KI-Agents ist ein spannendes Feld, aber die Verwaltung dieser komplexen Systeme in einer Produktionsumgebung erfordert eine robuste Observability. AgentOps ist ein Python SDK für die Überwachung von KI-Agenten, die Kostenverfolgung von LLMs, Benchmarking und mehr. Damit können Entwickler ihre KI-Agenten vom Prototyp zur Produktionsumgebung weiterentwickeln, insbesondere in Kombination mit der Leistungsfähigkeit und Kosteneffizienz der Gemini API.

Die Vorteile von Gemini

Adam Silverman, COO von Agency AI, dem Team hinter AgentOps, erklärt, dass die Kosten ein entscheidender Faktor für Unternehmen sind, die KI-Agents in großem Umfang einsetzen. „Wir haben gesehen,dass Unternehmen 80.000 $pro Monat für LLM-Aufrufe ausgeben. Mit Gemini 1.5 hätte das für dieselbe Ausgabe einige Tausend Dollar gekostet.“

Diese Kosteneffizienz in Kombination mit den leistungsstarken Funktionen von Gemini zum Verarbeiten und Generieren von Sprache macht es zur idealen Wahl für Entwickler, die anspruchsvolle KI-Agents erstellen. „Gemini 1.5 Flash bietet uns eine vergleichbare Qualität wie größere Modelle, aber zu einem Bruchteil der Kosten und mit einer unglaublichen Geschwindigkeit“, sagt Silverman. So können sich Entwickler auf das Erstellen komplexer, mehrstufiger Agent-Workflows konzentrieren, ohne sich um unkontrollierte Kosten sorgen zu müssen.

„Wir haben gesehen, dass einzelne Agent-Ausführungen bei anderen LLM-Anbietern über 500 $pro Ausführung kosten. Dieselben Läufe mit Gemini (1.5 Flash-8B) kosten weniger als 50 $.“

KI-Agenten unterstützen

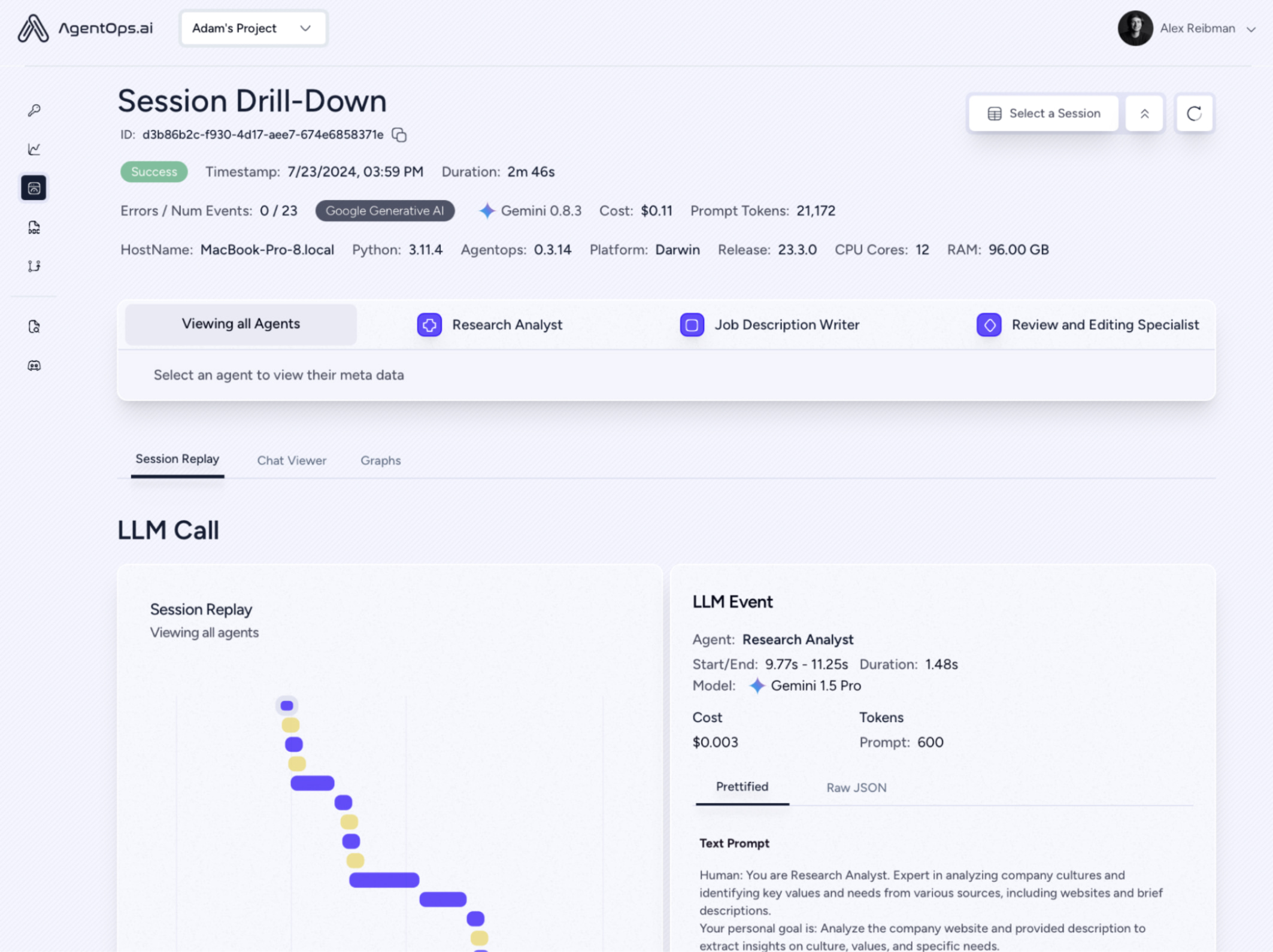

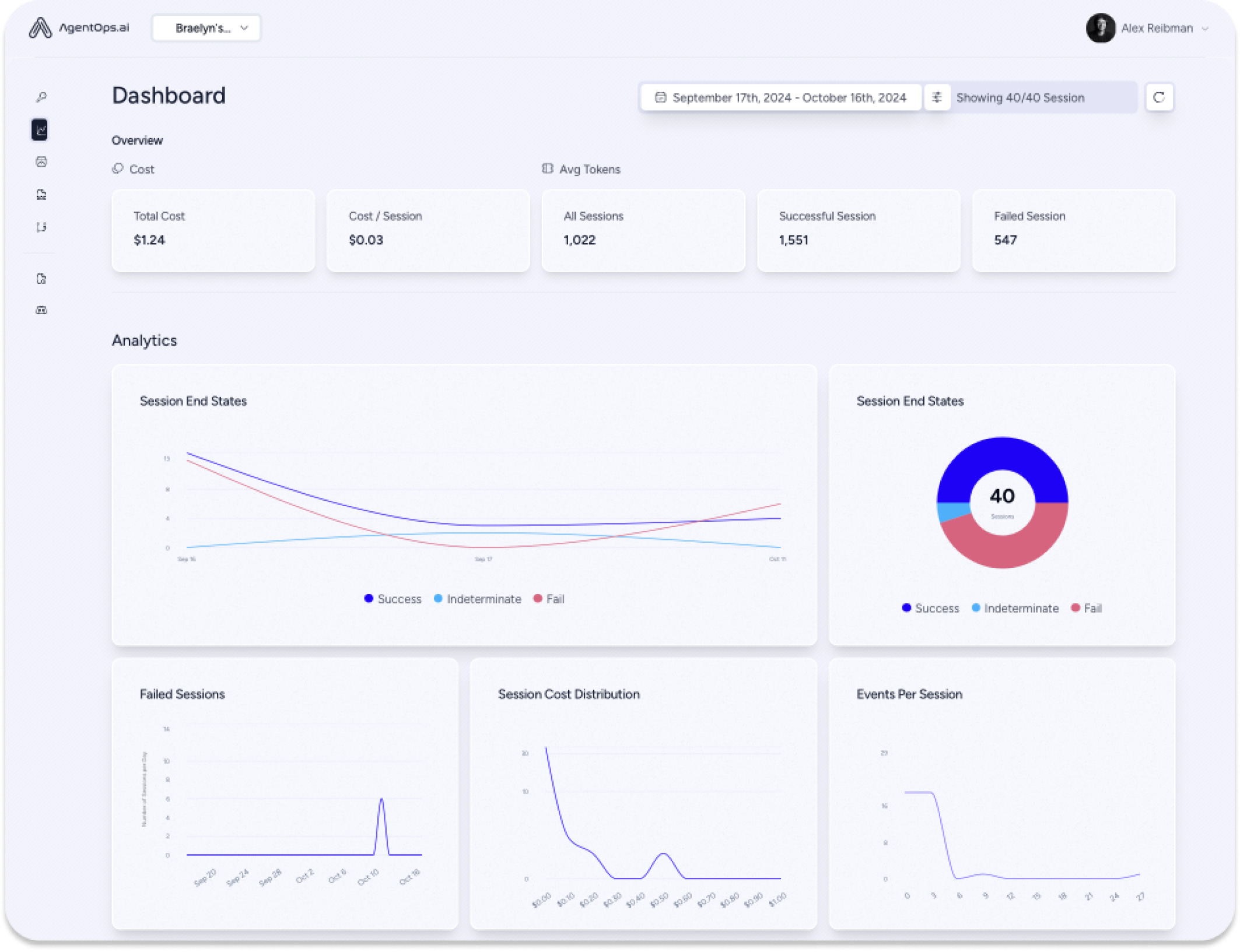

AgentOps erfasst Daten zu jeder Agenteninteraktion, nicht nur zu LLM-Aufrufen. So erhalten Sie einen umfassenden Überblick über die Funktionsweise von Multi-Agent-Systemen. Dieser Detaillierungsgrad ist für Entwicklungs- und Compliance-Teams unerlässlich und bietet wichtige Informationen für die Fehlerbehebung, Optimierung und Prüfpfade.

Die Integration von Gemini-Modellen in AgentOps ist mit LiteLLM denkbar einfach und dauert oft nur wenige Minuten. Entwickler können sich schnell einen Überblick über ihre Gemini API-Aufrufe verschaffen, Kosten in Echtzeit verfolgen und die Zuverlässigkeit ihrer Agents in der Produktion sicherstellen.

Zukunftspläne

AgentOps unterstützt Agent-Entwickler bei der Skalierung ihrer Projekte. Agency AI hilft Unternehmen, kostengünstige, skalierbare Agents zu entwickeln, und unterstreicht so den Wert der Kombination von AgentOps mit der Gemini API. Silverman betont: „Es führt dazu, dass preisbewusstere Entwickler Agents erstellen.“

Entwicklern, die Gemini in Betracht ziehen, rät Silverman: „Probieren Sie es aus. Sie werden beeindruckt sein.“