30 DE OUTUBRO DE 2024

Como levar agentes de IA para produção com a API Gemini

Criar e implantar agentes de IA é uma fronteira interessante, mas gerenciar esses sistemas complexos em um ambiente de produção exige uma capacidade de observação robusta. O AgentOps, um SDK do Python para monitoramento de agentes, rastreamento de custos de LLM, comparativos de mercado e muito mais, permite que os desenvolvedores levem os agentes do protótipo à produção, especialmente quando combinado com a potência e a relação custo-benefício da API Gemini.

A vantagem do Gemini

Adam Silverman, COO da Agency AI, a equipe por trás do AgentOps, explica que o custo é um fator crítico para as empresas que implantam agentes de IA em grande escala. "Vimos empresas gastarem US $80.000 por mês em chamadas de LLM. Com o Gemini 1.5, isso teria custado alguns milhares de dólares pela mesma saída".

Essa eficiência de custo, combinada com os recursos avançados de compreensão e geração de linguagem do Gemini, o torna uma opção ideal para desenvolvedores que criam agentes de IA sofisticados. "O Gemini 1.5 Flash oferece qualidade comparável a modelos maiores, com uma fração do custo e uma velocidade incrível", diz Silverman. Isso permite que os desenvolvedores se concentrem na criação de fluxos de trabalho de agentes complexos e com várias etapas sem se preocupar com custos excessivos.

"Já vimos execuções de agentes individuais com outros provedores de LLM custarem mais de US $500 por execução. Essas mesmas execuções com o Gemini (1.5 Flash-8B) custam menos de US $50."

Como os agentes de IA funcionam

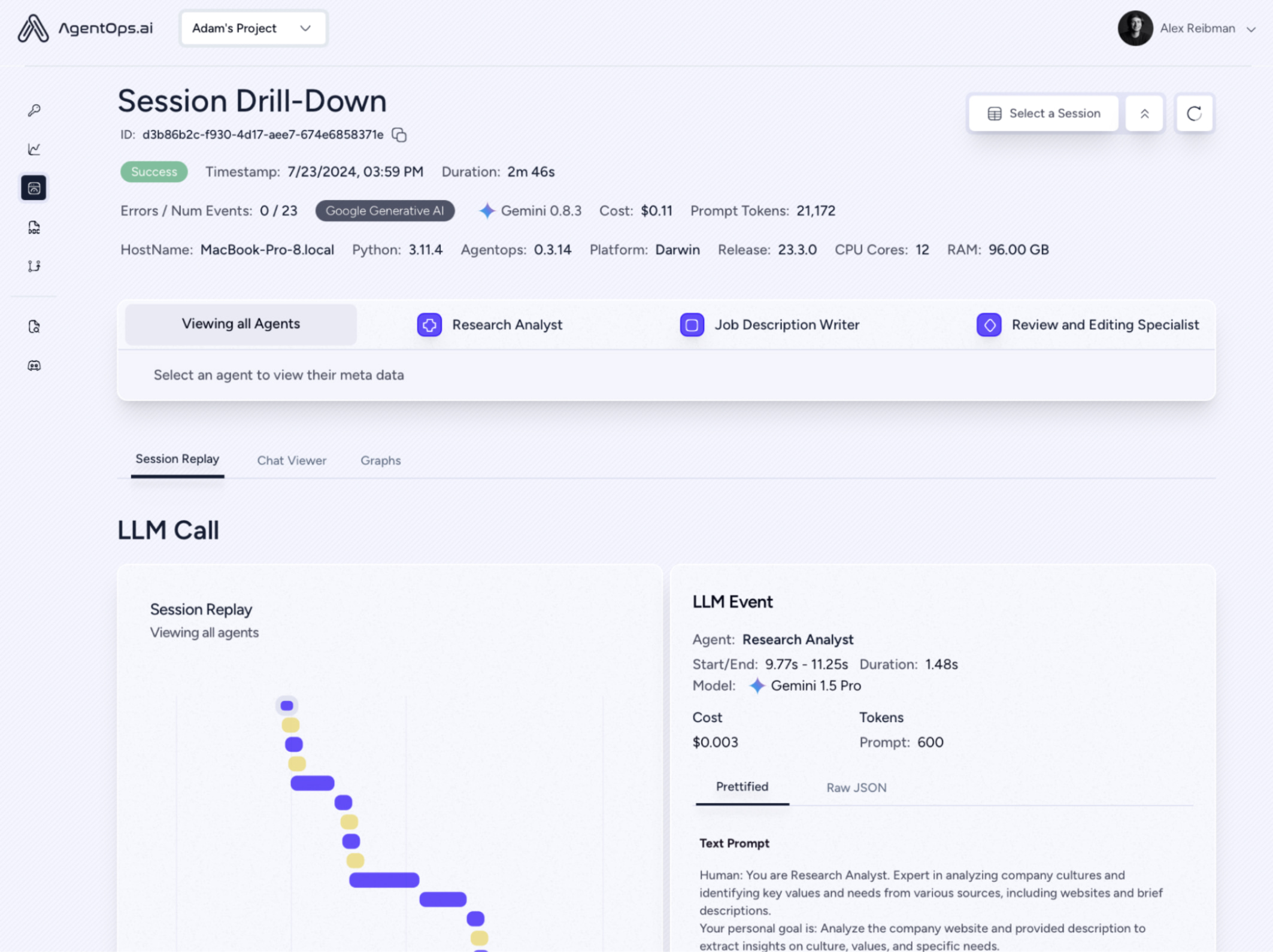

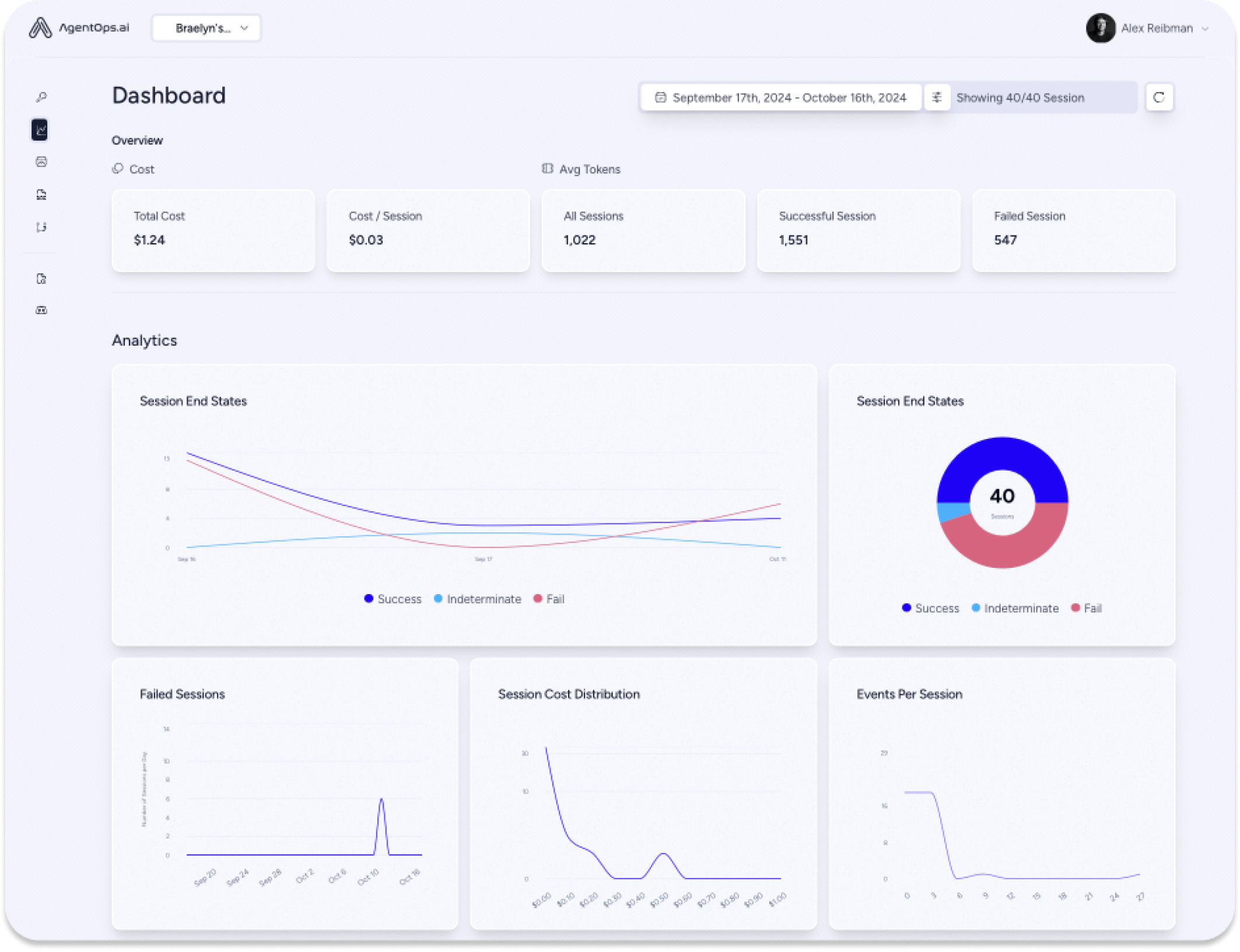

O AgentOps captura dados de todas as interações de agentes, não apenas chamadas de LLM, oferecendo uma visão abrangente de como os sistemas multiagentes operam. Esse nível granular de detalhes é essencial para as equipes de engenharia e compliance, oferecendo insights cruciais para depuração, otimização e rastros de auditoria.

A integração dos modelos do Gemini com o AgentOps é muito simples, geralmente levando apenas alguns minutos usando o LiteLLM. Os desenvolvedores podem ter visibilidade rápida das chamadas da API Gemini, acompanhar os custos em tempo real e garantir a confiabilidade dos agentes em produção.

No futuro

A AgentOps tem o compromisso de apoiar os desenvolvedores de agentes à medida que eles escalonam os projetos. A IA da agência ajuda as empresas a lidar com as complexidades da criação de agentes acessíveis e escalonáveis, consolidando ainda mais a proposta de valor de combinar o AgentOps com a API Gemini. Como enfatiza Silverman, "Isso está incentivando mais desenvolvedores preocupados com o preço a criar agentes".

Para desenvolvedores que estão pensando em usar o Gemini, o conselho de Silverman é claro: "Teste e você vai se surpreender".