2024 年 10 月 30 日

使用 Gemini API 將 AI 代理程式部署至正式環境

建構及部署 AI 代理程式是令人振奮的領域,但在正式環境中管理這些複雜系統時,需要強大的可觀測性。AgentOps 是 Python SDK,可監控代理程式、追蹤 LLM 成本、進行基準化等,協助開發人員將代理程式從原型轉移至正式環境,搭配 Gemini API 的強大功能和高成本效益,效果更佳。

Gemini 的優勢

AgentOps 背後的團隊 Agency AI 營運長 Adam Silverman 表示,對於大規模部署 AI 代理的企業而言,成本是關鍵因素。「我們發現企業每月在 LLM 呼叫上花費 $80,000 美元。如果使用 Gemini 1.5,同樣的輸出內容可能要花費幾千美元。」

Gemini 不僅經濟實惠,還具備強大的語言理解和生成能力,因此是開發人員建構進階 AI 代理程式的理想選擇。Silverman 表示:「Gemini 1.5 Flash 的品質可與大型模型相提並論,但成本僅有大型模型的一小部分,而且速度非常快。開發人員可以專心建構複雜的多步驟代理程式工作流程,不必擔心費用超出預算。

「我們發現,使用其他大型語言模型供應商的個別代理程式執行作業,每次執行費用超過 $500 美元。使用 Gemini (1.5 Flash-8B) 執行相同作業的費用不到 $50 美元。」

為 AI 代理提供支援

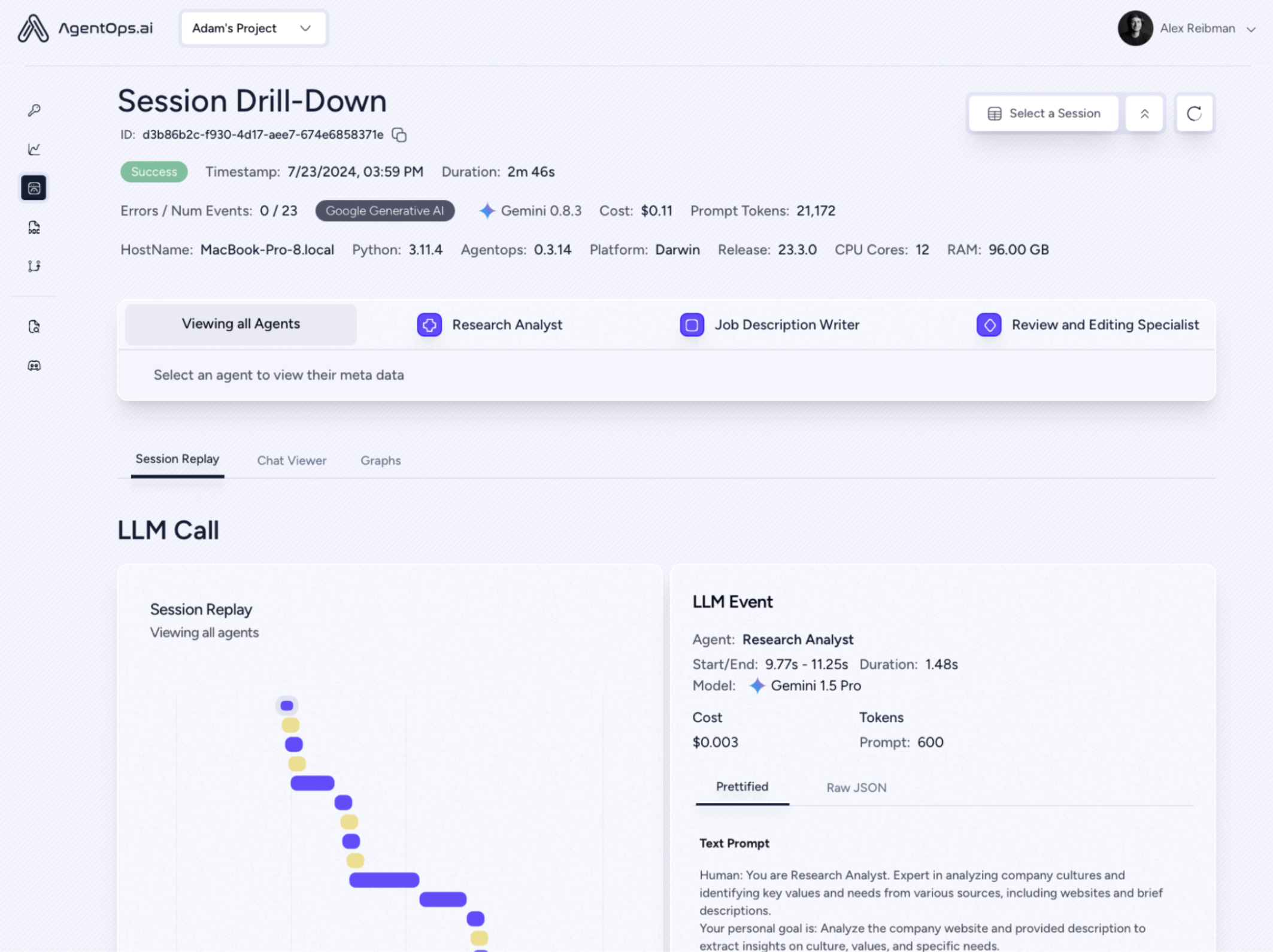

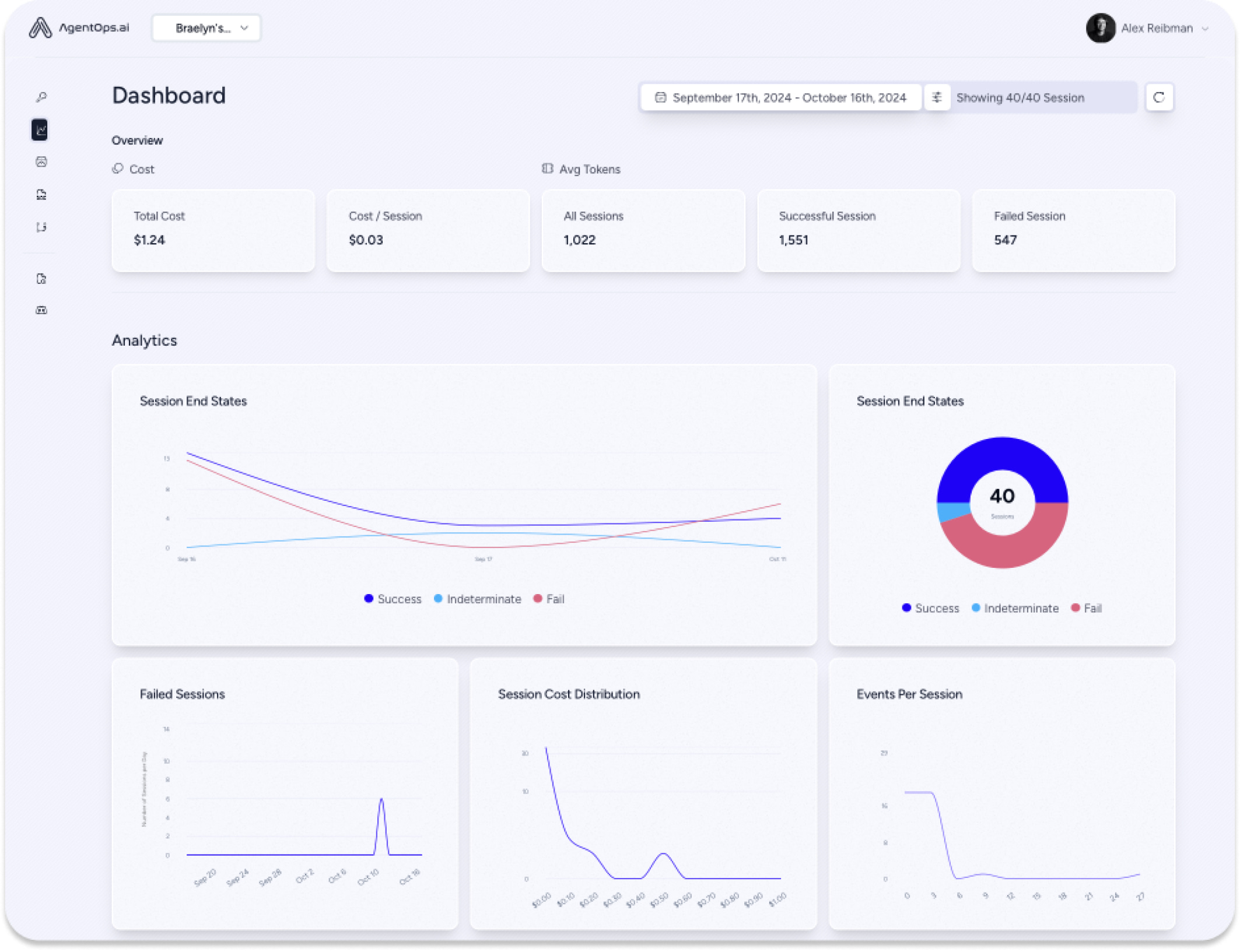

AgentOps 會擷取每個代理互動的資料 (不只是 LLM 呼叫),全面掌握多代理系統的運作方式。工程和法規團隊需要這類詳細資料,才能取得偵錯、最佳化和稽核追蹤的重要洞察。

整合 Gemini 模型與 AgentOps 非常簡單,通常只要幾分鐘就能使用 LiteLLM 完成。開發人員可以快速掌握 Gemini API 呼叫情形、即時追蹤費用,並確保代理程式在正式環境中的可靠性。

展望未來

AgentOps 致力於在專案擴大規模時,為代理程式開發人員提供支援。Agency AI 可協助企業建構經濟實惠且可擴充的代理程式,進一步鞏固 AgentOps 與 Gemini API 結合的價值主張。正如 Silverman 強調,「這項措施將吸引更多對價格敏感的開發人員建構代理程式。」

對於考慮使用 Gemini 的開發人員,Silverman 的建議很明確:「試試看,你會感到驚豔。」