3. NOVEMBER 2025

Über Text-Prompts hinaus: So hat Cartwheel mit Gemini Flash 2.5 eine positionsgetreue 3D-Generierung entwickelt

Generative Modelle haben neue Möglichkeiten für Künstler und Designer geschaffen. Für professionelle Creator bleibt es jedoch eine große Herausforderung, eine bestimmte kreative Vision in ein generiertes Bild zu übertragen. Bei Aufforderungen, die nur aus Text bestehen, ist es oft schwierig, die Pose einer Figur, den Kamerawinkel und die Komposition präzise zu steuern.

Cartwheel, eine Plattform für die KI-basierte Erstellung von 3D-Spielen und ‑Medien, geht dieses Problem an, indem sie eine neuartige Lösung auf der Grundlage der fortschrittlichen Modelle von Google entwickelt, in diesem Fall Gemini 2.5 Flash Image Nano Banana. Die Funktion „Pose Mode“ in Cartwheel Studio geht über die einfache Text-zu-Bild-Generierung hinaus, indem sie 3D-native Steuerelemente enthält, die Creatorn eine direkte, iterative Kontrolle über ihre Ausgabe ermöglichen.

Die Herausforderung: Die Lücke zwischen Intention und Ausgabe schließen

In professionellen Creative-Workflows ist Präzision unerlässlich. Künstler, Werbetreibende oder Spieledesigner müssen oft eine Figur in einer bestimmten Pose oder aus einem bestimmten Blickwinkel erstellen, damit sie in ein Storyboard oder einen Kampagnenbrief passt.

„Im Großen und Ganzen sind Bildgeneratoren schwer zu kontrollieren“, sagt Jonathan Jarvis, Mitbegründer von Cartwheel. „Es ist schwer, eine Vision zu verwirklichen, die man tatsächlich hat. Wir wollten schon immer, dass Sie den Charakter direkt bearbeiten können.“

Diese Anforderung an die direkte Bearbeitung veranlasste Cartwheel, eine multimodale Pipeline zu entwickeln, die 3D-Posing, Text-Prompts und mehrere KI-Modelle integriert, die zusammenarbeiten.

Die Lösung: eine Pipeline mit mehreren Modellen für die posentreue Generierung

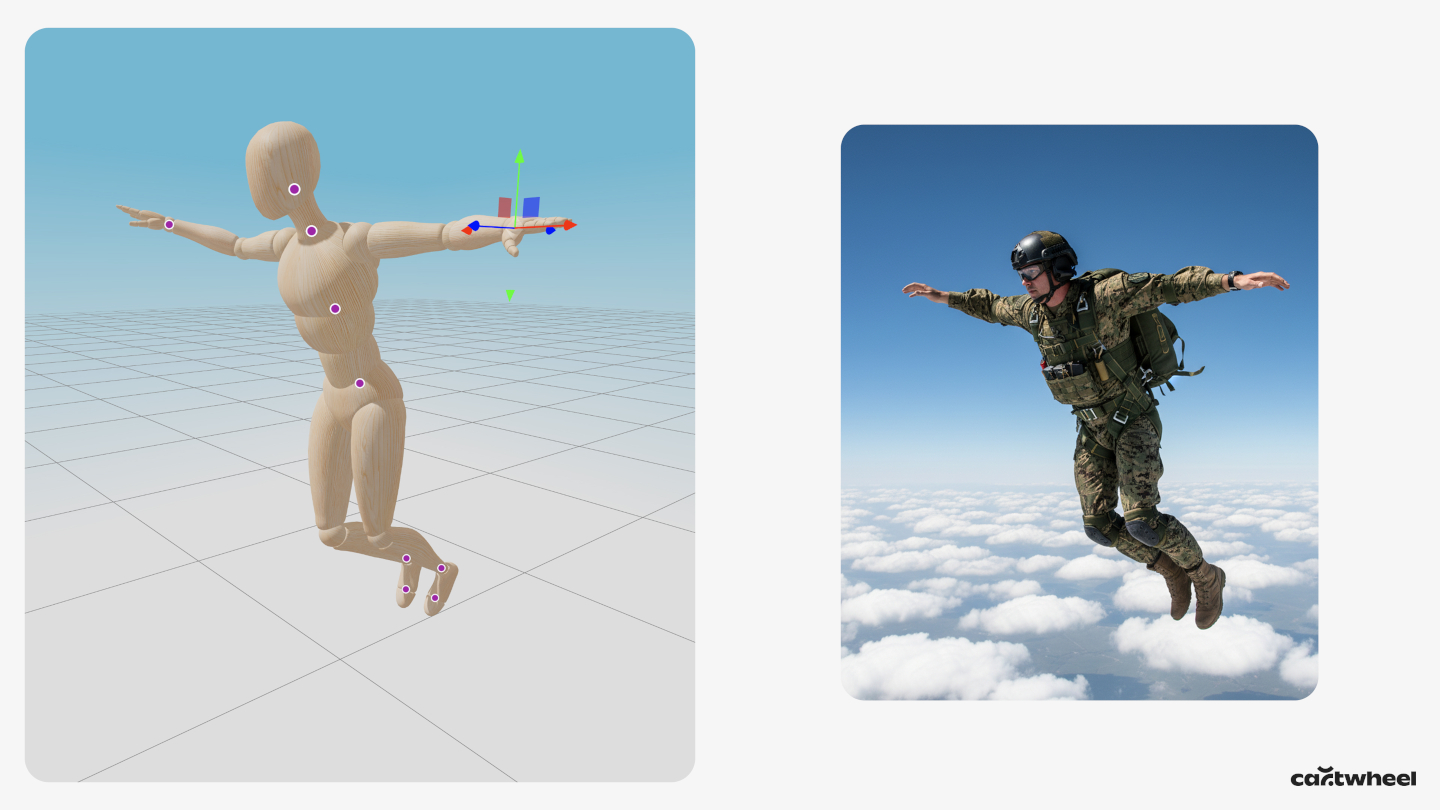

Im Posenmodus von Cartwheel wird dem Nutzer anstelle von Text eine 3D-Puppe angezeigt. Der Nutzer kann die Gliedmaßen der Schaufensterpuppe direkt per Klicken und Ziehen in eine bestimmte Pose bringen und die virtuelle Kamera in einem beliebigen Winkel ausrichten. Diese 3D-Szene wird dann zu einer primären Eingabe für den generativen Prozess.

Der technische Workflow sieht so aus:

- Posenkennzeichnung mit Gemini 2.5 Flash Zuerst wird ein Screenshot der posierten 3D-Puppe an Gemini 2.5 Flash gesendet. Cartwheel verwendet für diesen Schritt 2.5 Flash, da die Geschwindigkeit ideal für die geringe Latenz ist, die für ein Kreativtool in Echtzeit erforderlich ist. Die Aufgabe des Modells besteht darin, ein einfaches Textlabel zurückzugeben, das die Pose beschreibt, z. B. „eine Figur in einer Sprungpose“ oder „eine Figur, die grüßt“.

- Zusammenstellung multimodaler Prompts: Dieses mit 2.5 Flash generierte Posenlabel wird dann automatisch mit dem beschreibenden Text-Prompt des Nutzers kombiniert (z.B. „ein Roboter auf einem Blumenfeld“).

- Konditionierte Bildgenerierung: Schließlich wird dieser kombinierte Text-Prompt zusammen mit dem ursprünglichen Screenshot der 3D-Pose an ein hochwertiges, posentreues Bildmodell gesendet: Gemini 2.5 Flash Image. Dieser multimodale Prompt, der sowohl das Bild der Pose als auch die detaillierte Textbeschreibung enthält, sorgt dafür, dass Gemini 2.5 Flash Image ein Bild generiert, das sich streng an die Pose und den Kamerawinkel hält und gleichzeitig den künstlerischen Stil, die Figur und die Szenendetails aus dem Text übernimmt.

Durch die Verkettung von Modellen – 2.5 Flash für die visuelle Analyse und Kennzeichnung und 2.5 Flash Image für das endgültige, konditionierte Rendern – kann Cartwheel einen einzigartigen Workflow anbieten, der die intuitive Steuerung von 3D-Software mit der kreativen Leistung generativer KI kombiniert.

Die Ergebnisse: konsistente Charaktere aus jedem Blickwinkel

Mit diesem Ansatz lassen sich Bilder generieren, die zuvor nur schwer zu erstellen waren. „Die Darstellung von Charakteren aus jedem Winkel außer von vorn hat bei keinem anderen Modell funktioniert“, so Andrew Carr, Mitbegründer von Cartwheel. „Sobald du die Kamera gedreht hast, ist sie auseinandergefallen.“

Die meisten Bildmodelle werden mit Daten trainiert, die überwiegend Charaktere von vorn zeigen. Daher haben sie Schwierigkeiten, weniger häufige Kompositionen wie Aufnahmen aus der Vogelperspektive oder Ansichten von hinten zu erstellen. Da die Pose als direkte visuelle Eingabe dient, umgeht das Tool von Cartwheel diese Verzerrung der Trainingsdaten. So kann ein Künstler konsistente Charaktere aus jedem beliebigen Winkel generieren.

Dieser Workflow beschleunigt den kreativen Prozess erheblich. Eine Aufgabe, für die zuvor stundenlange iterative Prompts oder manuelles Compositing durch einen 3D-Künstler erforderlich waren, kann jetzt in Sekundenschnelle erledigt werden.

Nächste Schritte: Von statischen Bildern zu generativen Videos

Cartwheel plant bereits die nächsten Schritte für diese Technologie. Das Team experimentiert mit der Integration einer Bibliothek mit 150.000 vorkategorisierten Posen, die Nutzer durchsuchen und verfeinern können. So wird der Workflow noch weiter beschleunigt.

Langfristig soll diese Pipeline von der Pose zum Pixel auf Bewegungen ausgeweitet werden. Dieselbe 3D-Pose und dasselbe gerenderte Bild könnten als Startframe für ein Video-zu-Video-Modell wie Veo dienen. So könnte ein Creator eine Figur posieren, sie in einem beliebigen Stil rendern und dann mit einem Text-Prompt animieren. Das würde einen nahtlosen Workflow vom 3D-Posing bis zur fertigen, stilisierten Animation ermöglichen.

Cartwheel basiert auf multimodalen Modellen wie denen der Gemini-Familie und zeigt, wie Entwickler ausgefeilte Tools erstellen können, die Künstlern die Kontrolle und Konsistenz bieten, die sie benötigen. So wird generative KI von einem Tool des Zufalls zu einem Tool mit präziser kreativer Absicht.