3 de noviembre de 2025

Más allá de las instrucciones de texto: Cómo Cartwheel creó la generación 3D fiel a la pose con Gemini Flash 2.5

Los modelos generativos crearon nuevas posibilidades para artistas y diseñadores. Sin embargo, para los creadores profesionales, traducir una visión creativa específica en una imagen generada sigue siendo un desafío importante. Las instrucciones solo con texto a menudo pueden parecer una "máquina tragamonedas", lo que dificulta lograr un control preciso sobre la pose, el ángulo de la cámara y la composición de un personaje.

Cartwheel, una plataforma para la creación de juegos y contenido multimedia en 3D nativos de la IA, aborda este problema con una solución novedosa basada en los modelos avanzados de Google, en este caso, Gemini 2.5 Flash Image Nano Banana. Su función "Modo de pose" en Cartwheel Studio va más allá de la simple generación de texto a imagen, ya que incorpora controles nativos en 3D, lo que les brinda a los creadores un control directo e iterativo sobre su producción.

El desafío: cerrar la brecha entre la intención y el resultado

En los flujos de trabajo creativos profesionales, la precisión es fundamental. A menudo, un artista, un anunciante o un diseñador de juegos necesita crear un personaje en una pose específica o desde un ángulo determinado para que se ajuste a un guion gráfico o a un resumen de campaña.

"En términos generales, los generadores de imágenes han sido difíciles de controlar", dijo Jonathan Jarvis, cofundador de Cartwheel. "Es difícil lograr una visión que realmente tienes. Siempre quisimos permitirte entrar y manipular directamente al personaje".

Este requisito de manipulación directa llevó a Cartwheel a desarrollar una canalización multimodal que integra la generación de poses en 3D, instrucciones de texto y varios modelos de IA para que funcionen en conjunto.

La solución: una canalización de varios modelos para la generación fiel a la pose

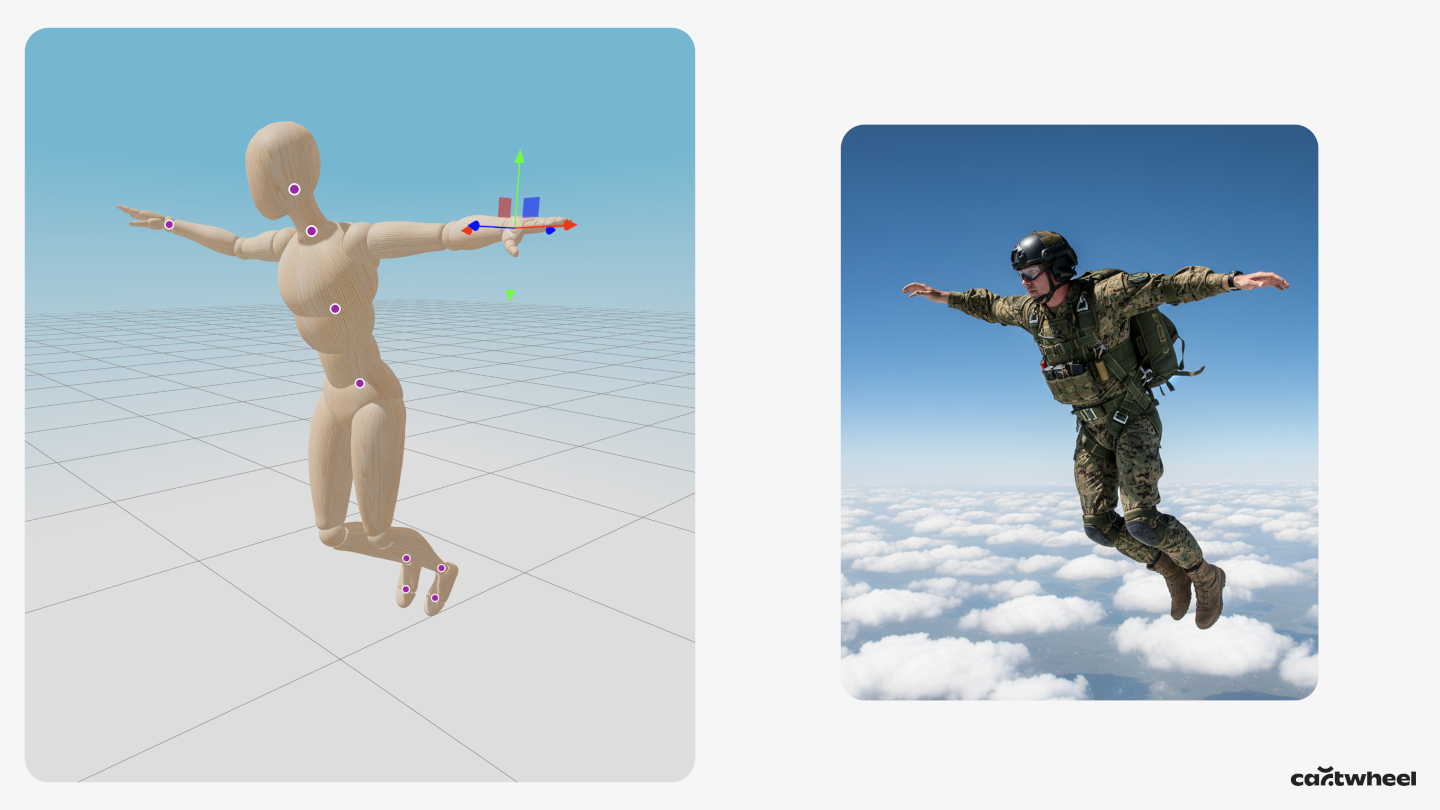

En lugar de depender únicamente del texto, el modo de pose de Cartwheel le presenta al usuario un maniquí en 3D. El usuario puede hacer clic y arrastrar directamente las extremidades del maniquí para crear una pose específica y ajustar la cámara virtual a cualquier ángulo. Luego, esta escena en 3D se convierte en una entrada principal para el proceso generativo.

El flujo de trabajo técnico es el siguiente:

- Etiquetado de poses con Gemini 2.5 Flash. Primero, se envía una captura de pantalla del maniquí 3D en pose a Gemini 2.5 Flash. Cartwheel usa 2.5 Flash para este paso, ya que su velocidad es ideal para el requisito de baja latencia de una herramienta creativa en tiempo real. La tarea del modelo es devolver una etiqueta de texto simple que describa la pose, como "un personaje en una pose de salto" o "un personaje saludando".

- Ensamblaje de instrucciones multimodales. Luego, esta etiqueta de pose generada con Flash en 2.5D se combina automáticamente con la instrucción de texto descriptivo del usuario (p.ej., "un robot en un campo de flores").

- Generación de imágenes condicionada. Por último, esta instrucción de texto combinada se envía a un modelo de imagen de alta fidelidad y fiel a la pose, Gemini 2.5 Flash Image, junto con la captura de pantalla original de la pose en 3D. Esta instrucción multimodal, que incluye la imagen de la pose y la descripción detallada del texto, condiciona a Gemini 2.5 Flash Image para que genere una imagen que se ajuste estrictamente a la pose y al ángulo de la cámara, a la vez que aplica el estilo artístico, el personaje y los detalles de la escena del texto.

Esta encadenamiento de modelos (usar 2.5 Flash para el análisis y el etiquetado visuales, y 2.5 Flash Image para la renderización final y condicionada) permite que Cartwheel ofrezca un flujo de trabajo único que combina el control intuitivo del software 3D con el poder creativo de la IA generativa.

Los resultados: desbloqueo de la coherencia de los personajes desde cualquier ángulo

Este enfoque demostró ser eficaz para generar imágenes que antes eran difíciles de crear. "Renderizar personajes desde cualquier ángulo, excepto el frontal, no funcionó en ningún otro modelo", señaló Andrew Carr, cofundador de Cartwheel. “En cuanto giraste la cámara, se desarmó”.

Debido a que la mayoría de los modelos de imágenes se entrenan con datos que incluyen principalmente personajes de frente, tienen dificultades para crear composiciones menos comunes, como tomas desde ángulos altos o vistas desde atrás. Al proporcionar la pose como entrada visual directa, la herramienta de Cartwheel evita este sesgo de los datos de entrenamiento, lo que permite que un artista genere personajes coherentes desde cualquier ángulo que elija.

Este flujo de trabajo acelera significativamente el proceso creativo. Una tarea que antes podía requerir horas de instrucciones iterativas o composición manual por parte de un artista en 3D ahora se puede completar en segundos.

Qué sigue: De imágenes estáticas a videos generativos

Cartwheel ya está planificando los próximos pasos para esta tecnología. El equipo está experimentando con la integración de una biblioteca de 150,000 poses preclasificadas que los usuarios pueden buscar y definir mejor, lo que acelera aún más el flujo de trabajo.

La visión a largo plazo es extender esta canalización de la postura al píxel al movimiento. La misma pose en 3D y la misma imagen renderizada podrían servir como fotograma inicial para un modelo de video a video, como Veo. Esto permitiría que un creador pose un personaje, lo renderice en cualquier estilo y, luego, lo anime con una instrucción de texto, lo que crearía un flujo de trabajo fluido desde la pose en 3D hasta una animación final y estilizada.

Al basarse en modelos multimodales como los de la familia de Gemini, Cartwheel demuestra cómo los desarrolladores pueden crear herramientas sofisticadas que brindan a los artistas el control y la coherencia que necesitan, lo que convierte la IA generativa en una herramienta de intención creativa precisa en lugar de una herramienta de azar.