3 NOV. 2025

Au-delà des requêtes textuelles : comment Cartwheel a créé une génération 3D fidèle aux poses avec Gemini Flash 2.5

Les modèles génératifs ont ouvert de nouvelles perspectives aux artistes et aux designers. Toutefois, pour les créateurs professionnels, traduire une vision créative spécifique en image générée reste un défi de taille. Les requêtes textuelles peuvent souvent donner l'impression de jouer à la "machine à sous", ce qui rend difficile le contrôle précis de la pose d'un personnage, de l'angle de la caméra et de la composition.

Cartwheel, une plate-forme de création de jeux et de contenus multimédias 3D basée sur l'IA, s'attaque à ce problème en développant une solution innovante basée sur les modèles avancés de Google, en l'occurrence Gemini 2.5 Flash Image Nano Banana. La fonctionnalité "Pose Mode" de Cartwheel Studio va au-delà de la simple génération d'images à partir de texte en intégrant des commandes 3D natives, ce qui permet aux créateurs de contrôler directement et de manière itérative leurs résultats.

Le défi : combler le fossé entre l'intention et le résultat

Dans les workflows de création professionnels, la précision est essentielle. Un artiste, un annonceur ou un concepteur de jeux vidéo doivent souvent créer un personnage dans une pose ou sous un angle spécifiques pour l'adapter à un storyboard ou à un brief de campagne.

"De manière générale, les générateurs d'images sont difficiles à contrôler", a déclaré Jonathan Jarvis, cofondateur de Cartwheel. "Il est difficile de réaliser une vision que vous avez réellement. Nous avons toujours voulu vous permettre d'interagir directement avec le personnage."

Cette exigence de manipulation directe a conduit Cartwheel à développer un pipeline multimodal qui intègre la pose 3D, l'invite textuelle et plusieurs modèles d'IA pour fonctionner de concert.

Solution : un pipeline multimodèle pour une génération fidèle à la pose

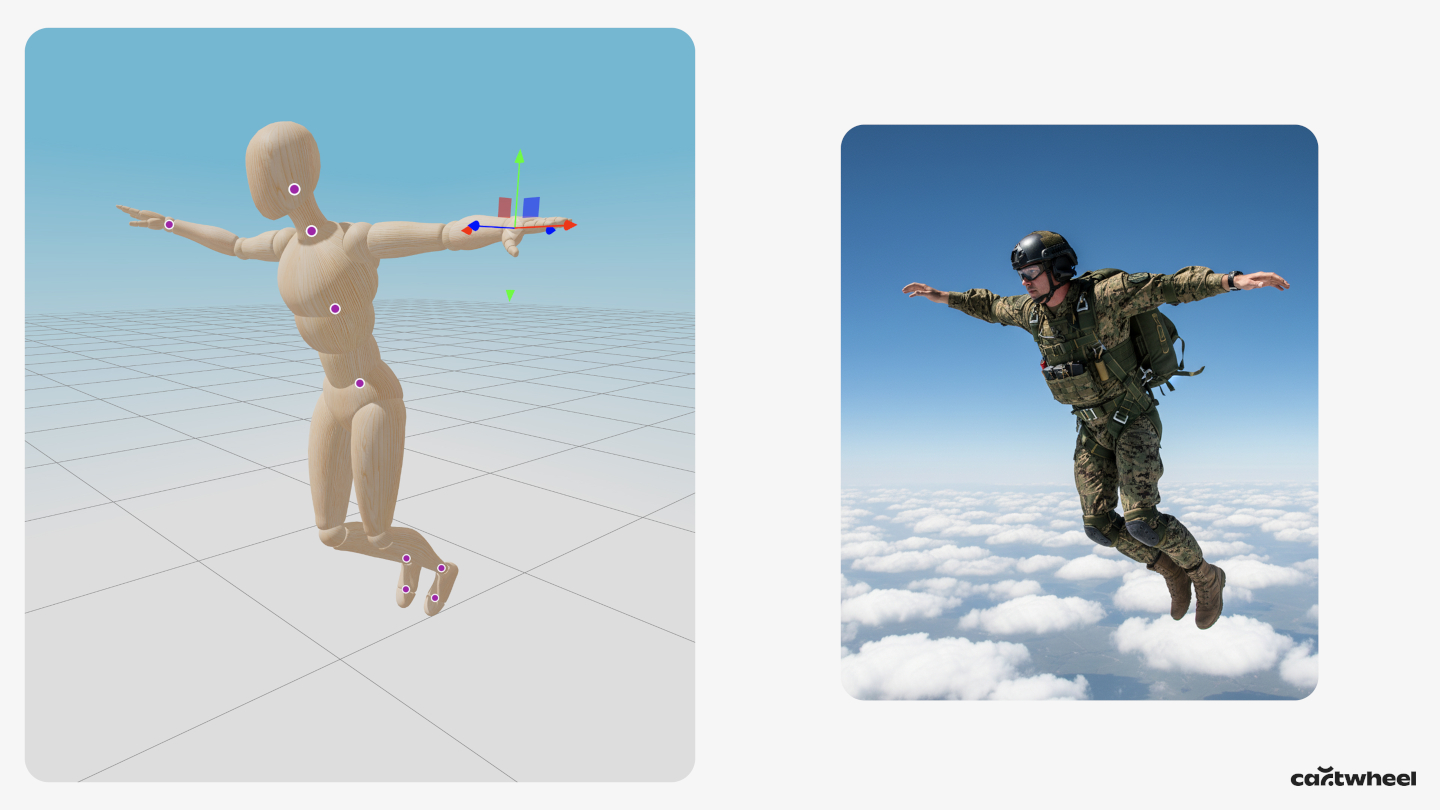

Au lieu de s'appuyer uniquement sur du texte, le mode Pose de Cartwheel présente à l'utilisateur un mannequin 3D. L'utilisateur peut directement cliquer sur les membres du mannequin et les faire glisser pour créer une pose spécifique, et ajuster la caméra virtuelle à n'importe quel angle. Cette scène 3D devient alors une entrée principale pour le processus génératif.

Le workflow technique est le suivant :

- Étiquetage des poses avec Gemini 2.5 Flash. Tout d'abord, une capture d'écran du mannequin 3D en position est envoyée à Gemini 2.5 Flash. Cartwheel utilise 2.5 Flash pour cette étape, car sa vitesse est idéale pour la faible latence requise par un outil de création en temps réel. La tâche du modèle consiste à renvoyer un libellé textuel simple décrivant la pose, par exemple "un personnage en train de sauter" ou "un personnage qui salue".

- Assemblage des requêtes multimodales. Ce libellé de pose généré par Flash 2.5 est ensuite automatiquement combiné à la propre requête textuelle descriptive de l'utilisateur (par exemple, "un robot dans un champ de fleurs").

- Génération d'images conditionnée. Enfin, ce prompt textuel combiné est envoyé à un modèle d'image haute fidélité et fidèle à la pose, Gemini 2.5 Flash Image, ainsi qu'à la capture d'écran d'origine de la pose 3D. Cette requête multimodale, qui inclut à la fois l'image de la pose et la description textuelle détaillée, conditionne Gemini 2.5 Flash Image pour générer une image qui respecte strictement la pose et l'angle de caméra, tout en appliquant le style artistique, le personnage et les détails de la scène à partir du texte.

Cet enchaînement de modèles (2.5 Flash pour l'analyse et l'étiquetage visuels, et 2.5 Flash Image pour le rendu final conditionné) permet à Cartwheel d'offrir un workflow unique qui combine le contrôle intuitif des logiciels 3D et la puissance créative de l'IA générative.

Résultats : cohérence des personnages sous tous les angles

Cette approche s'est avérée efficace pour générer des images qui étaient auparavant difficiles à créer. "Aucun autre modèle ne permettait d'afficher les personnages sous un angle autre que celui de face", a déclaré Andrew Carr, cofondateur de Cartwheel. "Dès que vous avez fait pivoter la caméra, elle s'est cassée."

La plupart des modèles d'images étant entraînés sur des données qui présentent principalement des personnages de face, ils ont du mal à créer des compositions moins courantes, comme des vues en plongée ou de dos. En fournissant la pose comme entrée visuelle directe, l'outil Cartwheel contourne ce biais de données d'entraînement, ce qui permet à un artiste de générer des personnages cohérents sous n'importe quel angle.

Ce workflow accélère considérablement le processus de création. Une tâche qui aurait pu nécessiter des heures d'itération ou de compositing manuel par un artiste 3D peut désormais être accomplie en quelques secondes.

La suite : des images statiques aux vidéos génératives

Cartwheel prévoit déjà les prochaines étapes pour cette technologie. L'équipe teste l'intégration d'une bibliothèque de 150 000 poses pré-catégorisées que les utilisateurs peuvent rechercher et affiner, ce qui accélère encore le workflow.

À long terme, l'objectif est d'étendre ce pipeline de pose à pixel au mouvement. La même pose 3D et la même image rendue peuvent servir de frame de départ pour un modèle vidéo-vers-vidéo, tel que Veo. Cela permettrait à un créateur de faire poser un personnage, de le rendre dans n'importe quel style, puis de l'animer à l'aide d'une requête textuelle, créant ainsi un workflow fluide, de la pose 3D à l'animation stylisée finale.

En s'appuyant sur des modèles multimodaux comme ceux de la famille Gemini, Cartwheel montre comment les développeurs peuvent créer des outils sophistiqués qui offrent aux artistes le contrôle et la cohérence dont ils ont besoin, en transformant l'IA générative d'un outil aléatoire en un outil d'intention créative précise.