3 NOV 2025

Oltre ai prompt di testo: come Cartwheel ha creato la generazione 3D fedele alla posa con Gemini Flash 2.5

I modelli generativi hanno creato nuove possibilità per artisti e designer. Tuttavia, per i creator professionisti, tradurre una visione creativa specifica in un'immagine generata rimane una sfida significativa. I prompt solo testuali spesso sembrano una "slot machine", il che rende difficile ottenere un controllo preciso sulla posa di un personaggio, sull'angolo di ripresa e sulla composizione.

Cartwheel, una piattaforma per la creazione di giochi e contenuti multimediali 3D basati sull'AI, sta affrontando questo problema sviluppando una nuova soluzione basata sui modelli avanzati di Google, in questo caso Gemini 2.5 Flash Image Nano Banana. La funzionalità "Modalità posa" di Cartwheel Studio va oltre la semplice generazione di testo in immagine incorporando controlli nativi 3D, offrendo ai creator un controllo diretto e iterativo sul loro output.

La sfida: colmare il divario tra intenzione e output

Nei flussi di lavoro creativi professionali, la precisione è essenziale. Un artista, un inserzionista o un game designer spesso deve creare un personaggio in una posa specifica o da un'angolazione specifica per adattarlo a uno storyboard o al brief di una campagna.

"A livello generale, i generatori di immagini sono difficili da controllare", ha affermato Jonathan Jarvis, co-fondatore di Cartwheel. "È difficile realizzare una visione che hai davvero. Abbiamo sempre voluto permetterti di entrare e manipolare direttamente il personaggio".

Questo requisito di manipolazione diretta ha portato Cartwheel a sviluppare una pipeline multimodale che integra la posa 3D, i prompt di testo e più modelli di AI per lavorare in modo coordinato.

La soluzione: una pipeline multimodello per la generazione fedele alla posa

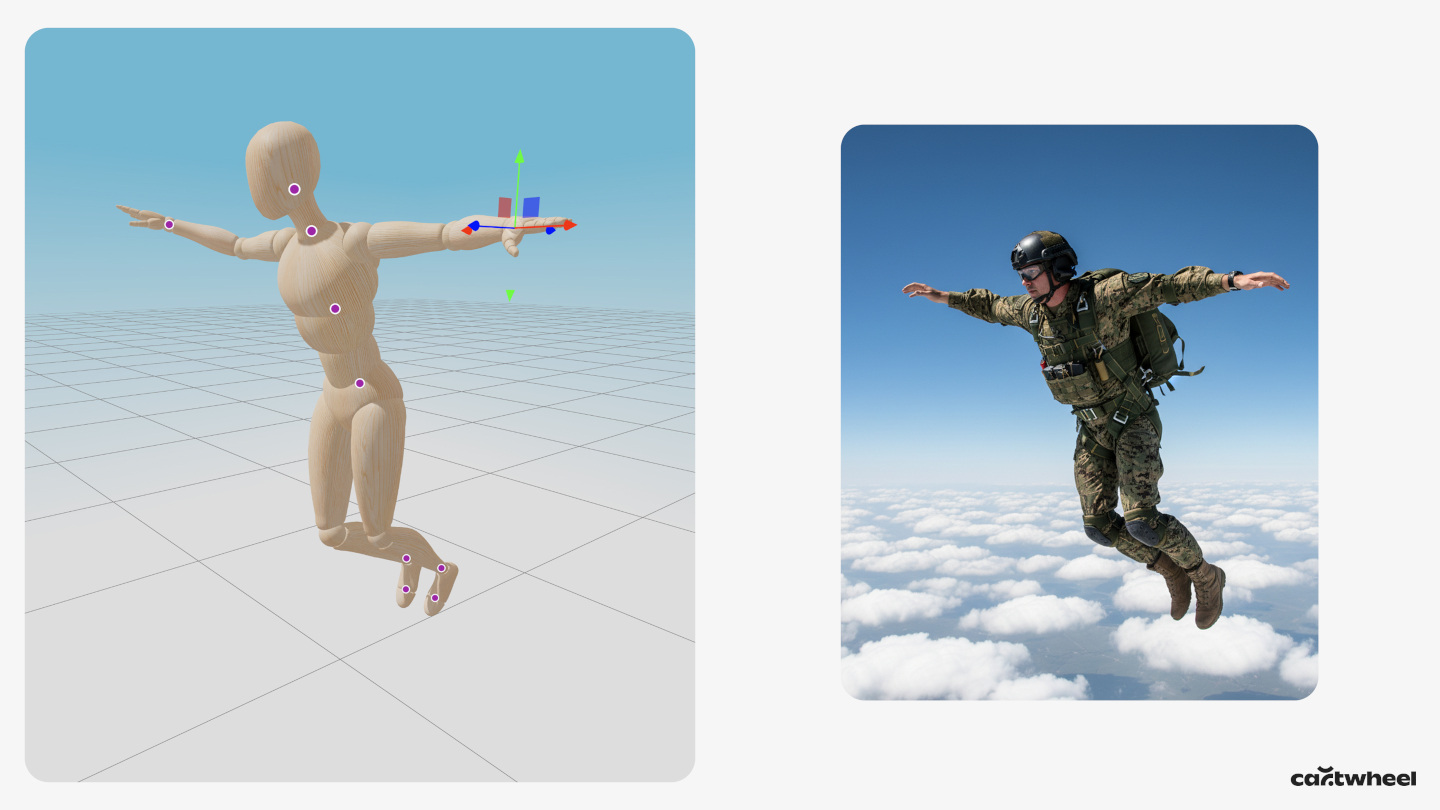

Anziché basarsi esclusivamente sul testo, la modalità Posa di Cartwheel mostra all'utente un manichino 3D. L'utente può fare clic e trascinare direttamente gli arti del manichino per creare una posa specifica e regolare la videocamera virtuale su qualsiasi angolazione. Questa scena 3D diventa quindi un input principale per il processo generativo.

Il flusso di lavoro tecnico è il seguente:

- Etichettatura della posa con Gemini 2.5 Flash. Innanzitutto, uno screenshot del manichino 3D in posa viene inviato a Gemini 2.5 Flash. Cartwheel utilizza 2.5 Flash per questo passaggio, in quanto la sua velocità è ideale per il requisito di bassa latenza di uno strumento creativo in tempo reale. Il compito del modello è restituire un'etichetta di testo semplice che descriva la posa, ad esempio "un personaggio in posa di salto" o "un personaggio che saluta".

- Assemblaggio di prompt multimodali. Questa etichetta di posa generata in Flash 2.5 viene quindi combinata automaticamente con il prompt di testo descrittivo dell'utente (ad es. "un robot in un campo di fiori").

- Generazione di immagini condizionata. Infine, questo prompt di testo combinato viene inviato a un modello di immagine ad alta fedeltà e fedele alla posa, Gemini 2.5 Flash Image, insieme allo screenshot originale della posa 3D. Questo prompt multimodale, che include sia l'immagine della posa sia la descrizione testuale dettagliata, condiziona Gemini 2.5 Flash Image a generare un'immagine che rispetti rigorosamente la posa e l'angolazione della videocamera, applicando lo stile artistico, il personaggio e i dettagli della scena del testo.

Questa concatenazione di modelli, che utilizza 2.5 Flash per l'analisi e l'etichettatura visiva e 2.5 Flash Image per il rendering finale condizionato, consente a Cartwheel di offrire un flusso di lavoro unico che combina il controllo intuitivo del software 3D con la potenza creativa dell'AI generativa.

I risultati: coerenza del personaggio da qualsiasi angolazione

Questo approccio si è dimostrato efficace nella generazione di immagini che in precedenza erano difficili da creare. "Il rendering dei personaggi da qualsiasi angolazione, tranne quella frontale, non funzionava in nessun altro modello", ha osservato Andrew Carr, co-fondatore di Cartwheel. "Appena ho ruotato la videocamera, si è rotta."

Poiché la maggior parte dei modelli di immagini viene addestrata su dati che includono in modo preponderante personaggi visti frontalmente, hanno difficoltà a creare composizioni meno comuni, come riprese dall'alto o viste da dietro. Fornendo la posa come input visivo diretto, lo strumento Cartwheel aggira questo bias dei dati di addestramento, consentendo a un artista di generare personaggi coerenti da qualsiasi angolazione scelga.

Questo flusso di lavoro accelera notevolmente il processo creativo. Un'attività che in precedenza avrebbe potuto richiedere ore di prompt iterativi o composizione manuale da parte di un artista 3D ora può essere completata in pochi secondi.

Passaggi successivi: dalle immagini statiche ai video generativi

Cartwheel sta già pianificando i prossimi passaggi per questa tecnologia. Il team sta sperimentando l'integrazione di una libreria di 150.000 pose pre-categorizzate che gli utenti possono cercare e perfezionare, velocizzando ulteriormente il flusso di lavoro.

La visione a lungo termine è quella di estendere questa pipeline di posa-pixel al movimento. La stessa posa 3D e la stessa immagine renderizzata potrebbero fungere da frame iniziale per un modello video-video, come Veo. In questo modo, un creator potrebbe posare un personaggio, eseguirne il rendering in qualsiasi stile e poi animarlo utilizzando un prompt di testo, creando un flusso di lavoro continuo dalla posa 3D all'animazione stilizzata finale.

Basandosi su modelli multimodali come quelli della famiglia Gemini, Cartwheel dimostra come gli sviluppatori possono creare strumenti sofisticati che offrono agli artisti il controllo e la coerenza di cui hanno bisogno, trasformando l'AI generativa da strumento casuale a strumento di precisa intenzione creativa.