9 เมษายน 2025

เอเจนต์ AI ที่มีปริมาณงานสูงและต้นทุนต่ำด้วย Gemini Flash ใน Langbase

การสร้างเอเจนต์ AI ที่สามารถจัดการการดำเนินการและเครื่องมือภายนอกได้โดยอัตโนมัติมักต้องผ่านอุปสรรคด้านการผสานรวมและโครงสร้างพื้นฐาน Langbase ช่วยลดภาระในการจัดการความซับซ้อนพื้นฐานเหล่านี้ โดยมีแพลตฟอร์มสำหรับสร้างและติดตั้งใช้งาน AI Agent แบบไร้เซิร์ฟเวอร์ที่ทำงานด้วยโมเดลอย่าง Gemini โดยไม่ต้องใช้เฟรมเวิร์ก

นับตั้งแต่เปิดตัว Gemini Flash ผู้ใช้ Langbase ก็ได้ตระหนักถึงข้อดีด้านประสิทธิภาพและต้นทุนของการใช้โมเดลน้ำหนักเบาเหล่านี้สำหรับประสบการณ์การใช้งานแบบเอเจนต์อย่างรวดเร็ว

การปรับขนาดและเอเจนต์ AI ที่เร็วขึ้นด้วย Gemini Flash

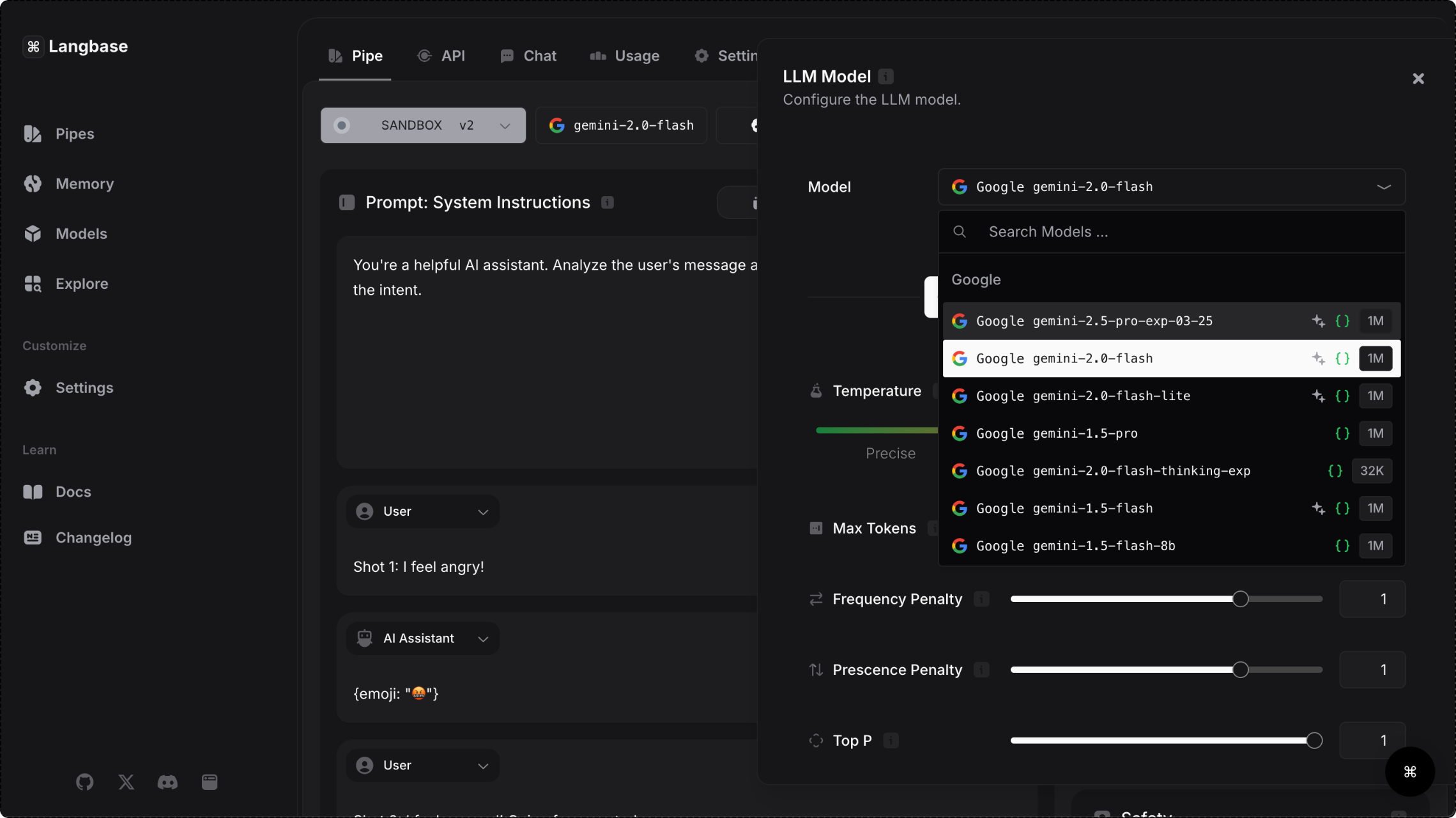

แพลตฟอร์ม Langbase ให้สิทธิ์เข้าถึงโมเดล Gemini ผ่าน Gemini API ซึ่งช่วยให้ผู้ใช้เลือกโมเดลที่รวดเร็วซึ่งสามารถจัดการงานที่ซับซ้อนและประมวลผลข้อมูลจำนวนมากได้ เนื่องจากเวลาในการตอบสนองที่ต่ำเป็นสิ่งสำคัญในการมอบประสบการณ์แบบเรียลไทม์ที่ราบรื่น โมเดล Gemini Flash จึงเหมาะอย่างยิ่งสำหรับการสร้างเอเจนต์ที่ผู้ใช้มองเห็น

นอกจากเวลาในการตอบสนองที่เร็วขึ้น 28% แล้ว ผู้ใช้แพลตฟอร์มยังพบว่าต้นทุนลดลง 50% และปริมาณงานเพิ่มขึ้น 78% สำหรับการดำเนินการเมื่อใช้ Gemini 1.5 Flash ความสามารถในการจัดการคำขอจำนวนมากโดยไม่ลดทอนประสิทธิภาพทำให้โมเดล Gemini Flash เป็นตัวเลือกที่ชัดเจนสำหรับแอปพลิเคชันที่มีความต้องการสูงในกรณีการใช้งานต่างๆ เช่น การสร้างเนื้อหาโซเชียลมีเดีย การสรุปเอกสารงานวิจัย และการวิเคราะห์เอกสารทางการแพทย์อย่างต่อเนื่อง

31.1 โทเค็น/วินาที

มีปริมาณงานสูงกว่า 78% เมื่อใช้ Flash เทียบกับโมเดลที่เทียบเท่า

7.8x

หน้าต่างบริบทที่ใหญ่ขึ้นด้วย Flash เทียบกับโมเดลที่เทียบเท่า

28%

เวลาตอบกลับที่รวดเร็วขึ้นด้วย Flash เมื่อเทียบกับรุ่นที่คล้ายกัน

50%

ลดต้นทุนด้วย Flash เมื่อเทียบกับโมเดลที่คล้ายกัน

- แหล่งที่มา: บล็อกของ Langbase

วิธีที่ Langbase ช่วยให้การพัฒนาเอเจนต์ง่ายขึ้น

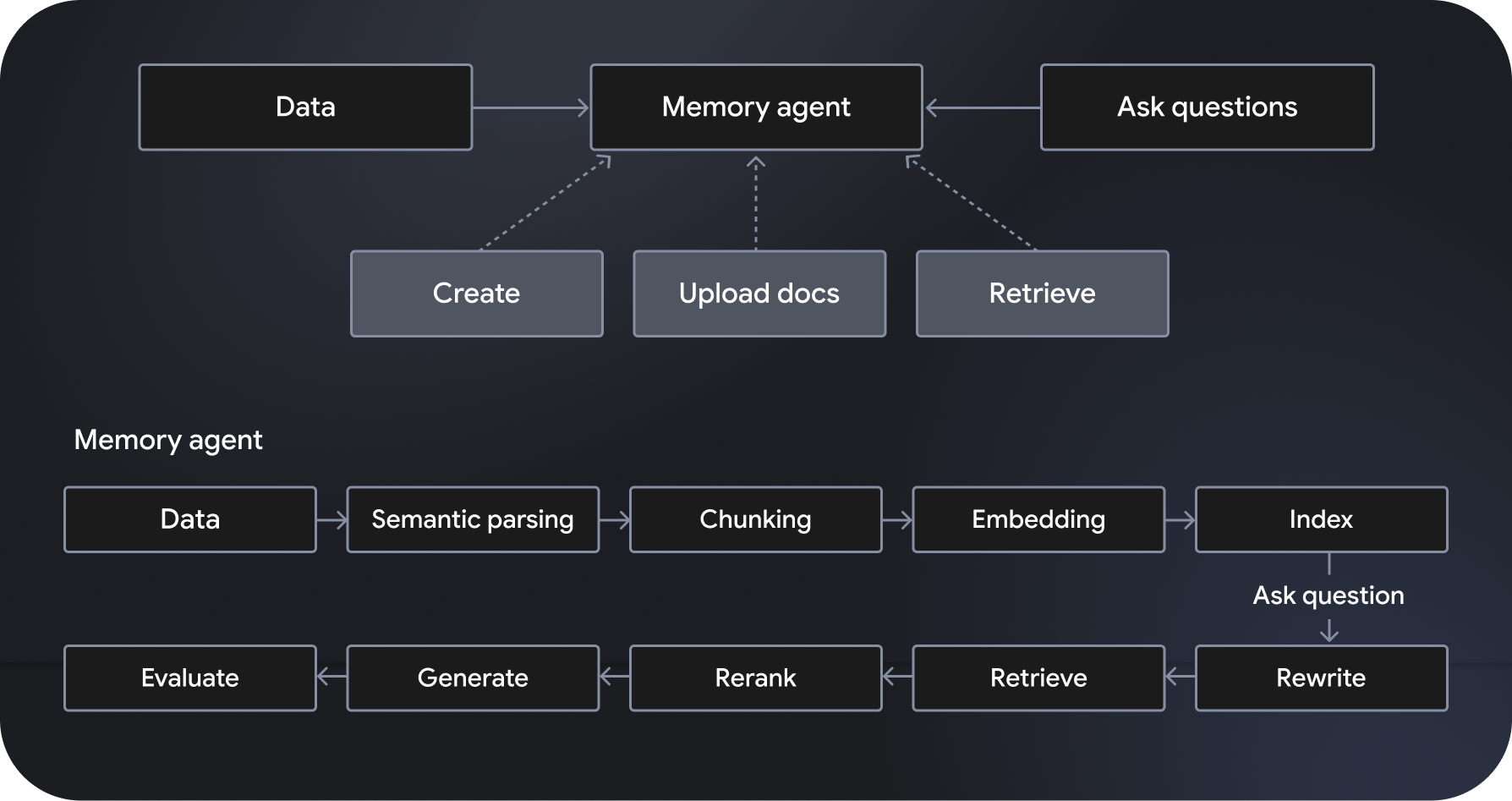

Langbase เป็นแพลตฟอร์มการพัฒนาและการติดตั้งใช้งาน AI Agent แบบ Serverless ที่สามารถประกอบได้ ซึ่งช่วยให้สร้าง AI Agent แบบ Serverless ได้ โดยมีระบบการสร้างแบบเพิ่มการดึงข้อมูลเชิงความหมาย (RAG) ที่มีการจัดการครบวงจรและปรับขนาดได้ ซึ่งเรียกว่า "เอเจนต์ความจำ" นอกจากนี้ยังมีฟีเจอร์เพิ่มเติม เช่น การจัดเวิร์กโฟลว์ การจัดการข้อมูล การจัดการการโต้ตอบของผู้ใช้ และการผสานรวมกับบริการภายนอก

"เอเจนต์ไปป์" ซึ่งขับเคลื่อนโดยโมเดลอย่าง Gemini 2.0 Flash จะปฏิบัติตามและดำเนินการตามวิธีการที่ระบุ รวมถึงมีสิทธิ์เข้าถึงเครื่องมืออันทรงพลัง เช่น การค้นหาเว็บและการ Crawl เว็บ ในทางกลับกัน เอเจนต์หน่วยความจำจะเข้าถึงข้อมูลที่เกี่ยวข้องแบบไดนามิกเพื่อสร้างคำตอบที่อิงตามข้อมูล API ของ Pipe และ Memory ของ Langbase ช่วยให้นักพัฒนาสร้างฟีเจอร์ที่มีประสิทธิภาพได้โดยการเชื่อมต่อการให้เหตุผลที่มีประสิทธิภาพกับแหล่งข้อมูลใหม่ๆ ซึ่งจะช่วยขยายความรู้และประโยชน์ของโมเดล AI

เอเจนต์ AI จะช่วยเปิดโอกาสให้แอปพลิเคชันมีประสิทธิภาพมากขึ้นด้วยการทำให้กระบวนการที่ซับซ้อนเป็นแบบอัตโนมัติ เพิ่มประสิทธิภาพเวิร์กโฟลว์ และมอบประสบการณ์ที่ปรับเปลี่ยนในแบบของผู้ใช้ การผสมผสานระหว่างการให้เหตุผลที่มีประสิทธิภาพ ต้นทุนต่ำ และความเร็วที่เร็วกว่าทำให้โมเดล Gemini Flash เป็นตัวเลือกที่ผู้ใช้ Langbase ชื่นชอบ สำรวจแพลตฟอร์มเพื่อเริ่มสร้างและติดตั้งใช้งานเอเจนต์ AI ที่มีประสิทธิภาพสูงและปรับขนาดได้