9. APRIL 2025

KI-Agents mit hohem Durchsatz und niedrigen Kosten mit Gemini Flash auf Langbase

Für die Entwicklung von KI-Agenten, die ihre Abläufe und externen Tools autonom verwalten können, müssen in der Regel Integrations- und Infrastrukturhürden überwunden werden. Langbase nimmt Ihnen die Verwaltung dieser zugrunde liegenden Komplexitäten ab und bietet eine Plattform zum Erstellen und Bereitstellen von serverlosen KI-Agenten, die auf Modellen wie Gemini basieren – und das alles ohne Framework.

Seit der Veröffentlichung von Gemini Flash haben Langbase-Nutzer schnell die Leistungs- und Kostenvorteile der Verwendung dieser schlanken Modelle für Agent-basierte Anwendungen erkannt.

Skalierbarkeit und schnellere KI-Agenten mit Gemini Flash

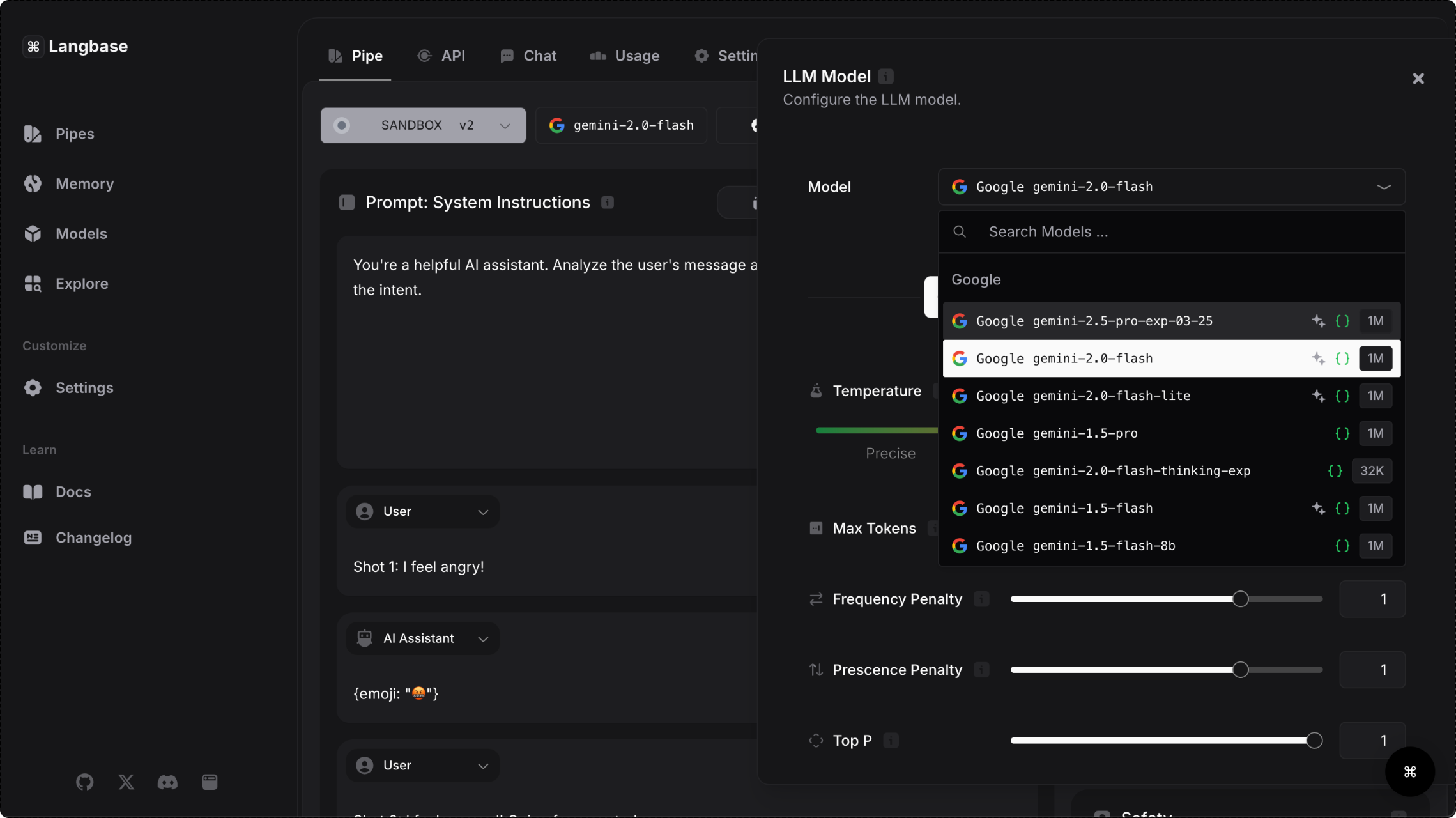

Die Langbase-Plattform bietet über die Gemini API Zugriff auf Gemini-Modelle. Nutzer können so schnelle Modelle auswählen, die komplexe Aufgaben bewältigen und große Datenmengen verarbeiten können. Da eine niedrige Latenz für eine reibungslose Echtzeit-Interaktion entscheidend ist, eignet sich die Gemini Flash-Modellfamilie besonders gut für die Entwicklung von für Nutzer sichtbaren Agenten.

Mit Gemini 1.5 Flash konnten Plattformnutzer nicht nur die Antwortzeiten um 28 % verkürzen, sondern auch die Kosten um 50 % senken und den Durchsatz um 78 % steigern. Die Fähigkeit, ein großes Anfragevolumen zu verarbeiten, ohne die Leistung zu beeinträchtigen, macht Gemini Flash-Modelle zur offensichtlichen Wahl für Anwendungen mit hoher Nachfrage für Anwendungsfälle wie die Erstellung von Social-Media-Inhalten, die Zusammenfassung von Forschungsarbeiten und die aktive Analyse medizinischer Dokumente.

31,1 Tokens/s

78 % höherer Durchsatz mit Flash im Vergleich zu vergleichbaren Modellen

7,8 x

Größeres Kontextfenster bei Flash im Vergleich zu ähnlichen Modellen

28 %

Schnellere Reaktionszeiten mit Flash im Vergleich zu ähnlichen Modellen

50 %

Geringere Kosten mit Flash im Vergleich zu vergleichbaren Modellen

- Quelle: Langbase-Blog

Wie Langbase die Entwicklung von KI-Agenten vereinfacht

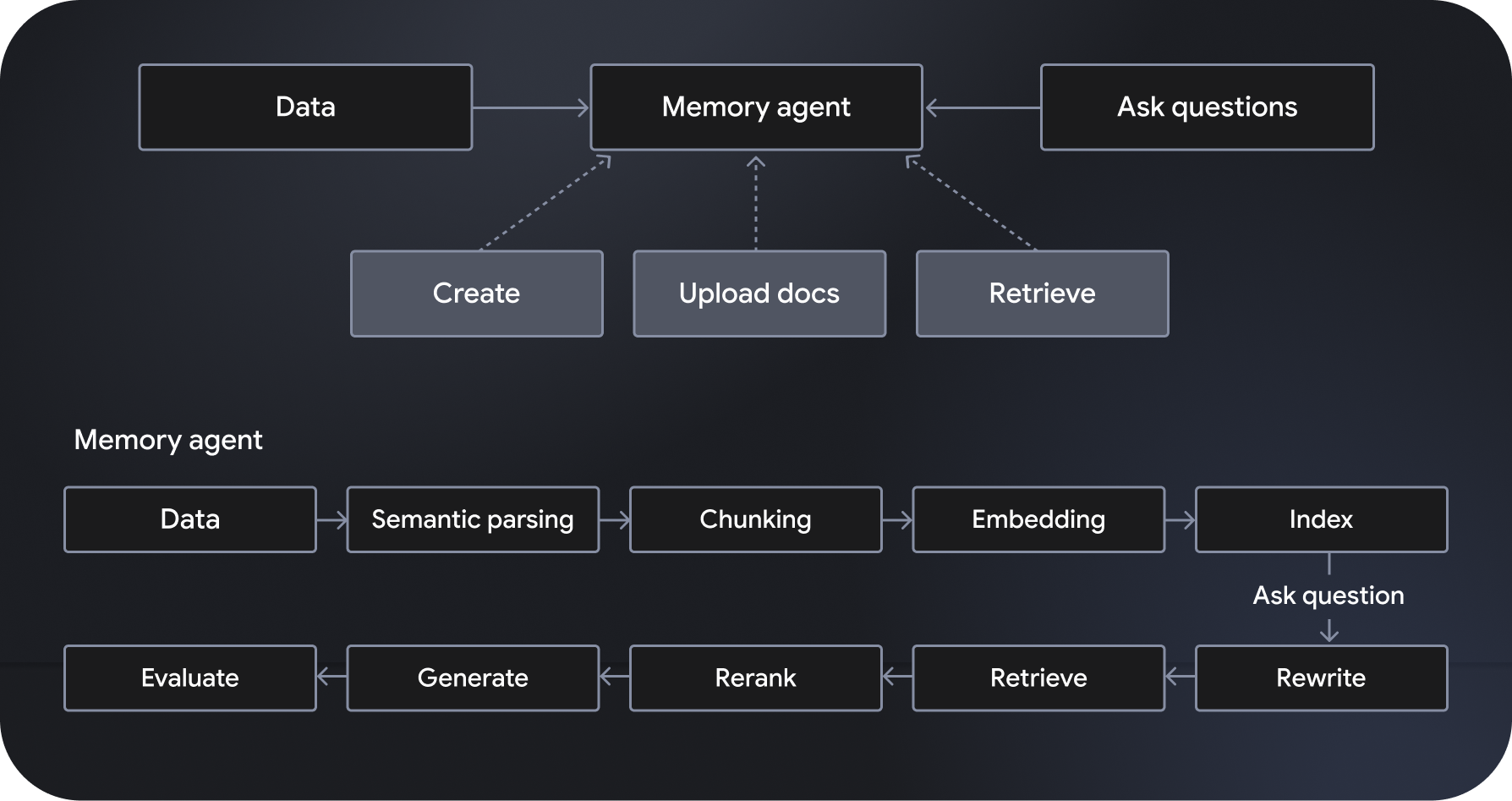

Langbase ist eine serverlose, zusammensetzbare Plattform für die Entwicklung und Bereitstellung von KI-Agenten, mit der serverlose KI-Agenten erstellt werden können. Es bietet vollständig verwaltete, skalierbare semantische RAG-Systeme (Retrieval-Augmented Generation), die als „Memory Agents“ bezeichnet werden. Zu den zusätzlichen Funktionen gehören Workflow-Orchestrierung, Datenverwaltung, Verarbeitung von Nutzerinteraktionen und Integration in externe Dienste.

„Pipe Agents“ basieren auf Modellen wie Gemini 2.0 Flash und halten sich an die angegebenen Anweisungen. Außerdem haben sie Zugriff auf leistungsstarke Tools wie die Websuche und das Web-Crawling. Memory Agents greifen hingegen dynamisch auf relevante Daten zu, um fundierte Antworten zu generieren. Mit den Pipe- und Memory-APIs von Langbase können Entwickler leistungsstarke Funktionen erstellen, indem sie leistungsstarke Schlussfolgerungen mit neuen Datenquellen verbinden und so das Wissen und die Nützlichkeit von KI-Modellen erweitern.

Durch die Automatisierung komplizierter Prozesse, die Steigerung der Workflow-Effizienz und die Bereitstellung hochgradig personalisierter Nutzererlebnisse eröffnen KI-Agenten Möglichkeiten für leistungsstärkere Anwendungen. Die Kombination aus leistungsstarker Schlussfolgerung, niedrigen Kosten und hoher Geschwindigkeit macht Gemini Flash-Modelle zur bevorzugten Wahl für Langbase-Nutzer. Plattform für die Entwicklung und Bereitstellung hocheffizienter, skalierbarer KI-Agents