9 AVRIL 2025

Agents d'IA à haut débit et à faible coût avec Gemini Flash sur Langbase

Pour créer des agents d'IA capables de gérer de manière autonome leurs opérations et leurs outils externes, il faut généralement surmonter des obstacles liés à l'intégration et à l'infrastructure. Langbase élimine la charge de gestion de ces complexités sous-jacentes, en fournissant une plate-forme permettant de créer et de déployer des agents d'IA sans serveur optimisés par des modèles tels que Gemini, le tout sans framework.

Depuis la sortie de Gemini Flash, les utilisateurs de Langbase ont rapidement compris les avantages en termes de performances et de coûts liés à l'utilisation de ces modèles légers pour les expériences agentiques.

Obtenir des agents d'IA plus rapides et évolutifs avec Gemini Flash

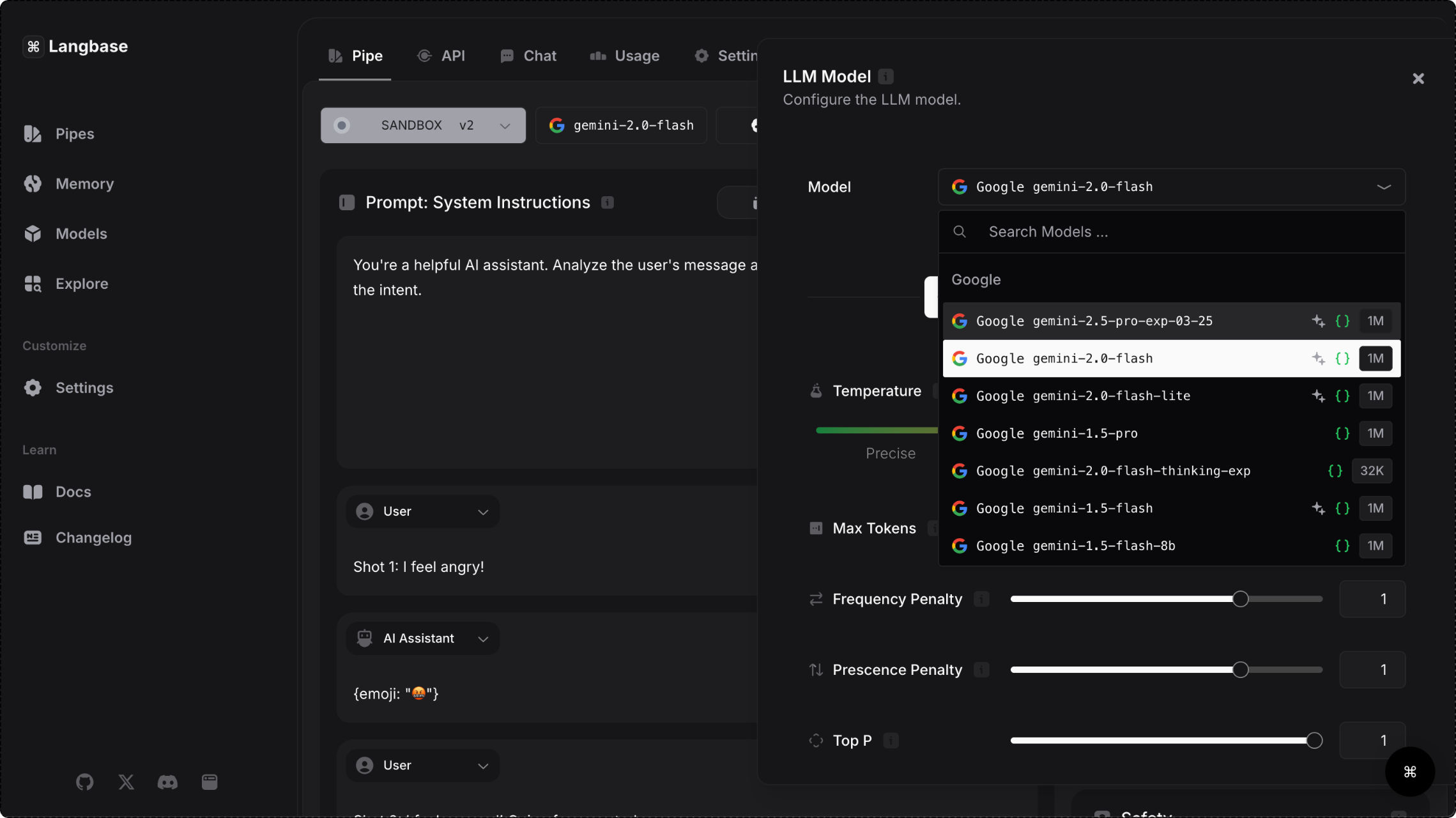

La plate-forme Langbase donne accès aux modèles Gemini via l'API Gemini, ce qui permet aux utilisateurs de choisir des modèles rapides capables de gérer des tâches complexes et de traiter de grandes quantités de données. La faible latence étant essentielle pour offrir une expérience fluide en temps réel, la famille de modèles Gemini Flash est particulièrement adaptée à la création d'agents destinés aux utilisateurs.

En plus de bénéficier de temps de réponse 28 % plus rapides, les utilisateurs de la plate-forme ont constaté une réduction de 50 % des coûts et une augmentation de 78 % du débit de leurs opérations lorsqu'ils ont utilisé Gemini 1.5 Flash. La capacité à gérer un grand volume de requêtes sans compromettre les performances fait des modèles Gemini Flash un choix évident pour les applications à forte demande, dans des cas d'utilisation tels que la création de contenu pour les réseaux sociaux, la synthèse de documents de recherche et l'analyse active de documents médicaux.

31,1 jetons/s

Débit 78 % plus élevé avec Flash qu'avec les modèles comparables

x7,8

Fenêtre de contexte plus grande avec Flash par rapport aux modèles comparables

28 %

Temps de réponse plus rapides avec Flash qu'avec les modèles comparables

50 %

Coûts inférieurs avec Flash par rapport aux modèles comparables

- source : blog Langbase

Comment Langbase simplifie le développement d'agents

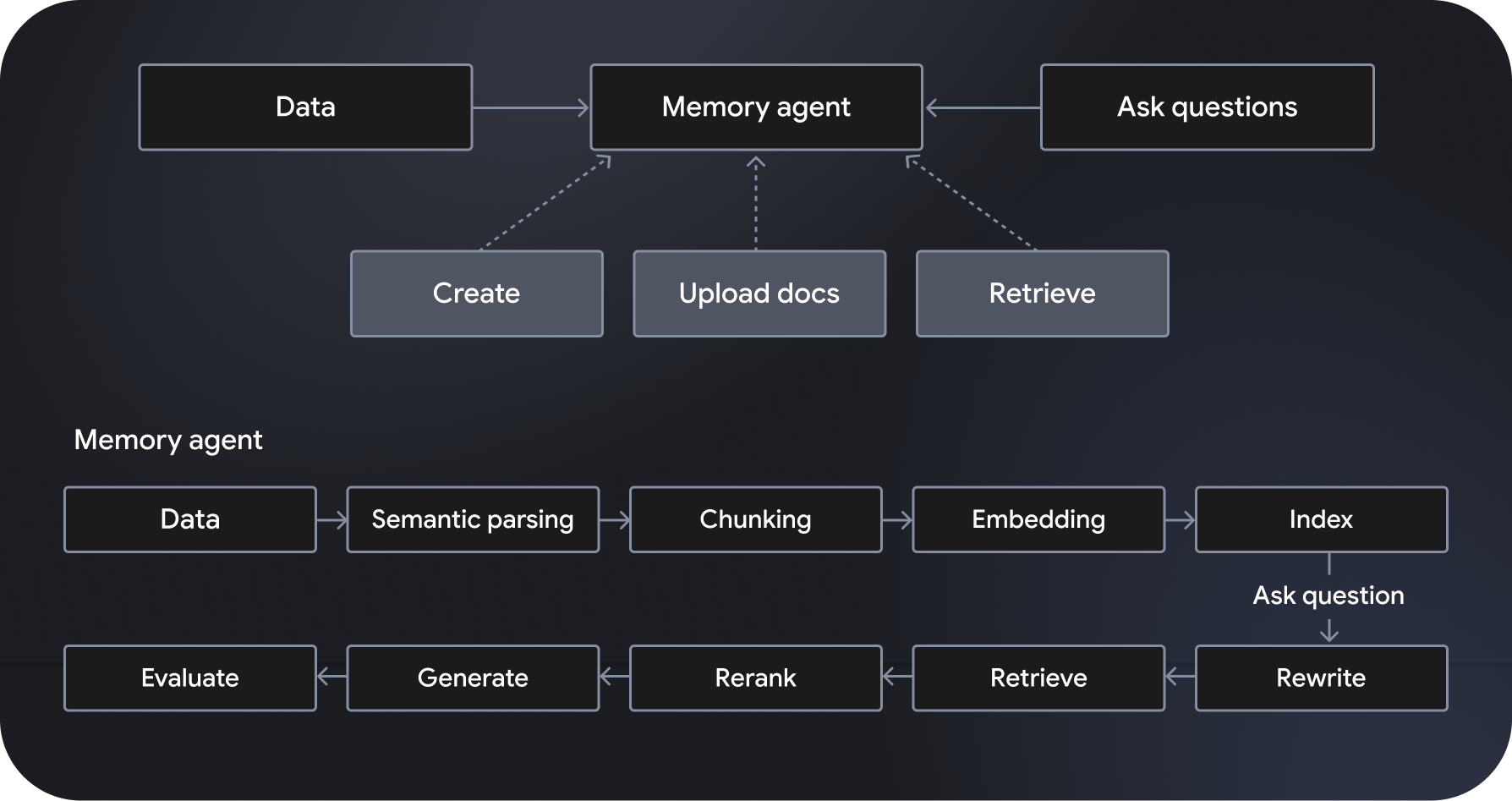

Langbase est une plate-forme de développement et de déploiement d'agents d'IA composables et sans serveur qui permet de créer des agents d'IA sans serveur. Il propose des systèmes de génération augmentée par récupération (RAG) sémantiques évolutifs et entièrement gérés, appelés agents de mémoire. Il inclut également des fonctionnalités d'orchestration de workflow, de gestion des données, de gestion des interactions utilisateur et d'intégration à des services externes.

Optimisés par des modèles tels que Gemini 2.0 Flash, les agents de pipeline respectent et appliquent des instructions spécifiques, et ont accès à des outils puissants, y compris la recherche et l'exploration Web. En revanche, les agents de mémoire accèdent de manière dynamique aux données pertinentes pour générer des réponses ancrées. Les API Pipe et Memory de Langbase permettent aux développeurs de créer des fonctionnalités puissantes en connectant un raisonnement puissant à de nouvelles sources de données, ce qui élargit les connaissances et l'utilité des modèles d'IA.

En automatisant les processus complexes, en améliorant l'efficacité des workflows et en offrant aux utilisateurs des expériences hautement personnalisées, les agents d'IA ouvrent la voie à des applications plus puissantes. Grâce à leur puissant raisonnement, à leur faible coût et à leur rapidité, les modèles Gemini Flash sont le choix privilégié des utilisateurs de Langbase. Explorez la plate-forme pour commencer à créer et à déployer des agents d'IA évolutifs et très efficaces.