2025년 4월 9일

Langbase의 Gemini Flash를 사용한 고처리량 저비용 AI 에이전트

운영 및 외부 도구를 자율적으로 관리할 수 있는 AI 에이전트를 빌드하려면 일반적으로 통합 및 인프라 장애물을 해결해야 합니다. Langbase는 이러한 기본 복잡성을 관리하는 부담을 없애고 프레임워크 없이 Gemini와 같은 모델로 구동되는 서버리스 AI 에이전트를 생성하고 배포할 수 있는 플랫폼을 제공합니다.

Gemini Flash가 출시된 이후 Langbase 사용자는 에이전트 경험에 이러한 경량 모델을 사용할 때의 성능 및 비용 이점을 빠르게 깨달았습니다.

Gemini Flash로 확장성과 더 빠른 AI 에이전트 구현

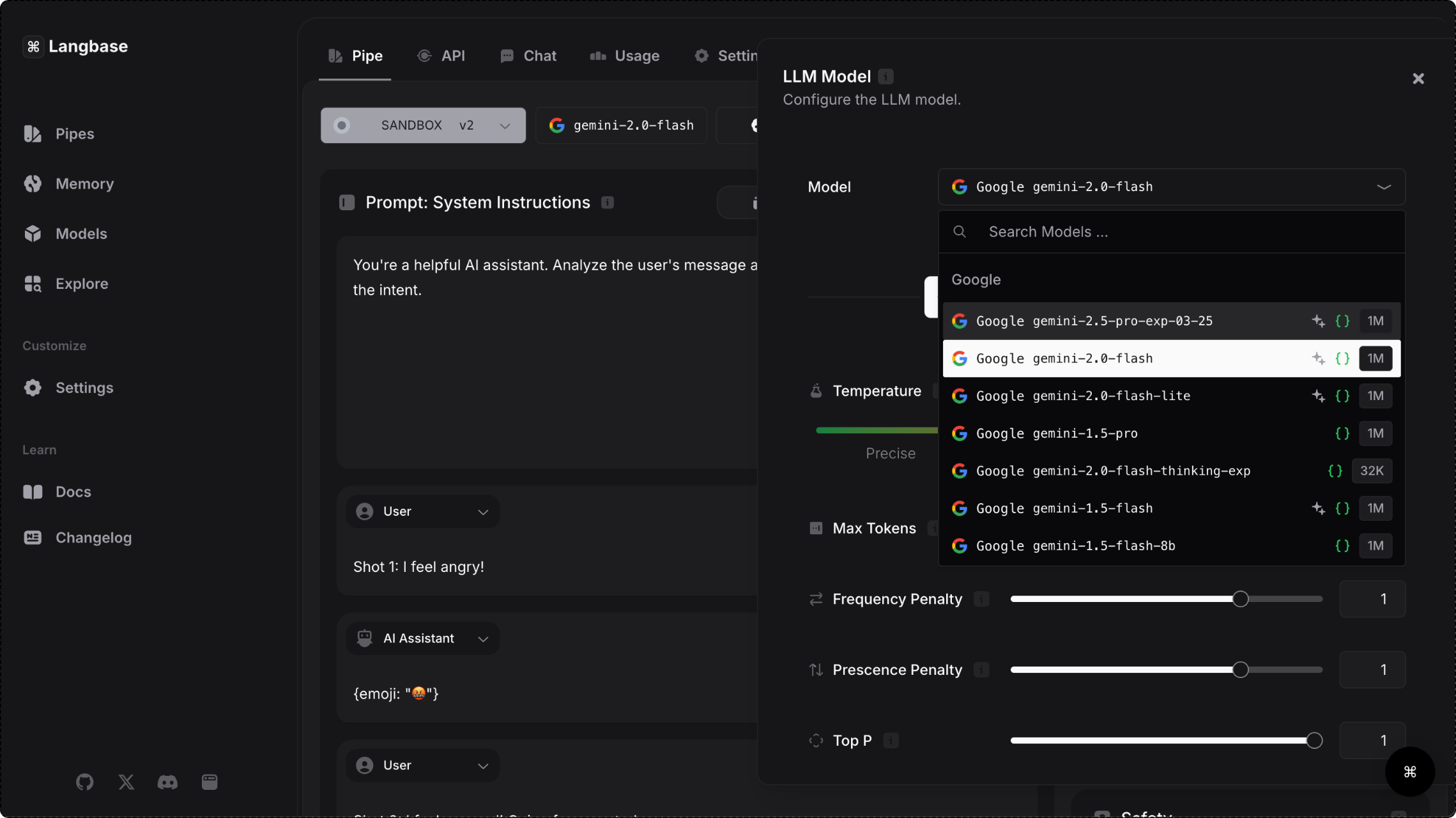

Langbase 플랫폼은 Gemini API를 통해 Gemini 모델에 대한 액세스를 제공하므로 사용자는 복잡한 작업을 처리하고 방대한 양의 데이터를 처리할 수 있는 빠른 모델을 선택할 수 있습니다. 원활한 실시간 환경을 제공하는 데 지연 시간이 매우 중요하므로 Gemini Flash 모델 제품군은 사용자 대상 에이전트를 빌드하는 데 특히 적합합니다.

Gemini 1.5 Flash를 사용하면 플랫폼 사용자의 응답 시간이 28% 빨라질 뿐만 아니라 운영 비용이 50% 절감되고 처리량이 78% 증가합니다. 성능 저하 없이 대량의 요청을 처리할 수 있는 Gemini Flash 모델은 소셜 미디어 콘텐츠 제작, 연구 논문 요약, 의료 문서의 능동적 분석과 같은 사용 사례를 위한 수요가 많은 애플리케이션에 적합합니다.

31.1토큰/초

Flash를 사용하면 유사한 모델에 비해 처리량이 78% 증가

7.8배

Flash와 유사한 모델의 컨텍스트 윈도우 비교

28%

Flash의 응답 시간이 유사한 모델보다 빠름

50%

Flash를 사용하면 유사한 모델에 비해 비용이 절감됩니다.

- 출처: Langbase 블로그

Langbase로 에이전트 개발을 간소화하는 방법

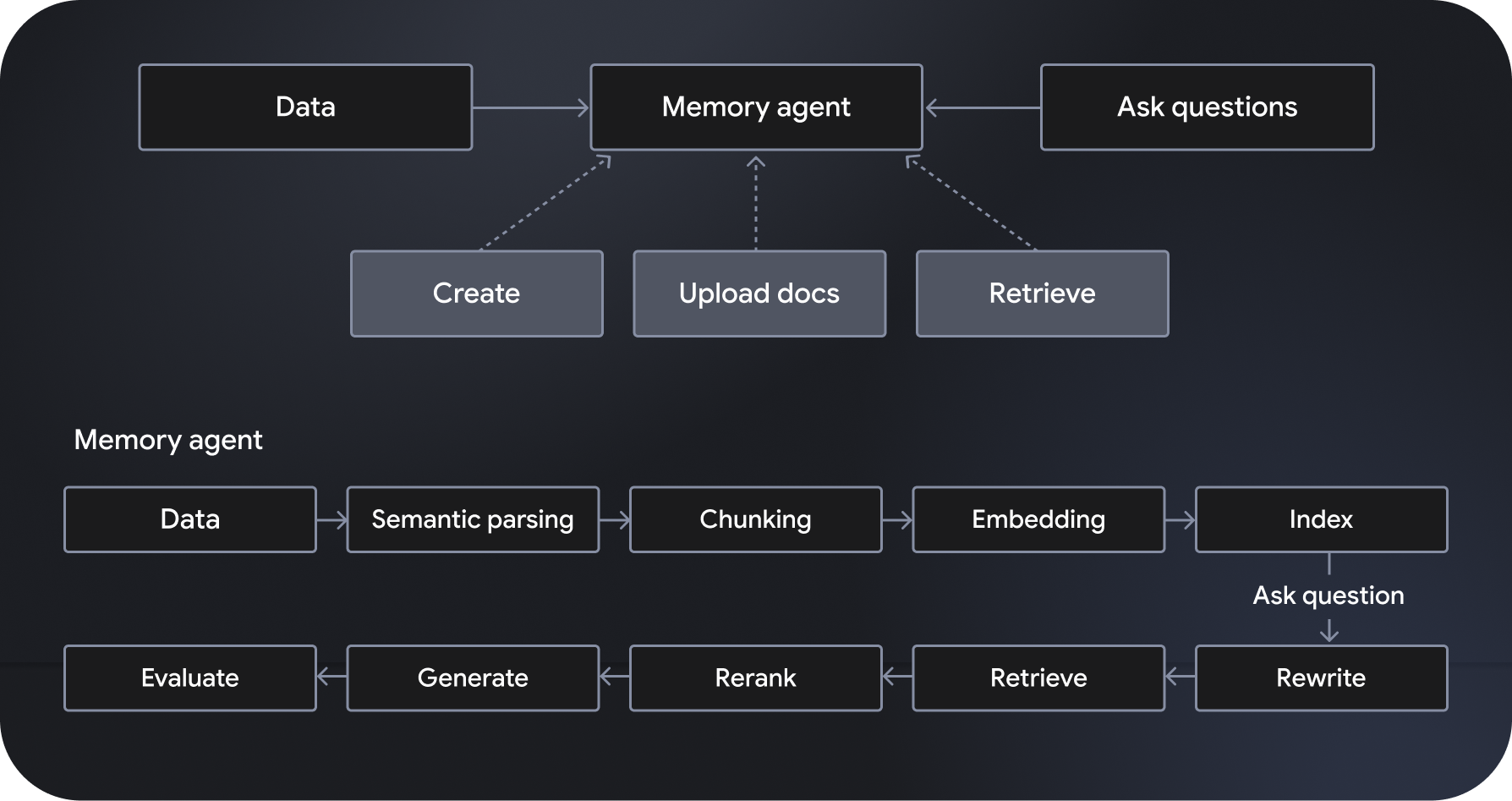

Langbase는 서버리스 AI 에이전트 생성을 지원하는 서버리스 컴포저블 AI 에이전트 개발 및 배포 플랫폼입니다. '메모리 에이전트'라고 하는 완전 관리형의 확장 가능한 시맨틱 검색 증강 생성 (RAG) 시스템을 제공합니다. 추가 기능으로는 워크플로 조정, 데이터 관리, 사용자 상호작용 처리, 외부 서비스와의 통합이 있습니다.

Gemini 2.0 Flash와 같은 모델을 기반으로 하는 '파이프 에이전트'는 지정된 안내를 준수하고 이에 따라 행동하며 웹 검색 및 웹 크롤링을 비롯한 강력한 도구에 액세스할 수 있습니다. 반면 메모리 에이전트는 관련 데이터에 동적으로 액세스하여 그라운딩된 대답을 생성합니다. Langbase의 파이프 및 메모리 API를 사용하면 강력한 추론을 새로운 데이터 소스에 연결하여 개발자가 강력한 기능을 빌드하고 AI 모델의 지식과 유용성을 확장할 수 있습니다.