۹ آوریل ۲۰۲۵

عاملهای هوش مصنوعی با توان عملیاتی بالا و هزینه کم با Gemini Flash در Langbase

ساختن عاملهای هوش مصنوعی که بتوانند به طور مستقل عملیات و ابزارهای خارجی خود را مدیریت کنند، معمولاً نیازمند عبور از موانع ادغام و زیرساخت است. Langbase بار مدیریت این پیچیدگیهای اساسی را از بین میبرد و بستری را برای ایجاد و استقرار عاملهای هوش مصنوعی بدون سرور که توسط مدلهایی مانند Gemini پشتیبانی میشوند، بدون هیچ چارچوبی فراهم میکند.

از زمان انتشار Gemini Flash ، کاربران Langbase به سرعت متوجه مزایای عملکرد و هزینه استفاده از این مدلهای سبک برای تجربیات عاملمحور شدهاند.

دستیابی به مقیاسپذیری و عاملهای هوش مصنوعی سریعتر با Gemini Flash

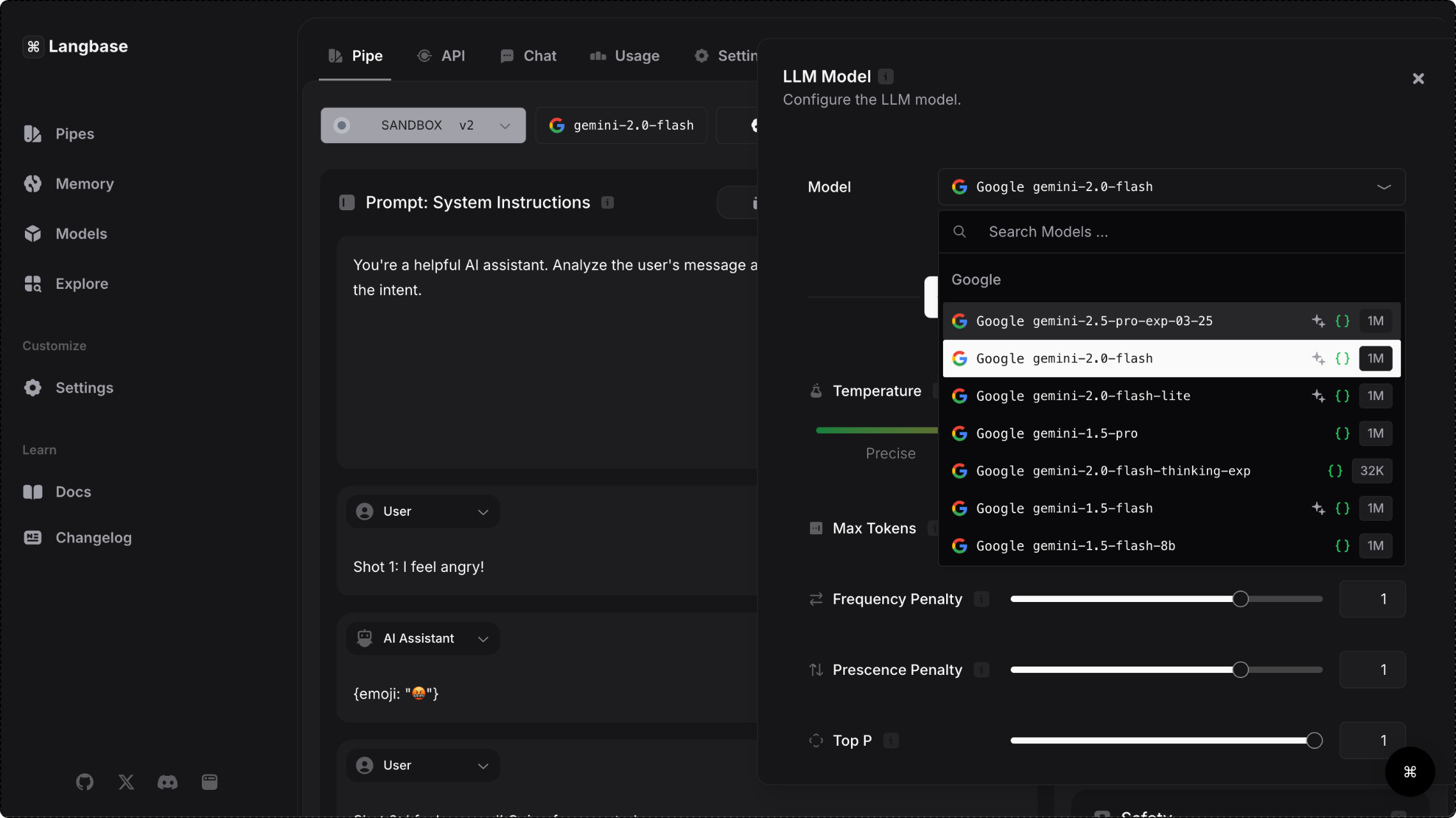

پلتفرم Langbase از طریق رابط برنامهنویسی نرمافزار Gemini ، دسترسی به مدلهای Gemini را فراهم میکند و به کاربران این امکان را میدهد تا مدلهای سریعی را انتخاب کنند که میتوانند وظایف پیچیده را انجام دهند و حجم عظیمی از دادهها را پردازش کنند. با توجه به اینکه تأخیر کم برای ارائه یک تجربه روان و بلادرنگ بسیار مهم است، خانواده مدلهای Gemini Flash به ویژه برای ساخت عوامل کاربرپسند مناسب هستند.

علاوه بر ۲۸٪ زمان پاسخگویی سریعتر، کاربران پلتفرم هنگام استفاده از Gemini 1.5 Flash، کاهش ۵۰٪ در هزینهها و افزایش ۷۸٪ در توان عملیاتی خود را تجربه کردند. توانایی رسیدگی به حجم زیادی از درخواستها بدون به خطر انداختن عملکرد، مدلهای Gemini Flash را به انتخابی بدیهی برای برنامههای کاربردی با تقاضای بالا برای مواردی مانند تولید محتوای رسانههای اجتماعی، خلاصهسازی مقالات تحقیقاتی و تجزیه و تحلیل فعال اسناد پزشکی تبدیل میکند.

۳۱.۱ توکن در ثانیه

۷۸٪ افزایش توان عملیاتی با فلش در مقایسه با مدلهای مشابه

۷.۸ برابر

پنجره زمینه بزرگتر با فلش در مقایسه با مدلهای مشابه

۲۸٪

زمان پاسخدهی سریعتر با فلش در مقایسه با مدلهای مشابه

۵۰٪

هزینههای کمتر با فلش در مقایسه با مدلهای مشابه

- منبع: وبلاگ Langbase

چگونه Langbase توسعه عامل را ساده میکند

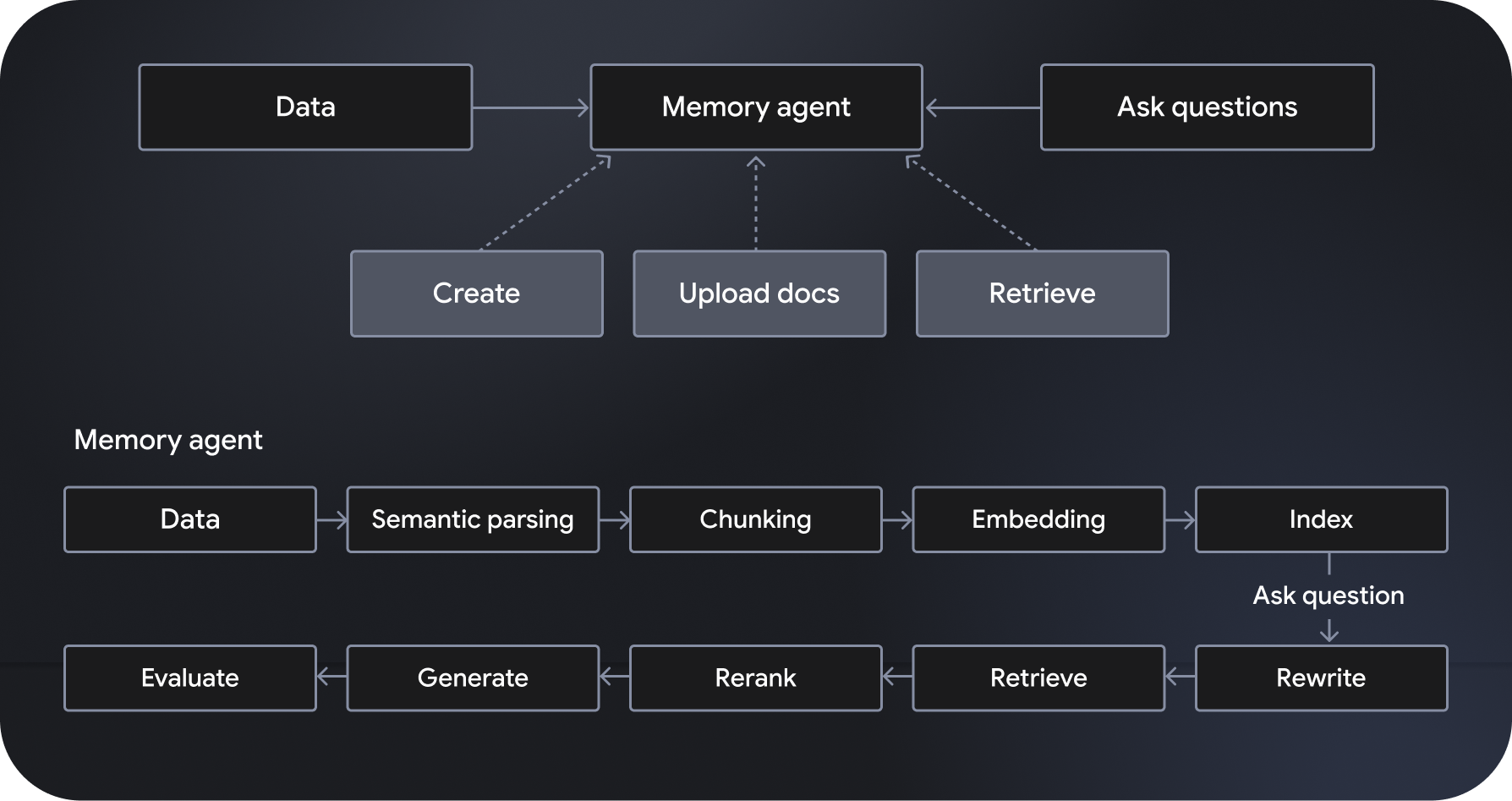

Langbase یک پلتفرم توسعه و استقرار عامل هوش مصنوعی بدون سرور و قابل ترکیب است که امکان ایجاد عاملهای هوش مصنوعی بدون سرور را فراهم میکند. این پلتفرم سیستمهای تولید تقویتشده با بازیابی معنایی (RAG) کاملاً مدیریتشده و مقیاسپذیر را که به عنوان "عاملهای حافظه" شناخته میشوند، ارائه میدهد. ویژگیهای اضافی شامل تنظیم گردش کار، مدیریت دادهها، مدیریت تعامل کاربر و ادغام با سرویسهای خارجی است.

با استفاده از مدلهایی مانند Gemini 2.0 Flash، «عاملهای لولهای» به دستورالعملهای مشخصشده پایبند هستند و بر اساس آنها عمل میکنند و به ابزارهای قدرتمندی از جمله جستجوی وب و خزش وب دسترسی دارند. از سوی دیگر، عاملهای حافظه به صورت پویا به دادههای مرتبط دسترسی پیدا میکنند تا پاسخهای مبتنی بر واقعیت تولید کنند. APIهای لولهای و حافظهای Langbase به توسعهدهندگان این امکان را میدهند که با اتصال استدلال قدرتمند به منابع داده جدید، ویژگیهای قدرتمندی بسازند و دانش و کاربرد مدلهای هوش مصنوعی را گسترش دهند.

با خودکارسازی فرآیندهای پیچیده، افزایش بهرهوری گردش کار و ارائه تجربیات بسیار شخصیسازیشده به کاربران، عاملهای هوش مصنوعی امکاناتی را برای برنامههای قدرتمندتر فراهم میکنند. ترکیبی از استدلال قدرتمند، هزینههای پایین و سرعت بالاتر، مدلهای Gemini Flash را به انتخابی ارجح برای کاربران Langbase تبدیل میکند. برای شروع ساخت و استقرار عاملهای هوش مصنوعی بسیار کارآمد و مقیاسپذیر، این پلتفرم را بررسی کنید.

شرکای ولا

ولا پارتنرز از Grounding به همراه جستجوی گوگل برای بینشهای عمیقتر و سریعتر استفاده میکند