Nov 7, 2024

Gemini के मॉडल के लंबे कॉन्टेक्स्ट की मदद से, एआई कोडिंग असिस्टेंट को ज़्यादा बेहतर बनाना

लंबे कॉन्टेक्स्ट वाली विंडो का इस्तेमाल, कोड जनरेट करने और उसे समझने के लिए किया जा सकता है. यह एक बेहतरीन सुविधा है. बड़े कोडबेस के लिए, जटिल संबंधों और डिपेंडेंसी को गहराई से समझना ज़रूरी होता है. पारंपरिक एआई मॉडल को इसे समझने में मुश्किल होती है. बड़े कॉन्टेक्स्ट विंडो के साथ कोड की मात्रा बढ़ाकर, हम कोड जनरेट करने और उसे समझने में सटीकता और काम की जानकारी के एक नए लेवल को अनलॉक कर सकते हैं.

हमने Sourcegraph के साथ मिलकर काम किया है. Sourcegraph, Cody AI कोडिंग असिस्टेंट बनाने वाली कंपनी है. यह Gemini 1.5 Pro और Flash जैसे एलएलएम के साथ काम करता है. हमने कोडिंग के रीयल-वर्ल्ड सिनेरियो में, बड़ी कॉन्टेक्स्ट विंडो की क्षमता का पता लगाने के लिए यह साझेदारी की है. Sourcegraph, एआई की मदद से कोड जनरेट करने की सुविधा में कोड सर्च और इंटेलिजेंस को इंटिग्रेट करने पर फ़ोकस करता है. साथ ही, इसने Palo Alto Networks और Leidos जैसी बड़ी और जटिल कोडबेस वाली कंपनियों के लिए, Cody को सफलतापूर्वक डिप्लॉय किया है. इसलिए, यह इस एक्सप्लोरेशन के लिए सबसे सही पार्टनर है.

Sourcegraph का तरीका और नतीजे

Sourcegraph ने Cody के प्रोडक्शन वर्शन की तुलना, 10 लाख टोकन वाली कॉन्टेक्स्ट विंडो (Google के Gemini 1.5 Flash का इस्तेमाल करके) के साथ की. सीधे तौर पर तुलना करने से, उन्हें ज़्यादा जानकारी वाले कॉन्टेक्स्ट के फ़ायदों के बारे में पता चला. उन्होंने तकनीकी सवालों के जवाब देने पर फ़ोकस किया. यह बड़े कोडबेस के साथ काम करने वाले डेवलपर के लिए एक ज़रूरी टास्क है. उन्होंने मुश्किल सवालों के ऐसे डेटासेट का इस्तेमाल किया जिसमें कोड को गहराई से समझने की ज़रूरत होती है.

नतीजे काफ़ी अच्छे थे. ज़्यादा कॉन्टेक्स्ट का इस्तेमाल करने पर, Sourcegraph के तीन मुख्य बेंचमार्क—ज़रूरी जानकारी को याद रखना, ज़रूरी जानकारी को कम शब्दों में बताना, और मददगार होना—में काफ़ी सुधार हुआ.

ज़रूरी जानकारी याद रखना: जवाब में ज़रूरी तथ्यों का अनुपात काफ़ी बढ़ गया है.

जवाब में ज़रूरी तथ्यों को शामिल करना: जवाब में ज़रूरी तथ्यों को शामिल करने का अनुपात भी बेहतर हुआ है. इससे पता चलता है कि जवाब ज़्यादा सटीक और काम के हैं.

मददगार होने का स्कोर: जवाब की लंबाई के हिसाब से, मददगार होने का स्कोर काफ़ी बढ़ गया है. इससे पता चलता है कि उपयोगकर्ता को बेहतर अनुभव मिला है.

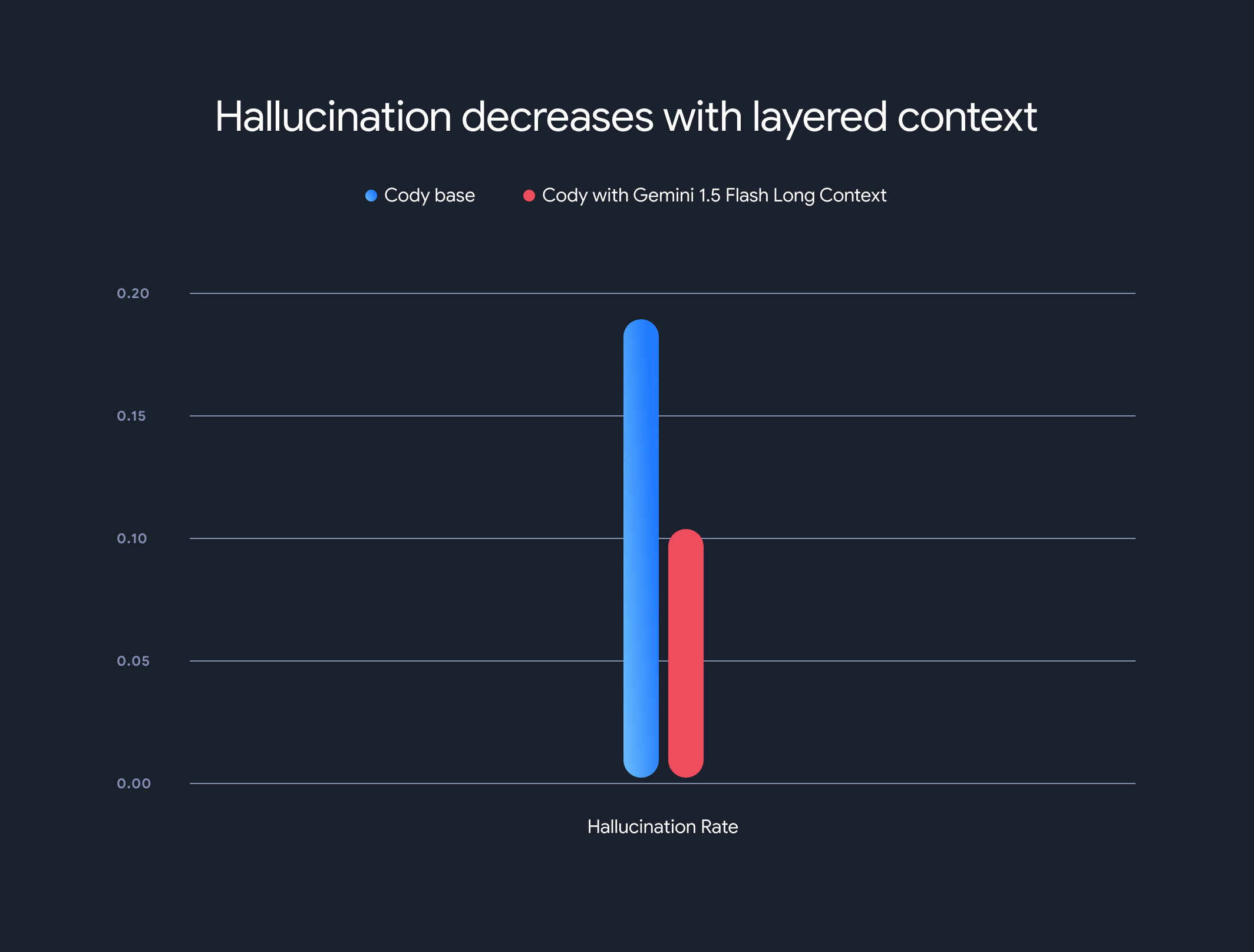

इसके अलावा, लंबे कॉन्टेक्स्ट वाले मॉडल का इस्तेमाल करने से, बनावटी जानकारी देने की दर में काफ़ी कमी आई है. बनावटी जानकारी का मतलब, तथ्यों के हिसाब से गलत जानकारी जनरेट करना है. भरोसेमंद न होने की दर 18.97% से घटकर 10.48% हो गई. इससे, जवाबों के सटीक और भरोसेमंद होने में काफ़ी सुधार हुआ.

ट्रेडऑफ़ और आने वाले समय में होने वाले बदलाव

लंबे कॉन्टेक्स्ट के कई फ़ायदे हैं, लेकिन इसके कुछ नुकसान भी हैं. कॉन्टेक्स्ट की लंबाई बढ़ने के साथ-साथ, पहले टोकन के जनरेट होने में लगने वाला समय भी बढ़ता जाता है. इस समस्या को कम करने के लिए, Sourcegraph ने मॉडल एक्ज़ीक्यूशन की स्थिति को कैश मेमोरी में सेव करने के लिए, प्रीफ़ेचिंग मेकेनिज़्म और लेयर्ड कॉन्टेक्स्ट मॉडल आर्किटेक्चर को लागू किया. Gemini 1.5 Flash और Pro के लॉन्ग-कॉन्टेक्स्ट मॉडल की मदद से, 1 एमबी के कॉन्टेक्स्ट के लिए पहले टोकन को जनरेट होने में लगने वाले समय को 30 से 40 सेकंड से घटाकर करीब 5 सेकंड कर दिया गया है. यह रीयल-टाइम में कोड जनरेट करने और तकनीकी सहायता पाने के लिए, एक बड़ा सुधार है.

इस साझेदारी से पता चलता है कि लंबे कॉन्टेक्स्ट वाले मॉडल, कोड को समझने और जनरेट करने के तरीके में कितना बदलाव ला सकते हैं. हमें Sourcegraph जैसी कंपनियों के साथ साझेदारी करने में खुशी हो रही है, ताकि हम बड़े कॉन्टेक्स्ट विंडो के साथ और भी ज़्यादा इनोवेटिव ऐप्लिकेशन और पैराडाइम को अनलॉक कर सकें.

Sourcegraph के आकलन के तरीकों, बेंचमार्क, और विश्लेषण के बारे में ज़्यादा जानने के लिए, ज़्यादा जानकारी देने वाला उनका ब्लॉग पोस्ट पढ़ना न भूलें. इसमें उदाहरण भी शामिल हैं.