KI in mobilen, Web- und eingebetteten Anwendungen bereitstellen

-

Auf dem Gerät

Latenz reduzieren. Offline arbeiten Ihre Daten lokal und privat halten

-

Plattformübergreifend

Dasselbe Modell für Android, iOS, das Web und eingebettete Inhalte ausführen

-

Mehrere Frameworks

Kompatibel mit JAX-, Keras-, PyTorch- und TensorFlow-Modellen.

-

Full AI Edge Stack

Flexible Frameworks, schlüsselfertige Lösungen, Hardwarebeschleuniger

Vorgefertigte Lösungen und flexible Frameworks

Low-Code-APIs für gängige KI-Aufgaben

Plattformübergreifende APIs für gängige Aufgaben im Bereich generative KI, Computer Vision, Text und Audio.

Mit MediaPipe-Aufgaben beginnenBenutzerdefinierte Modelle plattformübergreifend bereitstellen

Sie können JAX-, Keras-, PyTorch- und TensorFlow-Modelle effizient auf Android-, iOS-, Web- und eingebetteten Geräten ausführen, die für traditionelle ML und generative KI optimiert sind.

Einstieg in LiteRT

Entwicklungszyklen mit Visualisierung verkürzen

Die Transformation Ihres Modells durch Konvertierung und Quantisierung visualisieren Hotspots beheben, indem Benchmark-Ergebnisse überlagert werden

Einführung in den Modell-Explorer

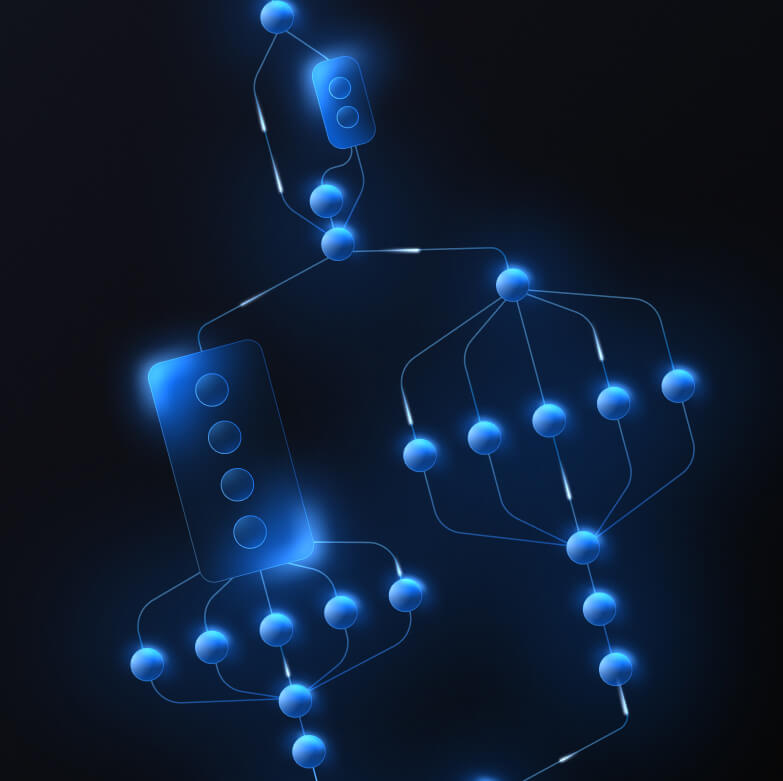

Benutzerdefinierte Pipelines für komplexe ML-Funktionen erstellen

Erstellen Sie Ihre eigene Aufgabe, indem Sie mehrere ML-Modelle mit Vor- und Nachverarbeitungslogik effizient verketten. Beschleunigte Pipelines (GPU und NPU) ausführen, ohne die CPU zu blockieren.

Einstieg in das MediaPipe-Framework

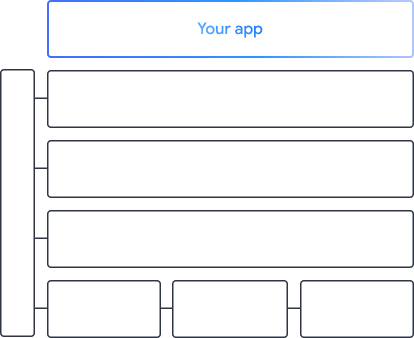

Die Tools und Frameworks, die die Apps von Google unterstützen

Entdecken Sie den gesamten Edge-Stack für KI mit Produkten auf jeder Ebene – von Low-Code-APIs bis hin zu hardwarespezifischen Beschleunigungsbibliotheken.

MediaPipe Tasks

MediaPipe Tasks

Mit Low-Code-APIs können Sie schnell KI-Funktionen in mobile und Web-Apps einbinden. Diese APIs decken gängige Aufgaben ab, darunter generative KI, Computer Vision, Text und Audio.

Generative KI

Mithilfe von sofort einsatzbereiten APIs können Sie generative Sprach- und Bildmodelle direkt in Ihre Apps einbinden.

Vision

Hier finden Sie eine große Auswahl an Aufgaben für die Bilderkennung, darunter Segmentierung, Klassifizierung, Erkennung, Erkennung und Körpermarkierungen.

Text und Audio

Text und Audio in vielen Kategorien klassifizieren, z. B. Sprache, Stimmung und benutzerdefinierte Kategorien

Jetzt starten

MediaPipe Framework

MediaPipe Framework

Ein Low-Level-Framework zum Erstellen hochleistungsfähiger beschleunigter ML-Pipelines, oft mit mehreren ML-Modellen in Kombination mit Vor- und Nachverarbeitung.

LiteRT

LiteRT

Sie können KI-Modelle, die in einem beliebigen Framework erstellt wurden, mit optimierter hardwarespezifischer Beschleunigung auf Mobilgeräten, im Web und auf Mikrocontrollern bereitstellen.

Mehrere Frameworks

Modelle von JAX, Keras, PyTorch und TensorFlow für die Ausführung an der Edge konvertieren

Plattformübergreifend

Sie können dasselbe Modell mit nativen SDKs auf Android-, iOS-, Web- und Mikrocontrollern ausführen.

Leichtgewichtig und schnell

Die effiziente LiteRT-Laufzeit belegt nur wenige Megabyte und ermöglicht die Modellbeschleunigung über CPU, GPU und NPU hinweg.

Jetzt starten

Modell-Explorer

Modell-Explorer

Modelle visuell untersuchen, beheben und vergleichen Leistungsbenchmarks und Zahlenwerte überlagern, um problematische Hotspots zu ermitteln

Gemini Nano in Android und Chrome

Mit dem leistungsstärksten On-Device-Modell von Google generative KI-Anwendungen erstellen