На этой странице описывается, как преобразовать модель TensorFlow в модель LiteRT (оптимизированный формат FlatBuffer , идентифицируемый по расширению файла .tflite ) с помощью конвертера LiteRT.

Рабочий процесс преобразования

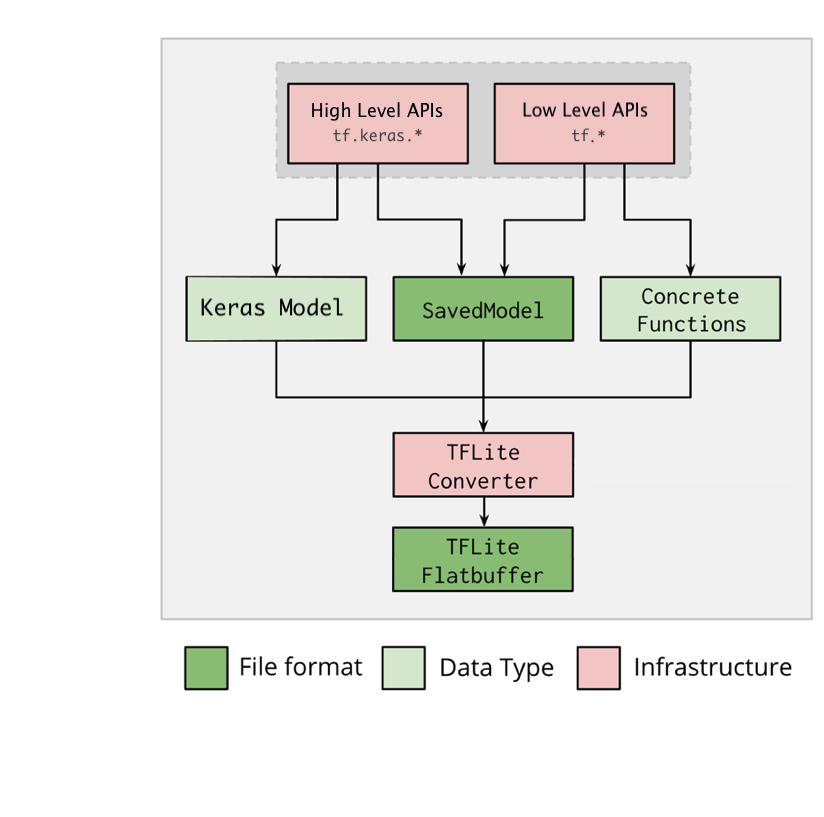

На диаграмме ниже показан общий рабочий процесс преобразования модели:

Рисунок 1. Рабочий процесс конвертера.

Вы можете преобразовать свою модель, используя один из следующих вариантов:

- Python API ( рекомендуется ): позволяет интегрировать преобразование в конвейер разработки, применять оптимизации, добавлять метаданные и выполнять множество других задач, упрощающих процесс преобразования.

- Командная строка : поддерживает только базовое преобразование модели.

API Python

Вспомогательный код: чтобы узнать больше об API конвертера LiteRT, выполните print(help(tf.lite.TFLiteConverter)) .

Конвертируйте модель TensorFlow с помощью tf.lite.TFLiteConverter . Модель TensorFlow хранится в формате SavedModel и генерируется либо с использованием высокоуровневого API tf.keras.* (модель Keras), либо низкоуровневого API tf.* (из которого генерируются конкретные функции). Таким образом, у вас есть три варианта (примеры приведены в следующих нескольких разделах):

-

tf.lite.TFLiteConverter.from_saved_model()( рекомендуется ): преобразует SavedModel . -

tf.lite.TFLiteConverter.from_keras_model(): Преобразует модель Keras . -

tf.lite.TFLiteConverter.from_concrete_functions(): Преобразует конкретные функции .

Конвертировать SavedModel (рекомендуется)

В следующем примере показано, как преобразовать SavedModel в модель TensorFlow Lite.

import tensorflow as tf

# Convert the model

converter = tf.lite.TFLiteConverter.from_saved_model(saved_model_dir) # path to the SavedModel directory

tflite_model = converter.convert()

# Save the model.

with open('model.tflite', 'wb') as f:

f.write(tflite_model)

Преобразовать модель Keras

В следующем примере показано, как преобразовать модель Keras в модель TensorFlow Lite.

import tensorflow as tf

# Create a model using high-level tf.keras.* APIs

model = tf.keras.models.Sequential([

tf.keras.layers.Dense(units=1, input_shape=[1]),

tf.keras.layers.Dense(units=16, activation='relu'),

tf.keras.layers.Dense(units=1)

])

model.compile(optimizer='sgd', loss='mean_squared_error') # compile the model

model.fit(x=[-1, 0, 1], y=[-3, -1, 1], epochs=5) # train the model

# (to generate a SavedModel) tf.saved_model.save(model, "saved_model_keras_dir")

# Convert the model.

converter = tf.lite.TFLiteConverter.from_keras_model(model)

tflite_model = converter.convert()

# Save the model.

with open('model.tflite', 'wb') as f:

f.write(tflite_model)

Преобразование конкретных функций

В следующем примере показано, как преобразовать конкретные функции в модель LiteRT.

import tensorflow as tf

# Create a model using low-level tf.* APIs

class Squared(tf.Module):

@tf.function(input_signature=[tf.TensorSpec(shape=[None], dtype=tf.float32)])

def __call__(self, x):

return tf.square(x)

model = Squared()

# (ro run your model) result = Squared(5.0) # This prints "25.0"

# (to generate a SavedModel) tf.saved_model.save(model, "saved_model_tf_dir")

concrete_func = model.__call__.get_concrete_function()

# Convert the model.

converter = tf.lite.TFLiteConverter.from_concrete_functions([concrete_func],

model)

tflite_model = converter.convert()

# Save the model.

with open('model.tflite', 'wb') as f:

f.write(tflite_model)

Другие особенности

Применяйте оптимизации . Распространенным методом оптимизации является квантование после обучения , которое может дополнительно сократить задержку и размер модели с минимальной потерей точности.

Добавьте метаданные , которые упростят создание кода-оболочки для конкретной платформы при развертывании моделей на устройствах.

Ошибки преобразования

Ниже приведены распространенные ошибки преобразования и их решения:

Ошибка:

Some ops are not supported by the native TFLite runtime, you can enable TF kernels fallback using TF Select.Решение: Ошибка возникает из-за того, что в вашей модели есть операции TF, для которых отсутствует соответствующая реализация TFLite. Решить эту проблему можно, используя операцию TF в модели TFLite (рекомендуется). Если вы хотите создать модель только с операциями TFLite, вы можете либо добавить запрос на отсутствующую операцию TFLite в GitHub issue #21526 (оставьте комментарий, если ваш запрос ещё не был упомянут), либо создать операцию TFLite самостоятельно.

Ошибка:

.. is neither a custom op nor a flex opРешение: Если эта операция TF:

- Поддерживается в TF: Ошибка возникает из-за того, что операция TF отсутствует в списке разрешенных (полный список операций TF, поддерживаемых TFLite). Решить эту проблему можно следующим образом:

- Добавьте отсутствующие операции в список разрешенных . 2. Преобразуйте модель TF в модель TFLite и запустите вывод .

- Не поддерживается в TF: ошибка возникает, поскольку TFLite не знает о заданном вами операторе TF. Устранить эту проблему можно следующим образом:

- Создать TF op .

- Конвертировать модель TF в модель TFLite .

- Создайте операцию TFLite и запустите вывод, связав ее со средой выполнения TFLite.

Инструмент командной строки

Если вы установили TensorFlow 2.x через pip , используйте команду tflite_convert . Чтобы просмотреть все доступные флаги, выполните следующую команду:

$ tflite_convert --help

`--output_file`. Type: string. Full path of the output file.

`--saved_model_dir`. Type: string. Full path to the SavedModel directory.

`--keras_model_file`. Type: string. Full path to the Keras H5 model file.

`--enable_v1_converter`. Type: bool. (default False) Enables the converter and flags used in TF 1.x instead of TF 2.x.

You are required to provide the `--output_file` flag and either the `--saved_model_dir` or `--keras_model_file` flag.

Если у вас загружен исходный код TensorFlow 2.x и вы хотите запустить конвертер из этого источника без сборки и установки пакета, вы можете заменить « tflite_convert » на « bazel run tensorflow/lite/python:tflite_convert -- » в команде.

Преобразование сохраненной модели

tflite_convert \

--saved_model_dir=/tmp/mobilenet_saved_model \

--output_file=/tmp/mobilenet.tflite

Преобразование модели Keras H5

tflite_convert \

--keras_model_file=/tmp/mobilenet_keras_model.h5 \

--output_file=/tmp/mobilenet.tflite