3 LISTOPADA 2025 R.

Wykorzystanie Gemini Flash 2.5 do generowania modeli 3D na podstawie tekstu: jak Cartwheel stworzył narzędzie do generowania modeli 3D z zachowaniem pozycji

Modele generatywne otworzyły przed artystami i projektantami nowe możliwości. Dla profesjonalnych twórców przełożenie konkretnej wizji twórczej na wygenerowany obraz pozostaje jednak dużym wyzwaniem. W przypadku promptów tekstowych często mamy do czynienia z „maszyną losującą”, co utrudnia precyzyjne sterowanie pozą postaci, kątem kamery i kompozycją.

Cartwheel, platforma do tworzenia gier i multimediów 3D z wykorzystaniem AI, rozwiązuje ten problem, budując innowacyjne rozwiązanie oparte na zaawansowanych modelach Google, w tym przypadku Gemini 2.5 Flash Image Nano Banana. Funkcja „Pose Mode” w Cartwheel Studio wykracza poza proste generowanie obrazów na podstawie tekstu, ponieważ zawiera natywne elementy sterujące 3D, które zapewniają twórcom bezpośrednią, iteracyjną kontrolę nad wynikami.

Wyzwanie: wypełnienie luki między intencją a wynikiem

W profesjonalnych procesach twórczych precyzja jest niezbędna. Artysta, reklamodawca lub projektant gier często musi stworzyć postać w określonej pozie lub pod określonym kątem, aby dopasować ją do scenorysu lub briefu kampanii.

„Ogólnie rzecz biorąc, generatory obrazów są trudne do kontrolowania” – powiedział Jonathan Jarvis, współzałożyciel Cartwheel. „Trudno zrealizować wizję, którą się ma. Zawsze chcieliśmy umożliwić bezpośrednie manipulowanie postacią”.

Wymóg bezpośredniej manipulacji sprawił, że Cartwheel opracował multimodalny potok, który integruje pozowanie 3D, promptowanie tekstowe i wiele modeli AI, aby działały w harmonii.

Rozwiązanie: potok wielu modeli do generowania obrazów z zachowaniem pozy

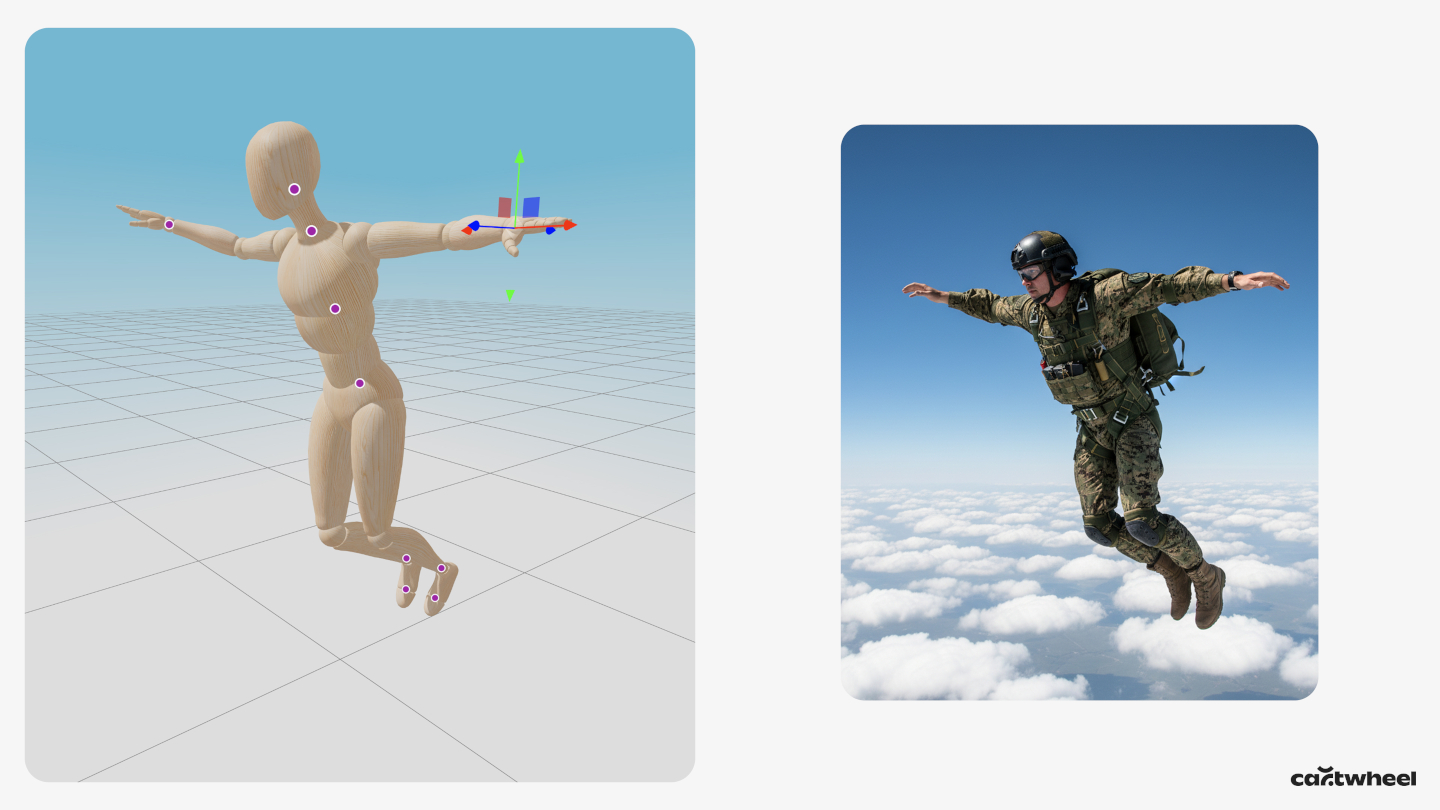

Zamiast polegać wyłącznie na tekście, tryb pozycji Cartwheel przedstawia użytkownikowi manekina 3D. Użytkownik może bezpośrednio klikać i przeciągać kończyny manekina, aby stworzyć określoną pozę, a także dostosowywać wirtualną kamerę pod dowolnym kątem. Scena 3D staje się wtedy głównym wejściem w procesie generatywnym.

Proces techniczny wygląda następująco:

- Etykietowanie póz za pomocą Gemini 2.5 Flash Najpierw zrzut ekranu z ustawionym manekinem 3D jest wysyłany do Gemini 2.5 Flash. W tym kroku Cartwheel używa 2,5 Flash, ponieważ jego szybkość jest idealna do spełnienia wymagań dotyczących małych opóźnień w narzędziu do tworzenia kreacji w czasie rzeczywistym. Zadaniem modelu jest zwrócenie prostej etykiety tekstowej opisującej pozę, np. „postać w pozycji skoku” lub „postać salutująca”.

- Tworzenie promptu multimodalnego Ta wygenerowana w technologii Flash etykieta dotycząca pozycji 2,5D jest następnie automatycznie łączona z tekstowym promptem opisowym użytkownika (np. „robot na polu kwiatów”).

- Uwarunkowane generowanie obrazów Na koniec połączony prompt tekstowy jest wysyłany do modelu obrazu o wysokiej wierności i dokładności w zakresie pozycji, Gemini 2.5 Flash Image, wraz z oryginalnym zrzutem ekranu z pozycją 3D. Ten prompt multimodalny, który zawiera zarówno obraz pozycji, jak i szczegółowy opis tekstowy, sprawia, że Gemini 2.5 Flash Image generuje obraz ściśle zgodny z pozycją i kątem kamery, a jednocześnie stosuje styl artystyczny, postać i szczegóły sceny z tekstu.

Łączenie modeli – używanie 2.5 Flash do analizy wizualnej i etykietowania oraz 2.5 Flash Image do końcowego renderowania warunkowego – pozwala Cartwheel oferować unikalny proces, który łączy intuicyjne sterowanie oprogramowaniem 3D z kreatywną mocą generatywnej AI.

Wyniki: spójność postaci pod dowolnym kątem

To podejście okazało się skuteczne w generowaniu obrazów, które wcześniej były trudne do utworzenia. „Renderowanie postaci z dowolnego kąta poza przodem nie działało w żadnym innym modelu” – zauważył Andrew Carr, współzałożyciel Cartwheel. „Gdy tylko obróciłeś kamerę, rozpadła się na części”.

Większość modeli obrazów jest trenowana na danych, które w przeważającej mierze przedstawiają postacie z przodu, dlatego mają one trudności z tworzeniem mniej typowych kompozycji, takich jak ujęcia z góry lub widoki z tyłu. Dzięki dostarczaniu pozy jako bezpośredniego wejścia wizualnego narzędzie Cartwheel omija to odchylenie danych treningowych, co pozwala artyście generować spójne postacie pod dowolnym wybranym przez niego kątem.

Ten przepływ pracy znacznie przyspiesza proces twórczy. Zadanie, które wcześniej wymagało od artysty 3D wielogodzinnego, iteracyjnego tworzenia promptów lub ręcznego komponowania, można teraz wykonać w kilka sekund.

Co dalej: od obrazów statycznych do generatywnych filmów

Cartwheel planuje już kolejne kroki związane z tą technologią. Zespół eksperymentuje z integracją biblioteki 150 tys. wstępnie skategoryzowanych póz,które użytkownicy mogą wyszukiwać i dopracowywać, co dodatkowo przyspiesza pracę.

Długoterminowa wizja zakłada rozszerzenie tego potoku przekształcania pozy w piksele na ruch. Ta sama poza 3D i wyrenderowany obraz mogą służyć jako klatka początkowa dla modelu wideo-wideo, takiego jak Veo. Umożliwi to twórcy ustawienie postaci, wyrenderowanie jej w dowolnym stylu, a następnie animowanie jej za pomocą prompta tekstowego, co pozwoli na płynne przejście od pozowania w 3D do końcowej, stylizowanej animacji.

Dzięki wykorzystaniu modeli multimodalnych, takich jak te z rodziny Gemini, Cartwheel pokazuje, jak deweloperzy mogą tworzyć zaawansowane narzędzia, które zapewniają artystom kontrolę i spójność, których potrzebują, przekształcając generatywną AI z narzędzia opartego na przypadku w narzędzie precyzyjnie realizujące zamierzenia twórcze.