9 APRIL 2025

Agen AI Gemini Flash dengan throughput tinggi dan biaya rendah di Langbase

Untuk membangun agen AI yang mampu mengelola alat eksternal dan operasinya secara mandiri, kita biasanya harus mengatasi berbagai hambatan integrasi dan infrastrukturnya. Langbase menghilangkan kesulitan dalam mengelola kompleksitas ini, dengan menyediakan platform untuk membuat dan men-deploy agen AI serverless yang didukung model AI seperti Gemini, semuanya tanpa framework.

Sejak Gemini Flash dirilis, pengguna Langbase dengan cepat menyadari keunggulan performa dan rendahnya biaya model ringan ini untuk membuat pengalaman agentic.

Mewujudkan skalabilitas dan agen AI yang lebih cepat dengan Gemini Flash

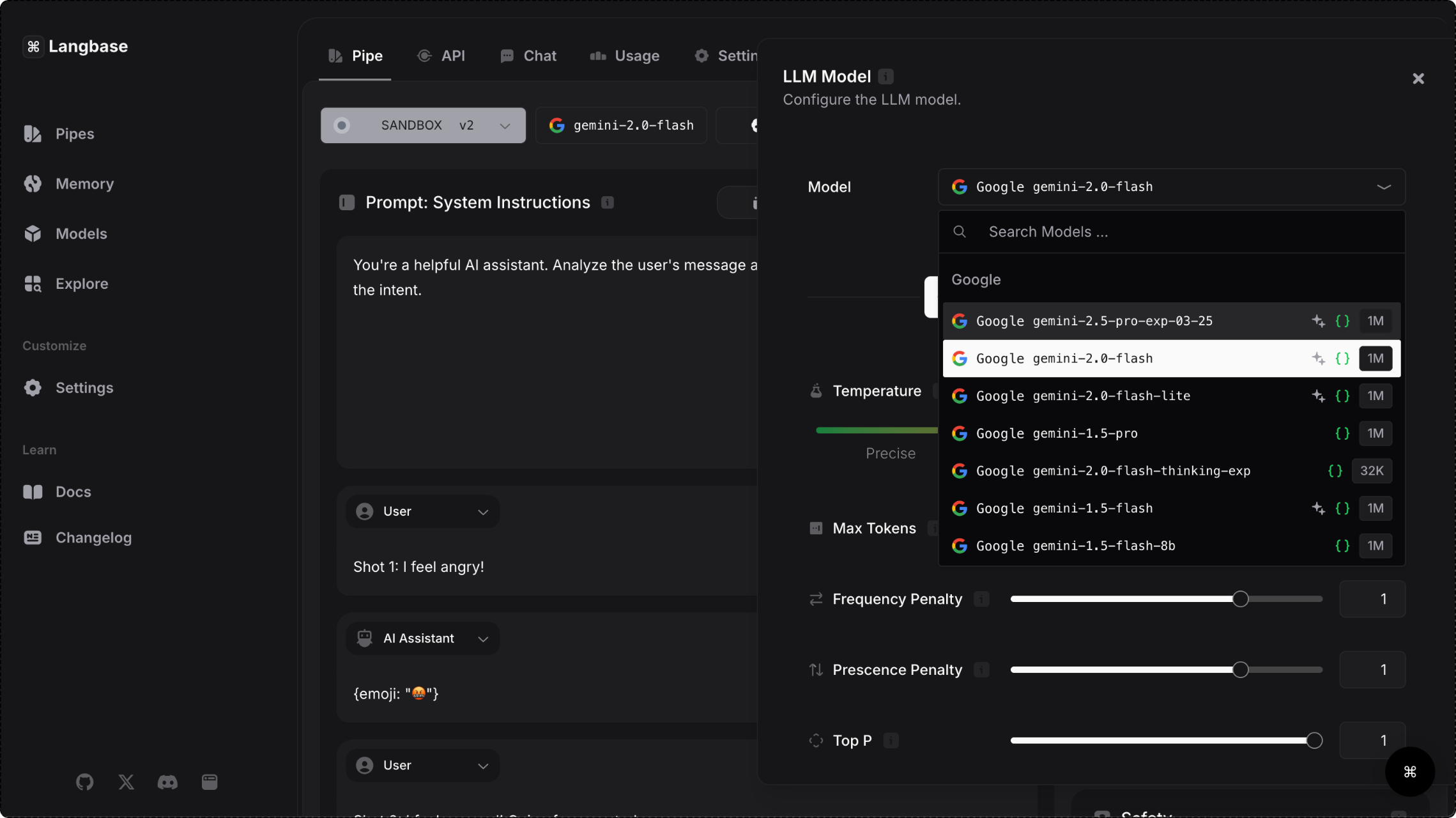

Platform Langbase menyediakan akses ke model Gemini melalui Gemini API, sehingga pengguna dapat memilih model cepat yang dapat menangani tugas kompleks dan memproses data dalam jumlah besar. Dengan latensi rendah yang sangat penting untuk memberikan pengalaman real-time yang lancar, rangkaian model Gemini Flash sangat cocok untuk membangun agen yang berinteraksi dengan pengguna.

Selain waktu respons yang 28% lebih cepat, pengguna platform mengalami penurunan biaya sebesar 50% dan peningkatan throughput sebesar 78% untuk operasi mereka saat menggunakan Gemini 1.5 Flash. Kemampuan untuk menangani volume permintaan yang besar tanpa mengorbankan performa menjadikan model Gemini Flash pilihan yang tepat untuk aplikasi dengan permintaan tinggi untuk kasus penggunaan seperti pembuatan konten media sosial, peringkasan makalah penelitian, dan analisis aktif dokumen medis.

31,1 token/dtk

Throughput 78% lebih tinggi dengan Flash vs. model yang sebanding

7,8x

jendela konteks lebih besar dengan Flash vs. model yang sebanding

28%

Waktu respons lebih cepat dengan Flash vs. model yang sebanding

50%

Biaya lebih rendah dengan Flash vs. model yang sebanding

- Sumber: Blog Langbase

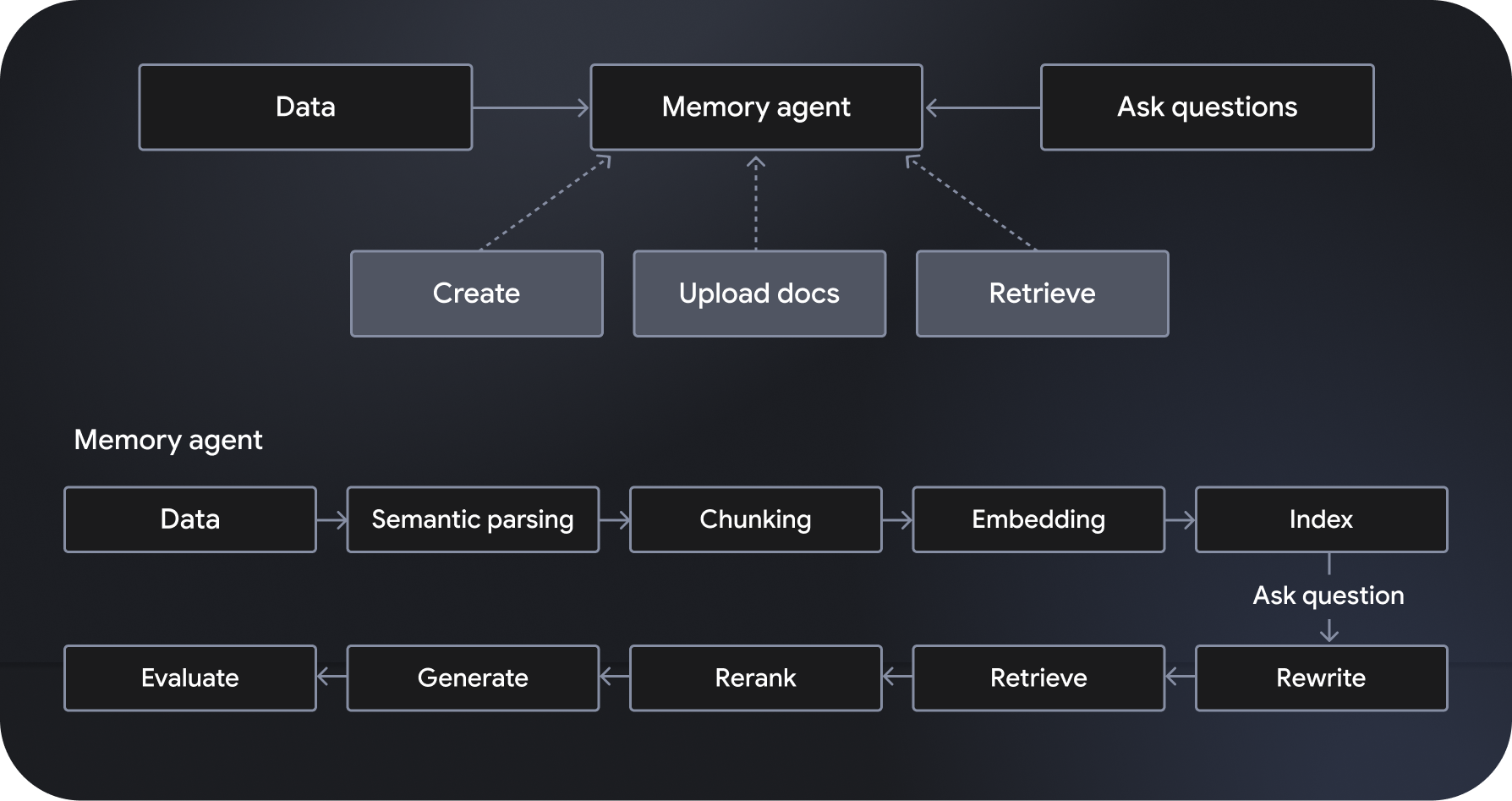

Cara Langbase menyederhanakan pengembangan agen

Langbase adalah platform pengembangan dan deployment agen AI serverless dan composable yang memungkinkan pembuatan agen AI serverless. Langbase menawarkan sistem semantic retrieval-augmented generation (RAG) yang terkelola sepenuhnya dan skalabel, yang dikenal dengan sebutan “agen memori”. Fitur tambahannya mencakup orkestrasi alur kerja, pengelolaan data, penanganan interaksi pengguna, dan integrasi dengan layanan eksternal.

Didukung oleh model seperti Gemini 2.0 Flash, “pipe agent” mematuhi dan menindaklanjuti petunjuk yang ditentukan serta memiliki akses ke alat canggih termasuk penelusuran web dan crawling web. Di sisi lain, agen memori mengakses data yang relevan secara dinamis untuk menghasilkan respons yang berdasar. Pipe dan Memory API Langbase memungkinkan developer membuat fitur canggih dengan menghubungkan penalaran yang efektif ke sumber data baru, sehingga memperluas pengetahuan dan kegunaan model AI.

Dengan mengotomatiskan proses yang rumit, meningkatkan efisiensi alur kerja, dan memberikan pengalaman yang sangat dipersonalisasi kepada pengguna, agen AI membuka peluang untuk aplikasi yang lebih canggih. Kombinasi penalaran yang canggih, biaya rendah, dan kecepatan yang lebih tinggi menjadikan model Gemini Flash sebagai pilihan yang lebih disukai oleh pengguna Langbase. Jelajahi platform untuk mulai membangun dan men-deploy agen AI yang sangat efisien dan skalabel.