2024년 11월 7일

Gemini 모델의 긴 컨텍스트로 AI 코딩 어시스턴트 강화

긴 컨텍스트 윈도우의 적용에서 가장 흥미로운 분야 중 하나는 코드 생성 및 이해입니다. 대규모 코드베이스는 복잡한 관계와 종속성에 대한 깊은 이해가 필요한데, 이러한 부분을 기존 AI 모델이 파악하기는 어렵습니다. 대규모 컨텍스트 윈도우를 사용하여 코드의 양을 늘리면 코드 생성 및 이해의 정확성과 유용성을 한 단계 끌어올릴 수 있습니다.

Google Cloud는 Gemini 1.5 Pro 및 Flash와 같은 LLM을 지원하는 Cody AI 코딩 어시스턴트의 제작자인 Sourcegraph와 협력하여 실제 코딩 시나리오에서 긴 컨텍스트 윈도우의 잠재력을 살펴봤습니다. Sourcegraph는 코드 검색과 인텔리전스를 AI 코드 생성에 통합하는 데 중점을 두고 Palo Alto Networks, Leidos와 같은 대규모의 복잡한 코드베이스를 보유한 기업에 Cody를 성공적으로 배포한 경험이 있어 이번 탐색에 이상적인 파트너였습니다.

Sourcegraph의 접근 방식 및 결과

Sourcegraph는 100만 개의 토큰 컨텍스트 범위(Google의 Gemini 1.5 Flash 사용)가 지원되는 Cody의 성능을 프로덕션 버전과 비교했습니다. 이 직접 비교를 통해 확장된 컨텍스트의 이점을 파악할 수 있었습니다. 이 모델은 대규모 코드베이스를 사용하는 개발자에게 중요한 기술적 질의 응답에 중점을 두었으며, 심층적 코드 이해가 필요한 난이도 높은 질문으로 구성된 데이터 세트를 사용했습니다.

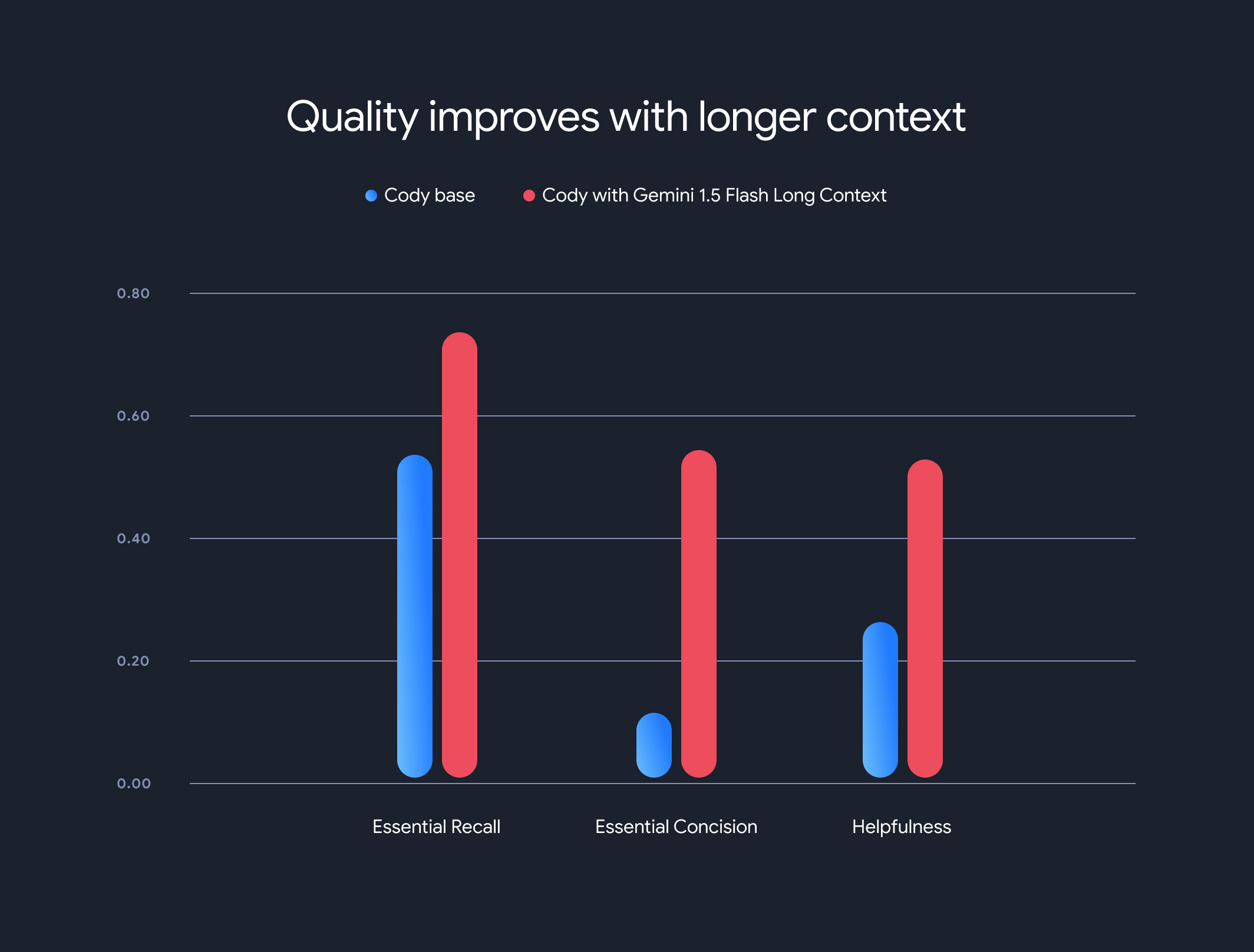

결과는 놀라웠습니다. 긴 컨텍스트를 사용할 때 Sourcegraph의 세 가지 주요 벤치마크인 필수 정보 재현율, 필수 정보 간결성, 유용성이 크게 개선되었습니다.

필수 정보 재현율: 대답에서 중요한 사실의 비율이 크게 증가했습니다.

필수 정보 간결성: 대답 길이로 정규화된 필수 사실 정보의 비율도 개선되어 더 간결하고 관련성 높은 대답을 얻을 수 있습니다.

유용성: 대답 길이로 정규화된 전반적인 유용성 점수가 크게 증가하여 사용자 친화적인 경험을 제공합니다.

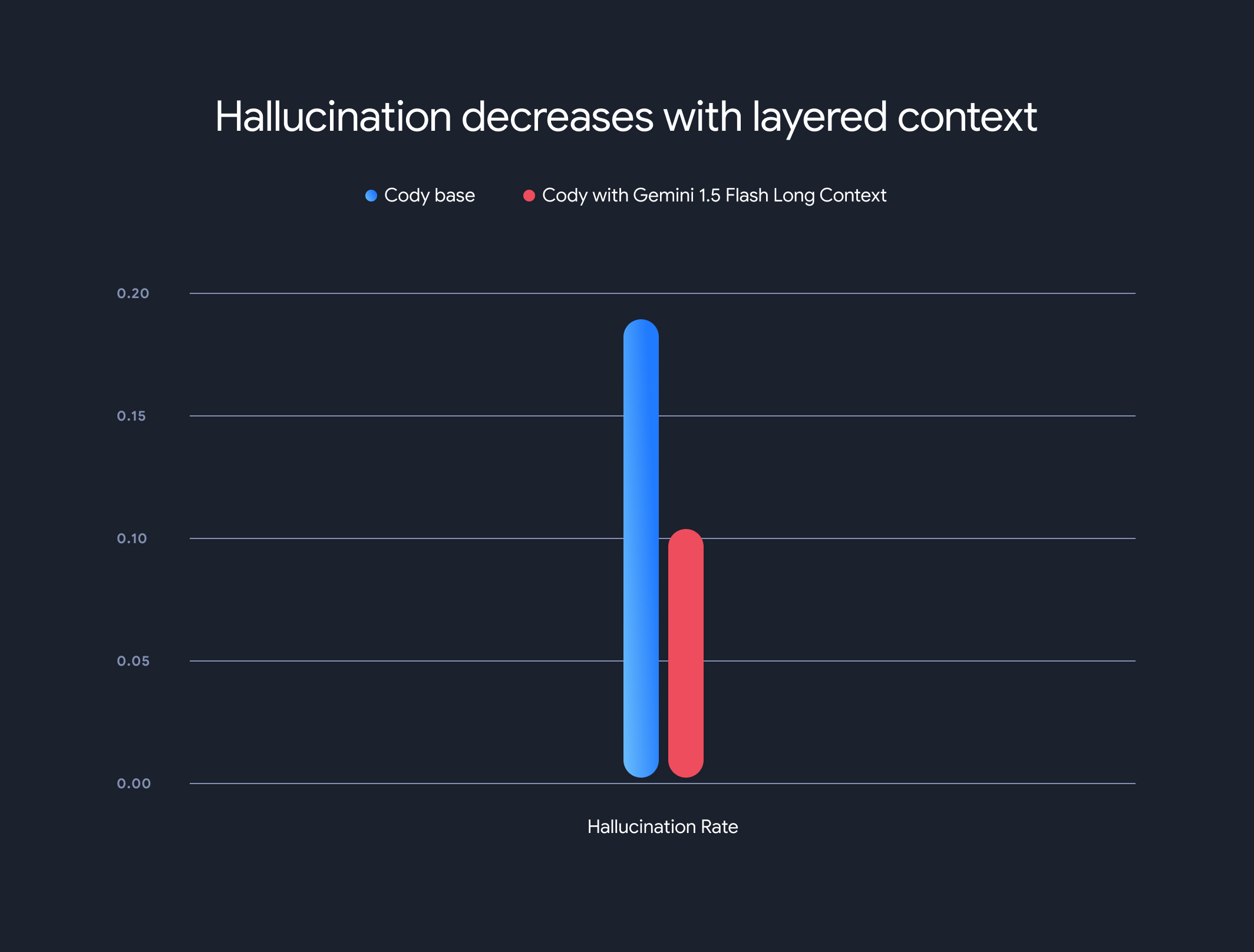

또한 긴 컨텍스트 모델 사용으로 전반적인 할루시네이션(사실과 다른 정보 생성) 비율이 크게 줄었습니다. 할루시네이션 비율이 18.97% 에서 10.48%로 감소하여 정확성과 신뢰성이 크게 향상되었습니다.

장단점 및 향후 방향

긴 컨텍스트의 이점은 상당히 크지만, 단점도 존재합니다. 첫 번째 토큰까지의 시간은 컨텍스트 길이에 따라 선형적으로 증가합니다. 이 문제를 완화하기 위해 Sourcegraph는 모델 실행 상태 캐싱을 위한 프리패치 메커니즘과 계층화된 컨텍스트 모델 아키텍처를 구현했습니다. Gemini 1.5 Flash 및 Pro의 긴 컨텍스트 모델을 통해 1MB 컨텍스트의 첫 번째 토큰까지의 시간이 30~40초에서 약 5초로 최적화되어 실시간 코드 생성 및 기술 지원이 크게 개선되었습니다.

이번 협업은 코드 이해 및 생성에 혁신을 가져오는 긴 컨텍스트 모델의 혁신적인 잠재력을 보여줍니다. Google은 Sourcegraph와 같은 회사와 파트너십을 맺어 대규모 컨텍스트 윈도우를 통해 더욱 혁신적인 애플리케이션과 패러다임을 계속해서 구현할 수 있게 되어 기쁩니다.

Sourcegraph의 자세한 평가 방법론, 벤치마크, 분석(예시 포함)을 자세히 알아보려면 심층 블로그 게시물을 참고하세요.