Criar um comando para um modelo de inteligência artificial (IA), como o Gemini ou Gemma, capturar perfeitamente uma intenção pode ser uma tarefa não trivial. Muitas vezes, é necessário escrever um comando à mão e testá-lo em vários casos de uso para para garantir que ela atenda às suas necessidades. Com base nos resultados, você pode fazer atualizações direcionadas ao comando: mudar algumas palavras em um lugar, adicionar uma nova frase em outro. Esse processo não é muito confiável e pode não gerar os melhores resultados.

O Google desenvolveu um método que usa LLMs para atualizar automaticamente um modelo de comando com base no feedback que você fornece sobre a saída do modelo em linguagem simples. Seu feedback, junto com o comando e a saída do modelo, são enviados a um LLM que atualiza o comando para que ele se alinhe melhor ao comportamento esperado.

Esse método está disponível de duas maneiras:

- A biblioteca

model-alignmentde código aberto para Python permite essa abordagem em seu software e fluxos de trabalho. - Uma versão dessa abordagem é integrada à Vertex AI Studio, permitindo que você use esse fluxo de trabalho com apenas alguns cliques.

Biblioteca de código aberto

Alinhamento de modelo é uma biblioteca Python de código aberto, lançada como uma pacote em PyPI que permite o alinhamento de comandos de humanos feedback por uma API. A biblioteca é baseada em nossa pesquisa de atualização com feedback humano e criação automática de classificadores usando dados rotulados.

Criar modelos de comando para o Gemma usando a biblioteca Model Alignment

|

|

Essa biblioteca oferece suporte a dois fluxos de trabalho para atualização automática de modelos de comandos:

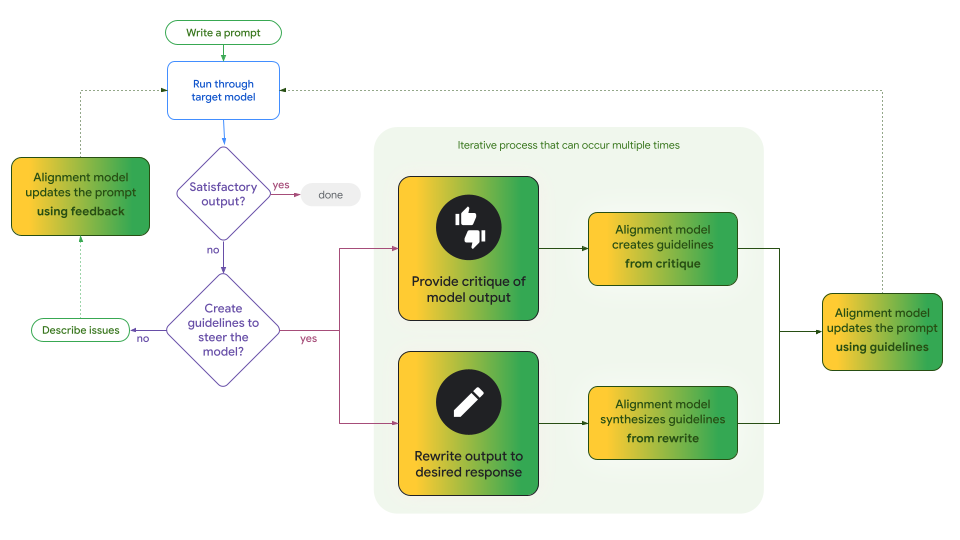

- Atualizações iterativas de princípios. Esse fluxo de trabalho usa um LLM para destilar diretrizes de críticas indiretas da saída do modelo ou de edições diretas da saída do modelo. É possível criar de forma iterativa uma ou mais diretrizes antes de enviá-las ao LLM, que atualiza o modelo de comando para aderir a essas diretrizes. Você também pode selecionar diretrizes manualmente e incluí-las com as destiladas pelo LLM.

- Crítica direta das saídas do modelo. Esse fluxo de trabalho recebe seu feedback sobre a saída do modelo inteiro e o alimenta, junto com a saída do comando e do modelo, diretamente no LLM para gerar um modelo de comando atualizado.

Esses dois fluxos de trabalho podem ser úteis para sua aplicação. A principal desvantagem é a presença de diretrizes, que podem ser um artefato de processo útil e concreto que pode ajudar a informar, por exemplo, sua abordagem de transparência.

Figura 1. Este fluxograma ilustra onde e como os dois fluxos de trabalho da biblioteca Model Alignment divergem para permitir atualizações diretas ou orientadas por diretrizes nos modelos de comando. O processo é iterativo, e esses fluxos de trabalho são mutuamente exclusivos, é possível alternar entre eles a qualquer momento.

Confira o notebook do Colab que usa o Gemini para alinhar instruções para o Gemma 2 usando os dois fluxos de trabalho.

Alinhamento no Vertex AI Studio

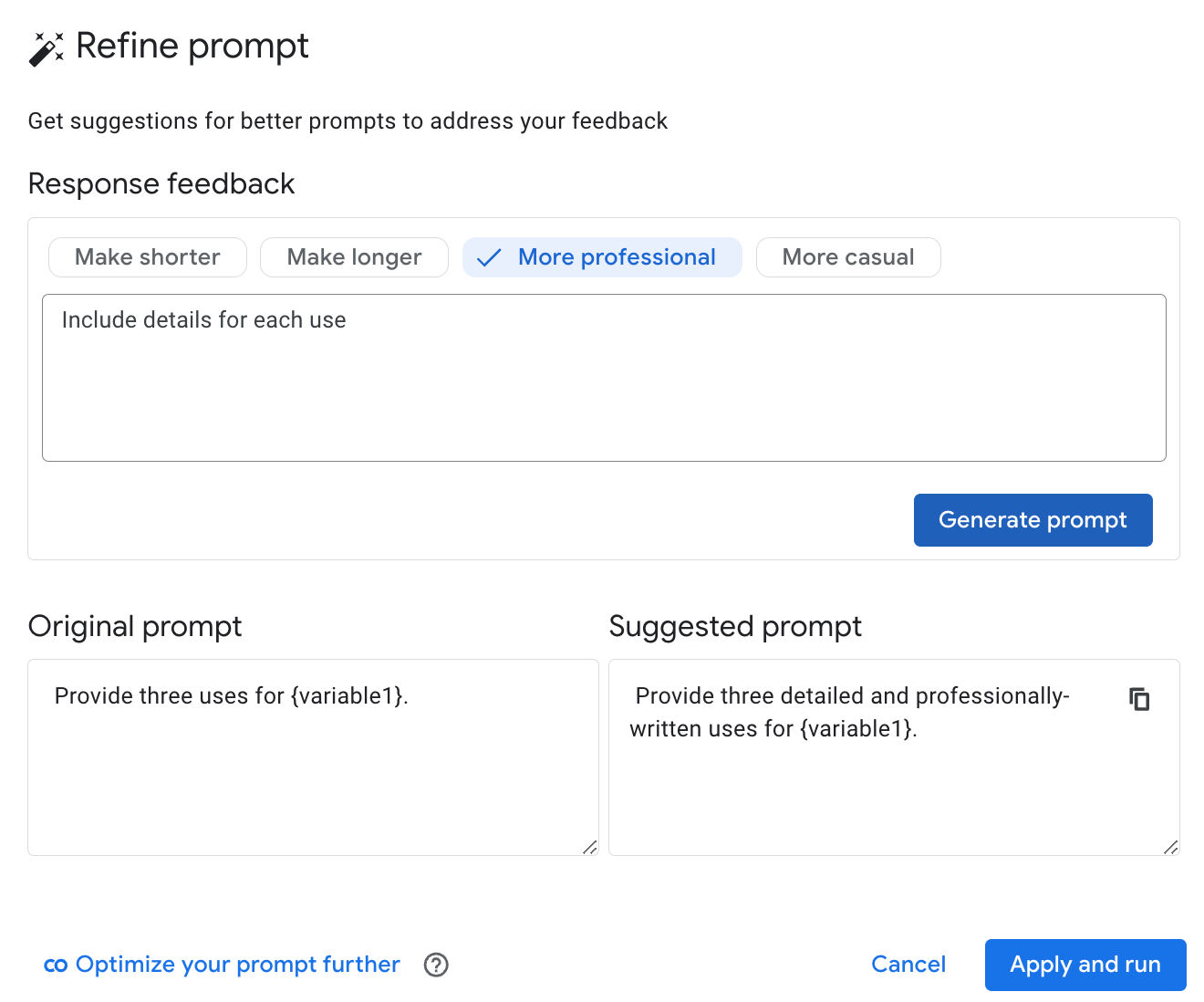

O Vertex AI Studio do Google adicionou o recurso "refine prompt" com base no fluxo de trabalho direto da biblioteca de código aberto Model Alignment para complementar as ferramentas de criação, execução, avaliação e comparação.

Depois de executar um comando, você pode enviar feedback sobre como o modelo deve se comportar de maneira diferente. O Vertex AI Studio usa o Gemini para elaborar uma reescrita. Você pode aceitar as mudanças propostas e executar novamente o comando atualizado com um clique em um botão ou atualizar seu feedback e pedir para o Gemini criar outro candidato.

Figura 2. O recurso "refine prompt" do Vertex AI Studio sendo usado para atualizar um comando com base no feedback do usuário.

Links

Conheça o alinhamento de modelos:

- Execute este bloco do Colab (em inglês) que usa o Gemini para alinhar várias comandos para nosso modelo Gemma 2 de pesos abertos usando ambas as abordagens de alinhamento.

- Teste o recurso de alinhamento de modelo "refine prompt" no Vertex AI Studio.