Questo toolkit fornisce risorse per applicare le best practice per l'uso responsabile di modelli aperti, come i modelli Gemma,

- Guida alla configurazione dei criteri di sicurezza, dell'ottimizzazione della sicurezza, dei classificatori di sicurezza e della valutazione dei modelli.

- Lo strumento di interpretabilità dell'apprendimento (LIT) per analizzare il comportamento di Gemma e risolvere potenziali problemi.

- Una metodologia per creare classificatori di sicurezza affidabili con un numero minimo di esempi.

Questa versione del toolkit è incentrata solo sui modelli da testo a testo in inglese. Puoi fornire feedback per rendere più utile questo toolkit tramite il link al meccanismo di feedback nella parte inferiore della pagina.

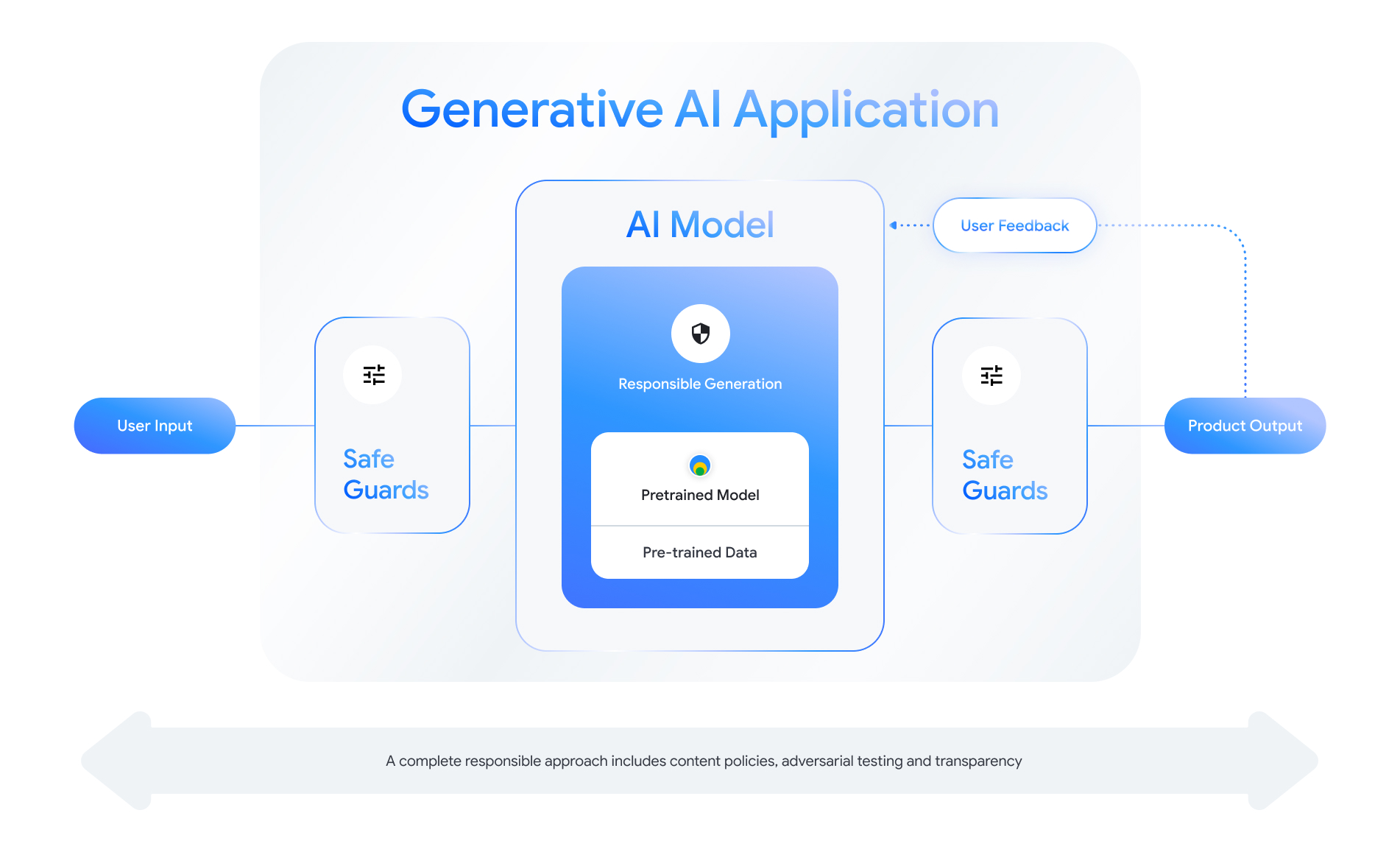

Quando crei con Gemma, devi adottare un approccio olistico alla responsabilità e considerare tutte le possibili sfide a livello di applicazione e modello. Questo toolkit illustra le tecniche di rischio e mitigazione per affrontare sicurezza, privacy, equità e responsabilità.

Dai un'occhiata al resto di questo toolkit per ulteriori informazioni e indicazioni:

- Valutare i rischi e impostare criteri di sicurezza

- Perfeziona i modelli per la sicurezza

- Crea salvaguardie per input e output

- Valuta il modello e il sistema per la sicurezza

- Creare elementi di trasparenza

- Analizza il comportamento del modello

Autori e collaboratori

Questo toolkit si basa su ricerche e strumenti di vari team di Google, tra cui i seguenti autori e collaboratori:

Ludovic Peran, Kathy Meier-Hellstern, Lucas Dixon, Reena Jana, Oscar Wahltinez, Clément Crepy, Ryan Mullins, Ian Tenney, Ted Klimenko, Shree Pandya, Nithum Thain, Mackenzie Thomas, Hayden Schaffer, Biner-Maken-Du, Seliraceed