2024 年 10 月 30 日

Gemini API を使用して AI エージェントを本番環境に導入する

AI エージェントの構築とデプロイはエキサイティングなフロンティアですが、本番環境でこれらの複雑なシステムを管理するには、堅牢なオブザーバビリティが必要です。エージェントのモニタリング、LLM の費用追跡、ベンチマークなどを行うための Python SDK である AgentOps を使用すると、特に Gemini API の能力と費用対効果を組み合わせることで、プロトタイプから本番環境までエージェントを移行できます。

Gemini のメリット

AgentOps を開発したチームである Agency AI の COO である Adam Silverman 氏は、AI エージェントを大規模にデプロイする企業にとって、費用は重要な要素であると説明しています。「企業が LLM 呼び出しに月額 80,000 ドルを費やしている例もあります。Gemini 1.5 を使用した場合、同じ出力に対して数千ドルかかります。」

この費用対効果と Gemini の強力な言語理解と生成機能を組み合わせることで、高度な AI エージェントを構築するデベロッパーにとって理想的な選択肢となります。「Gemini 1.5 Flash は、大規模なモデルと同等の品質を、わずかな費用で実現し、しかも非常に高速です」と Silverman 氏は述べています。これにより、デベロッパーはコストの増大を気にすることなく、複雑なマルチステップのエージェント ワークフローの構築に集中できます。

「他の LLM プロバイダの個々のエージェント実行では、実行あたり $500 以上の費用がかかることが確認されています。Gemini(1.5 Flash-8B)で同じ実行を行うと、50 ドル未満で済みます。」

AI エージェントの実現

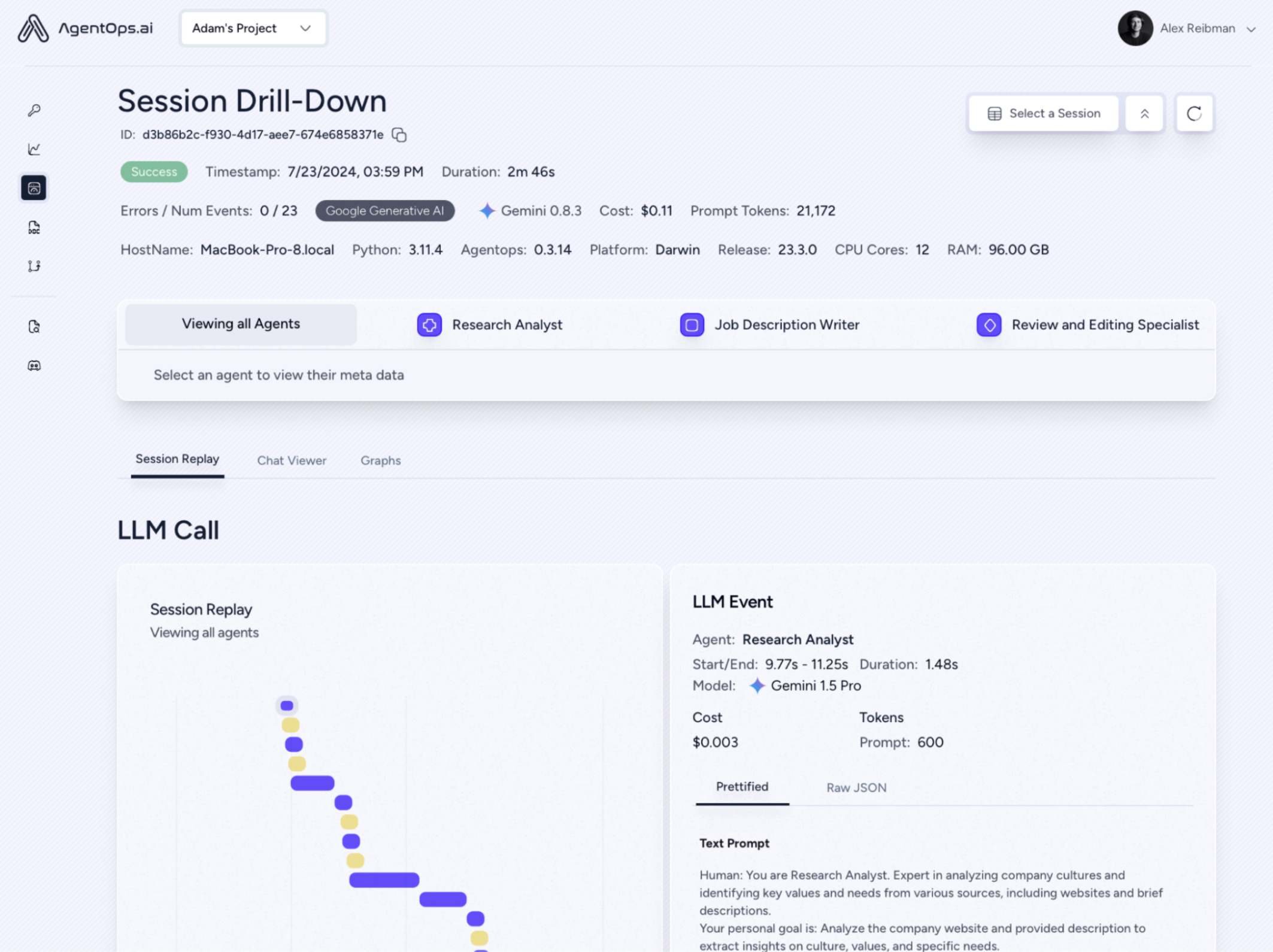

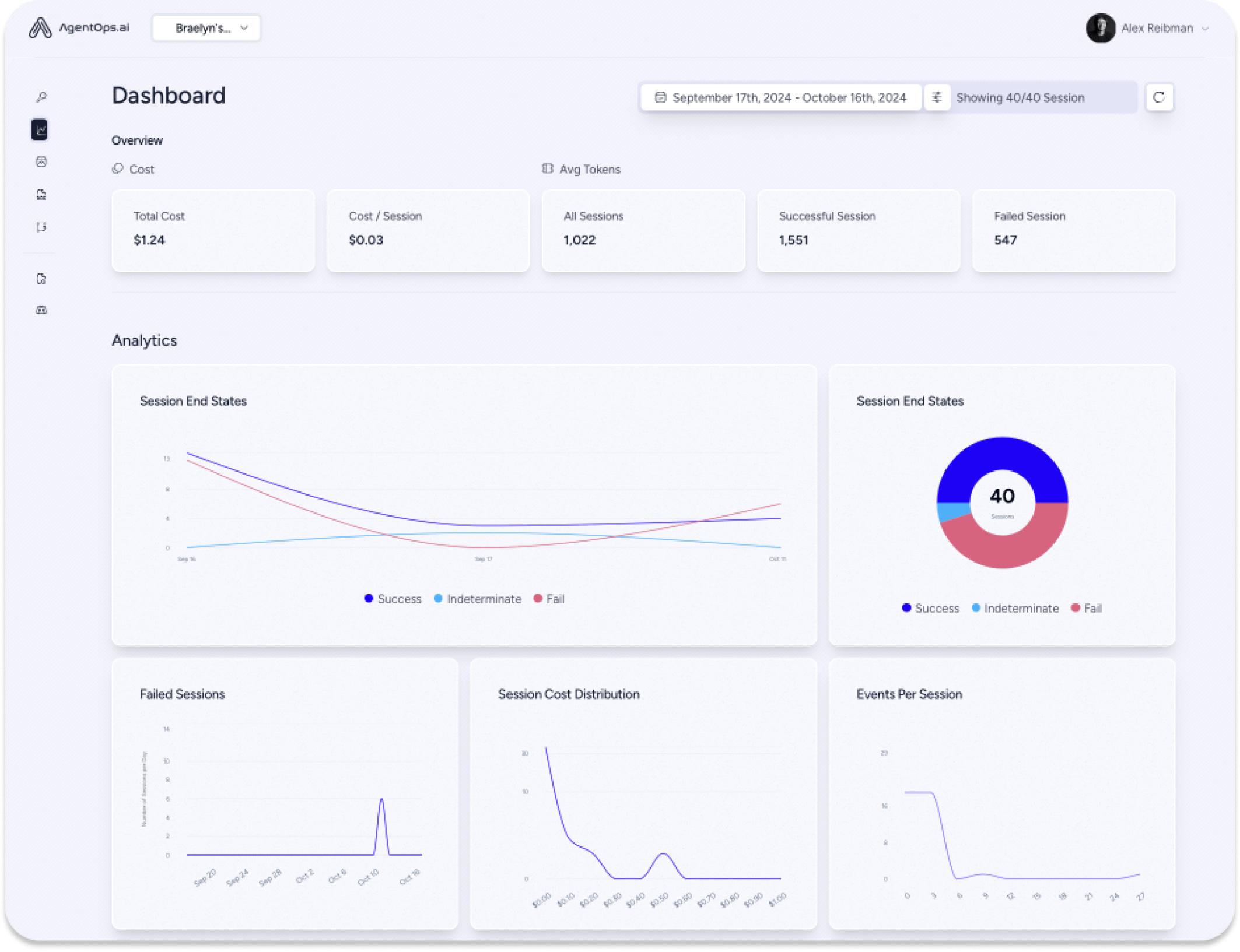

AgentOps は、LLM 呼び出しだけでなく、すべてのエージェント インタラクションに関するデータをキャプチャし、マルチエージェント システムの動作を包括的に把握できるようにします。この詳細なレベルの情報は、エンジニアリング チームとコンプライアンス チームにとって不可欠であり、デバッグ、最適化、監査証跡に関する重要な分析情報を提供します。

Gemini モデルと AgentOps の統合は非常に簡単で、LiteLLM を使用すると数分で完了することがよくあります。デベロッパーは、Gemini API 呼び出しをすばやく把握し、費用をリアルタイムで追跡して、本番環境でのエージェントの信頼性を確保できます。

今後の対応

AgentOps は、プロジェクトの拡大に取り組むエージェント デベロッパーをサポートすることに尽力しています。Agency AI は、手頃な価格でスケーラブルなエージェントの構築という複雑な課題を企業が解決できるよう支援し、AgentOps と Gemini API を組み合わせるという価値提案をさらに強化します。Silverman 氏は、「価格を重視するデベロッパーがエージェントを構築するようになる」と強調しています。

Gemini の使用を検討しているデベロッパーに対して、シルバーマン氏は「ぜひ試してみてください。きっと驚くはずです」と明確にアドバイスしています。