7 Nov 2024

Mengoptimalkan Asisten Coding AI dengan Konteks Panjang Model Gemini

Salah satu bidang paling menarik dalam penerapan jendela konteks panjang adalah pembuatan dan pemahaman kode. Codebase besar memerlukan pemahaman mendalam tentang hubungan dan dependensi yang kompleks, sesuatu yang sulit dipahami oleh model AI tradisional. Dengan memperluas jumlah kode menggunakan jendela konteks besar, kita dapat meningkatkan akurasi dan kegunaan dalam pembuatan dan pemahaman kode.

Kami berpartner dengan Sourcegraph, pembuat asisten coding AI Cody yang mendukung LLM seperti Gemini 1.5 Pro dan Flash, untuk mempelajari potensi jendela konteks panjang dalam skenario coding di dunia nyata. Fokus Sourcegraph pada integrasi penelusuran dan analisis kode ke dalam pembuatan kode AI, serta keberhasilan penerapan Cody ke perusahaan dengan codebase yang besar dan kompleks seperti Palo Alto Networks dan Leidos, menjadikan mereka partner yang ideal untuk eksplorasi ini.

Pendekatan dan Hasil Sourcegraph

Sourcegraph membandingkan performa Cody dengan jendela konteks 1 juta token (menggunakan Gemini 1.5 Flash Google) dengan versi produksinya. Perbandingan langsung ini memungkinkan mereka mengisolasi manfaat konteks yang diperluas. Mereka berfokus pada penjawaban pertanyaan teknis, tugas penting bagi developer yang bekerja dengan codebase besar. Mereka menggunakan dataset pertanyaan sulit yang memerlukan pemahaman kode yang mendalam.

Hasilnya sangat mencolok. Tiga tolok ukur utama Sourcegraph—Essential Recall, Essential Concision, dan Helpfulness—menunjukkan peningkatan yang signifikan saat menggunakan konteks yang lebih panjang.

Peningkatan Penting: Proporsi fakta penting dalam respons meningkat secara substansial.

Ringkas Penting (Essential Concision): Proporsi fakta penting yang dinormalisasi berdasarkan panjang respons juga meningkat, yang menunjukkan jawaban yang lebih ringkas dan relevan.

Kegunaan: Skor kegunaan secara keseluruhan, yang dinormalisasi berdasarkan panjang respons, meningkat secara signifikan, yang menunjukkan pengalaman yang lebih ramah pengguna.

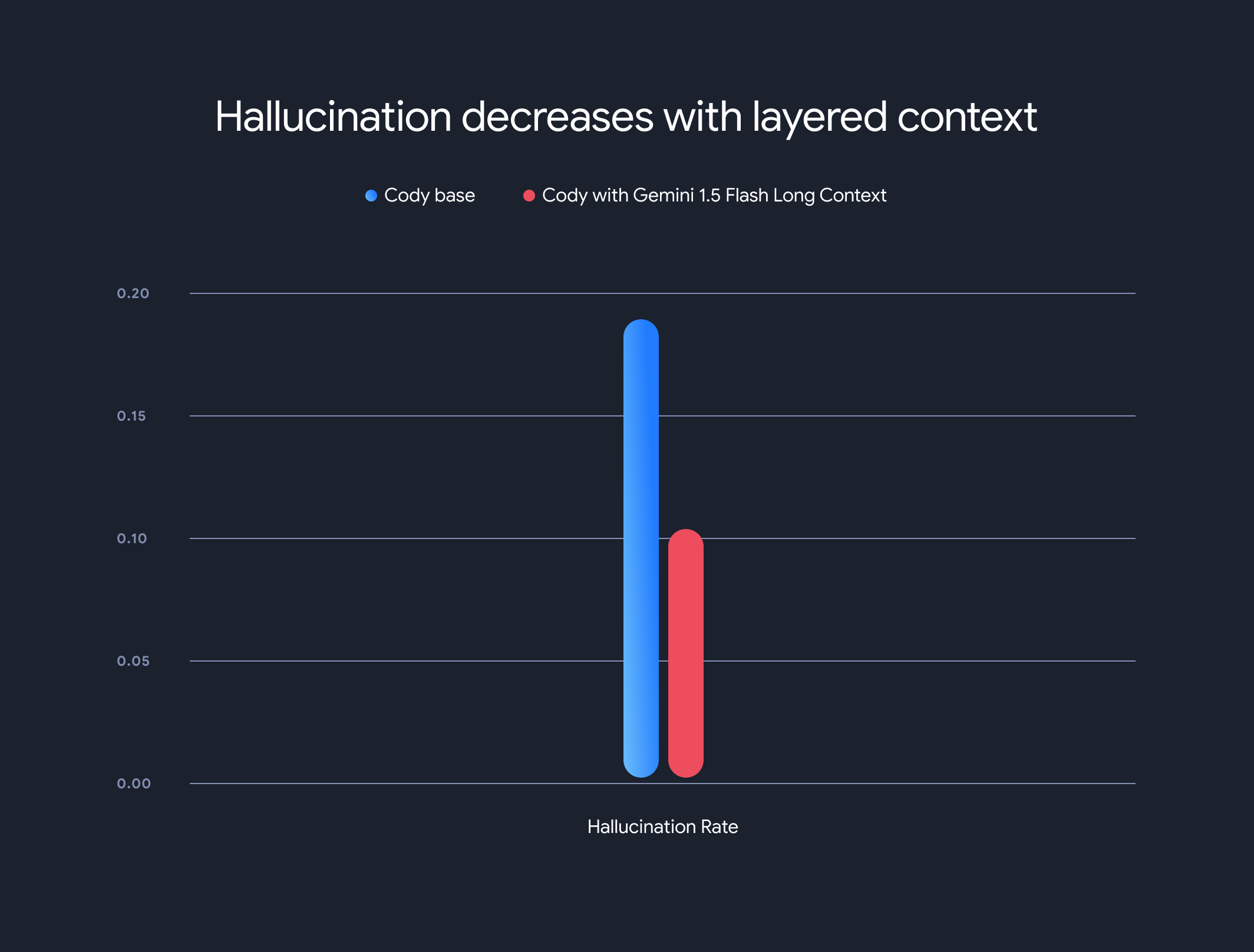

Selain itu, penggunaan model panjang konteks secara drastis mengurangi tingkat halusinasi secara keseluruhan (generasi informasi yang faktanya salah). Tingkat halusinasi menurun dari 18,97% menjadi 10,48%, peningkatan signifikan dalam akurasi dan keandalan.

Kompromi dan Arah ke Depan

Meskipun manfaat konteks panjang sangat signifikan, ada beberapa kekurangan. Waktu untuk token pertama meningkat secara linear dengan panjang konteks. Untuk memitigasi hal ini, Sourcegraph menerapkan mekanisme pengambilan data terlebih dahulu dan arsitektur model konteks berlapis untuk caching status eksekusi model. Dengan model konteks panjang Gemini 1.5 Flash dan Pro, waktu untuk token pertama dioptimalkan dari 30-40 detik menjadi sekitar 5 detik untuk konteks 1 MB – peningkatan yang cukup signifikan untuk pembuatan kode dan bantuan teknis secara real-time.

Kolaborasi ini menunjukkan potensi transformatif model konteks panjang dalam merevolusi pemahaman dan pembuatan kode. Kami senang dapat berpartner dengan perusahaan seperti Sourcegraph untuk terus menghadirkan aplikasi dan paradigma yang lebih inovatif dengan jendela konteks besar.

Untuk mempelajari lebih dalam metodologi evaluasi, tolok ukur, dan analisis mendetail Sourcegraph, termasuk contoh ilustratif, jangan lewatkan postingan blog mendalam mereka.