פריסת AI באפליקציות לנייד, לאינטרנט ובאפליקציות מוטמעות

-

במכשיר

קיצור זמן האחזור. עבודה במצב אופליין. שמירה על הנתונים המקומיים והפרטיים.

-

פלטפורמות שונות

להפעיל את אותו מודל ב-Android, ב-iOS, באינטרנט וברכיבים מוטמעים.

-

מודלים מרובים

תאימות למודלים של JAX, Keras, PyTorch ו-TensorFlow.

-

סטאק AI מלא לקצה

מסגרות גמישות, פתרונות מוכנים, מאיצי חומרה

פתרונות מוכנים ומסגרות גמישות

ממשקי API לקוד מינימלי למשימות נפוצות של AI

ממשקי API בפלטפורמות שונות לטיפול במשימות נפוצות של AI גנרטיבי, ראייה ממוחשבת, טקסט וקולות.

תחילת העבודה עם משימות של MediaPipeפריסת מודלים מותאמים אישית בפלטפורמות שונות

הפעלה יעילה של מודלים של JAX, Keras, PyTorch ו-TensorFlow ב-Android, iOS, באינטרנט ובמכשירים מוטמעים, עם אופטימיזציה ל-ML מסורתי ול-AI גנרטיבי.

תחילת השימוש ב-LiteRT

קיצור מחזורי הפיתוח באמצעות ויזואליזציה

הצגה חזותית של הטרנספורמציה של המודל באמצעות המרה וקידוד. ניפוי באגים בנקודות חמות על ידי הצגת תוצאות של מדדי ביצועים.

תחילת העבודה עם דוח של ביצועי המודל

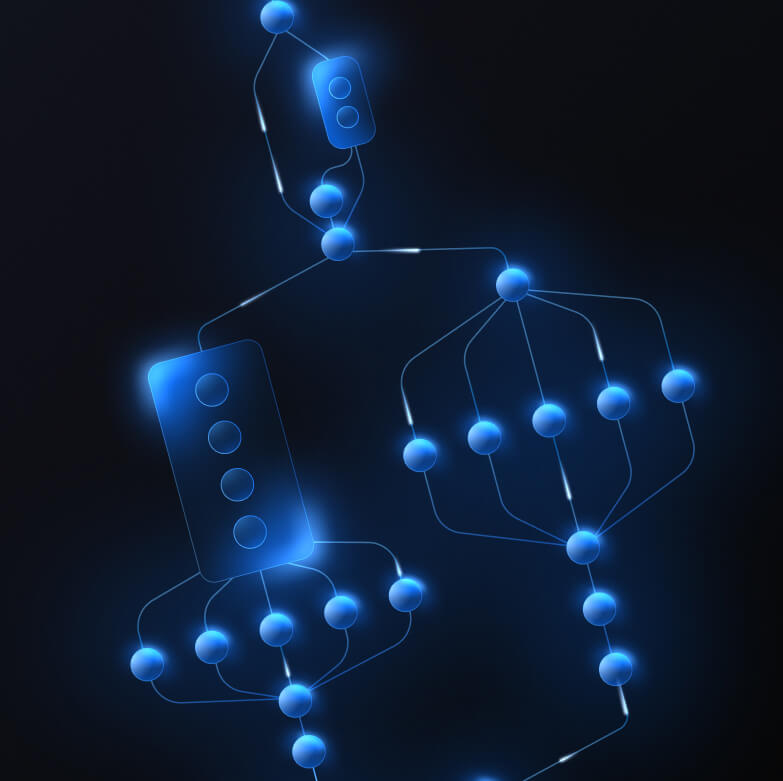

פיתוח צינורות עיבוד נתונים בהתאמה אישית לתכונות מורכבות של למידת מכונה

אפשר ליצור משימה משלכם על ידי קישור של כמה מודלים של למידת מכונה יחד עם לוגיקה של עיבוד מראש ועיבוד לאחר מכן, כדי לשפר את הביצועים. הפעלת צינורות עיבוד נתונים (pipelines) מואצים (GPU ו-NPU) בלי חסימה ב-CPU.

תחילת העבודה עם MediaPipe Framework

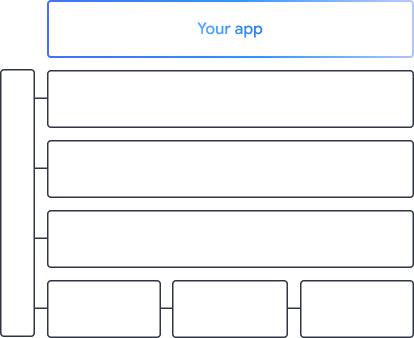

הכלים והמסגרות שמניעים את האפליקציות של Google

סקירה של סטאק הקצה המלא של AI, עם מוצרים בכל רמה – מממשקי API לקוד מינימלי ועד לספריות האצה ספציפיות לחומרה.

MediaPipe Tasks

MediaPipe Tasks

באמצעות ממשקי API עם תכנות מינימלי, אפשר להטמיע במהירות תכונות AI באפליקציות לנייד ולאינטרנט למשימות נפוצות שכוללות AI גנרטיבי, ראייה ממוחשבת, טקסט ואודיו.

AI גנרטיבי

שילוב של מודלים גנרטיביים של שפה ותמונות ישירות באפליקציות באמצעות ממשקי API מוכנים לשימוש.

ראייה

מגוון רחב של משימות ראייה, כולל פילוח, סיווג, זיהוי, זיהוי אובייקטים ומאפייני גוף.

טקסט ואודיו

סיווג טקסט וקובצי אודיו במגוון קטגוריות, כולל שפה, סנטימנט וקטגוריות בהתאמה אישית.

שנתחיל?

MediaPipe Framework

MediaPipe Framework

מסגרת ברמה נמוכה המשמשת ליצירת צינורות עיבוד נתונים מאיצים של למידת מכונה עם ביצועים גבוהים, שכוללים לרוב כמה מודלים של למידת מכונה בשילוב עם עיבוד מראש ועיבוד לאחר מכן.

LiteRT

LiteRT

פריסה של מודלים של AI שנוצרו בכל מסגרת, בניידים, באינטרנט ובמיקרו-בקרים, עם האצה אופטימלית לחומרה ספציפית.

מודלים מרובים

המרת מודלים מ-JAX, Keras, PyTorch ו-TensorFlow להרצה בקצה.

פלטפורמות שונות

להריץ את אותו מודל בדיוק ב-Android, ב-iOS, באינטרנט ובמיקרו-בקר באמצעות ערכות SDK מקוריות.

קל ומהיר

סביבת זמן הריצה היעילה של LiteRT תופסת רק כמה מגה-בייט ומאפשרת להאיץ את המודל במעבדי CPU, GPU ו-NPU.

דוח של ביצועי המודל

דוח של ביצועי המודל

עיון חזותי במודלים, ניפוי באגים והשוואה ביניהם. להציג שכבות של מדדי ביצועים ומספרים כדי לזהות נקודות חמות בעייתיות.

Gemini Nano ב-Android וב-Chrome

פיתוח חוויות של בינה מלאכותית גנרטיבית באמצעות המודל המתקדם ביותר של Google במכשיר