Deployment ML & AI generatif berperforma tinggi di platform edge

Konversi, runtime, dan pengoptimalan yang efisien untuk machine learning di perangkat.

Dibuat berdasarkan fondasi TensorFlow Lite yang telah teruji

LiteRT bukan hanya baru, tetapi juga merupakan runtime machine learning generasi berikutnya yang paling banyak di-deploy di dunia. Layanan ini mendukung aplikasi yang Anda gunakan setiap hari, memberikan latensi rendah dan privasi tinggi di miliaran perangkat.

Dipercaya oleh aplikasi Google yang paling penting

Lebih dari 100 ribu aplikasi, miliaran pengguna global

Sorotan LiteRT

Siap lintas platform

Memaksimalkan AI generatif

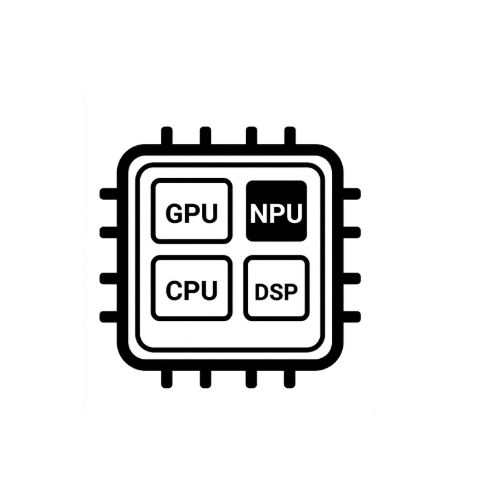

Akselerasi hardware yang disederhanakan

Dukungan multi-framework

Men-deploy melalui LiteRT

Mendapatkan model

Gunakan model terlatih .tflite atau konversi model PyTorch, JAX, atau TensorFlow ke .tflite

Mengoptimalkan model

Menguantisasi model secara opsional

Menjalankan

Pilih akselerator yang diinginkan dan jalankan di LiteRT

Contoh, model, dan demo

Lihat aplikasi contoh

Tutorial ini menunjukkan cara menggunakan LiteRT dengan contoh lengkap dan menyeluruh.

Lihat model genAI

Model AI Generatif siap pakai yang telah dilatih.

Lihat demo - Aplikasi Google AI Edge Gallery

Galeri yang menampilkan kasus penggunaan ML/GenAI di perangkat