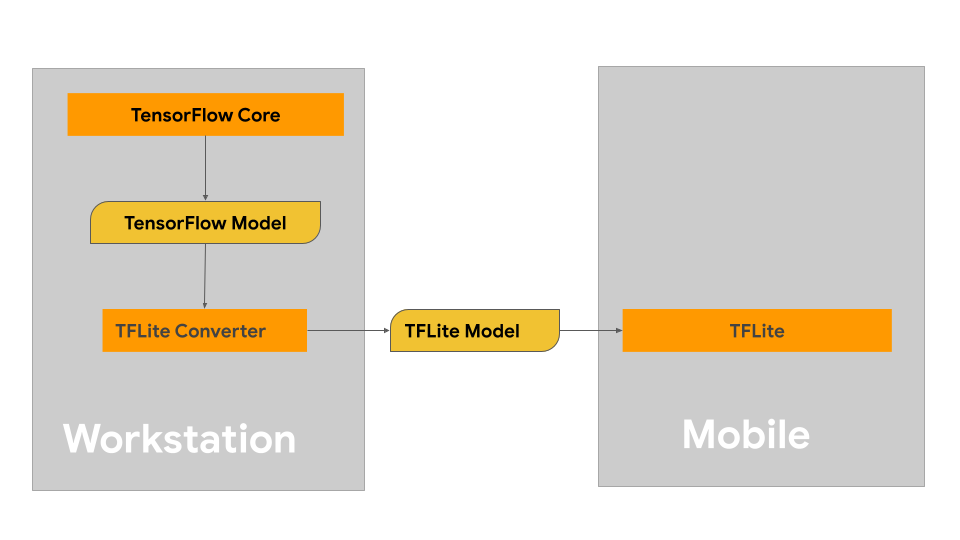

Halaman ini memberikan panduan untuk membangun model TensorFlow dengan maksud mengonversi ke format model LiteRT. Model machine learning (ML) yang Anda gunakan dengan LiteRT awalnya dibuat dan dilatih menggunakan library dan alat inti TensorFlow. Setelah membuat model dengan TensorFlow Core, Anda dapat mengonversinya ke format model ML yang lebih kecil dan lebih efisien yang disebut model LiteRT.

Jika Anda sudah memiliki model yang akan dikonversi, lihat halaman Ringkasan konversi model untuk mendapatkan panduan tentang cara mengonversi model Anda.

Membangun model

Jika Anda membuat model kustom untuk kasus penggunaan tertentu, Anda harus mulai dengan mengembangkan dan melatih model TensorFlow atau memperluas model yang sudah ada.

Batasan desain model

Sebelum memulai proses pengembangan model, Anda harus mengetahui batasan untuk model LiteRT dan membangun model dengan mempertimbangkan batasan ini:

- Kemampuan komputasi terbatas - Dibandingkan dengan server yang dilengkapi sepenuhnya dengan beberapa CPU, kapasitas memori tinggi, dan prosesor khusus seperti GPU dan TPU, perangkat seluler dan edge jauh lebih terbatas. Meskipun terus berkembang dalam daya komputasi dan kompatibilitas hardware khusus, model dan data yang dapat Anda proses secara efektif dengan model tersebut masih relatif terbatas.

- Ukuran model - Kompleksitas keseluruhan model, termasuk logika pra-pemrosesan data dan jumlah lapisan dalam model, akan meningkatkan ukuran model dalam memori. Model besar mungkin berjalan sangat lambat atau tidak sesuai dengan memori yang tersedia di perangkat seluler atau edge.

- Ukuran data - Ukuran data input yang dapat diproses secara efektif dengan model machine learning terbatas di perangkat seluler atau edge. Model yang menggunakan library data besar seperti library bahasa, library gambar, atau library klip video mungkin tidak sesuai di perangkat ini, dan mungkin memerlukan solusi penyimpanan dan akses di luar perangkat.

- Operasi TensorFlow yang didukung - Lingkungan runtime LiteRT mendukung subset operasi model machine learning dibandingkan dengan model TensorFlow biasa. Saat mengembangkan model untuk digunakan dengan LiteRT, Anda harus melacak kompatibilitas model dengan kemampuan lingkungan runtime LiteRT.

Untuk mengetahui informasi selengkapnya tentang cara membangun model berperforma tinggi yang efektif dan kompatibel untuk LiteRT, lihat Praktik terbaik performa.

Pengembangan model

Untuk membuat model LiteRT, Anda harus membuat model terlebih dahulu menggunakan library inti TensorFlow. Library inti TensorFlow adalah library tingkat rendah yang menyediakan API untuk membangun, melatih, dan men-deploy model ML.

TensorFlow menyediakan dua jalur untuk melakukannya. Anda dapat mengembangkan kode model kustom sendiri atau memulai dengan penerapan model yang tersedia di Model Garden TensorFlow.

Model Garden

TensorFlow Model Garden menyediakan implementasi banyak model machine learning (ML) canggih untuk vision dan natural language processing (NLP). Anda juga akan menemukan alat alur kerja yang memungkinkan Anda mengonfigurasi dan menjalankan model tersebut dengan cepat pada set data standar. Model machine learning di Model Garden mencakup kode lengkap sehingga Anda dapat menguji, melatih, atau melatih ulang model tersebut menggunakan set data Anda sendiri.

Baik Anda ingin mengukur performa model terkenal, memverifikasi hasil riset yang baru dirilis, atau memperluas model yang ada, Model Garden dapat membantu Anda mencapai sasaran ML.

Model kustom

Jika kasus penggunaan Anda berada di luar kasus penggunaan yang didukung oleh model di Model Garden, Anda dapat menggunakan library tingkat tinggi seperti Keras untuk mengembangkan kode pelatihan kustom Anda. Untuk mempelajari dasar-dasar TensorFlow, lihat panduan TensorFlow. Untuk mulai menggunakan contoh, lihat ringkasan tutorial TensorFlow yang berisi petunjuk untuk tutorial tingkat pemula hingga pakar.

Evaluasi model

Setelah mengembangkan model, Anda harus mengevaluasi performanya dan mengujinya di perangkat pengguna akhir. TensorFlow menyediakan beberapa cara untuk melakukannya.

- TensorBoard adalah alat untuk memberikan pengukuran dan visualisasi yang diperlukan selama alur kerja machine learning. TensorBoard memungkinkan pelacakan metrik eksperimen seperti kehilangan dan akurasi, memvisualisasikan grafik model, memproyeksikan embedding ke ruang dimensi yang lebih rendah, dan banyak lagi.

- Alat tolok ukur tersedia untuk setiap platform yang didukung, seperti aplikasi tolok ukur Android dan aplikasi tolok ukur iOS. Gunakan alat ini untuk mengukur dan menghitung statistik untuk metrik performa penting.

Pengoptimalan model

Dengan batasan pada resource khusus untuk model TensorFlow Lite, pengoptimalan model dapat membantu memastikan performa model Anda baik dan menggunakan lebih sedikit resource komputasi. Performa model machine learning biasanya merupakan keseimbangan antara ukuran dan kecepatan inferensi vs. akurasi. LiteRT saat ini mendukung pengoptimalan melalui kuantisasi, pemangkasan, dan pengelompokan. Lihat topik pengoptimalan model untuk mengetahui detail selengkapnya tentang teknik ini. TensorFlow juga menyediakan toolkit Pengoptimalan model yang menyediakan API yang menerapkan teknik ini.

Langkah berikutnya

- Untuk mulai membangun model kustom Anda, lihat tutorial mulai cepat untuk pemula di dokumentasi inti TensorFlow.

- Untuk mengonversi model TensorFlow kustom, lihat Ringkasan konversi model.

- Lihat panduan kompatibilitas operator untuk menentukan apakah model Anda kompatibel dengan LiteRT atau apakah Anda perlu melakukan langkah-langkah tambahan agar model tersebut kompatibel.

- Lihat panduan praktik terbaik performa untuk mendapatkan panduan tentang cara membuat model LiteRT Anda efisien dan berperforma tinggi.

- Lihat panduan metrik performa untuk mempelajari cara mengukur performa model Anda menggunakan alat tolok ukur.