INSAIT crea el primer LLM líder de Bulgaria con Gemma 2

El Instituto de Informática, Inteligencia Artificial y Tecnología (INSAIT) es una organización de investigación de clase mundial ubicada en Sofía, Bulgaria. Desde su fundación en 2022, INSAIT ha atraído a académicos y a investigadores de primer nivel de todo el mundo que buscan avanzar en lo que es posible en la tecnología. En su impulso para expandir la accesibilidad de los LLM en Bulgaria, INSAIT creó BgGPT, un modelo de lenguaje extenso (LLM) búlgaro que comprende tareas conversacionales y basadas en instrucciones en búlgaro y en inglés.

Después de experimentar con otros modelos para la base de BgGPT, el equipo de BgGPT decidió que la familia de modelos abiertos Gemma de Google era la más adecuada para la tarea, gracias a su mejor rendimiento en búlgaro y en inglés, y su tamaño compacto. Con las capacidades lingüísticas superiores de Gemma, INSAIT pudo crear un modelo bilingüe mucho más eficiente y eficaz.

El desafío

INSAIT observó una ausencia de modelos sólidos de procesamiento de lenguaje natural (PLN) en búlgaro, ya que la mayoría de los LLM del mundo se enfocan en el inglés o en idiomas orientales, como el chino. La escasez de modelos también implicó una falta de agentes de IA conversacional que comprendieran en profundidad el idioma búlgaro y los matices culturales, a la vez que mantuvieran un costo operativo razonable. INSAIT sabía que, si querían establecer una presencia para Bulgaria y Europa del Este en el mundo de la IA, tendrían que crear su propio LLM con un rendimiento potente y preciso.

La solución

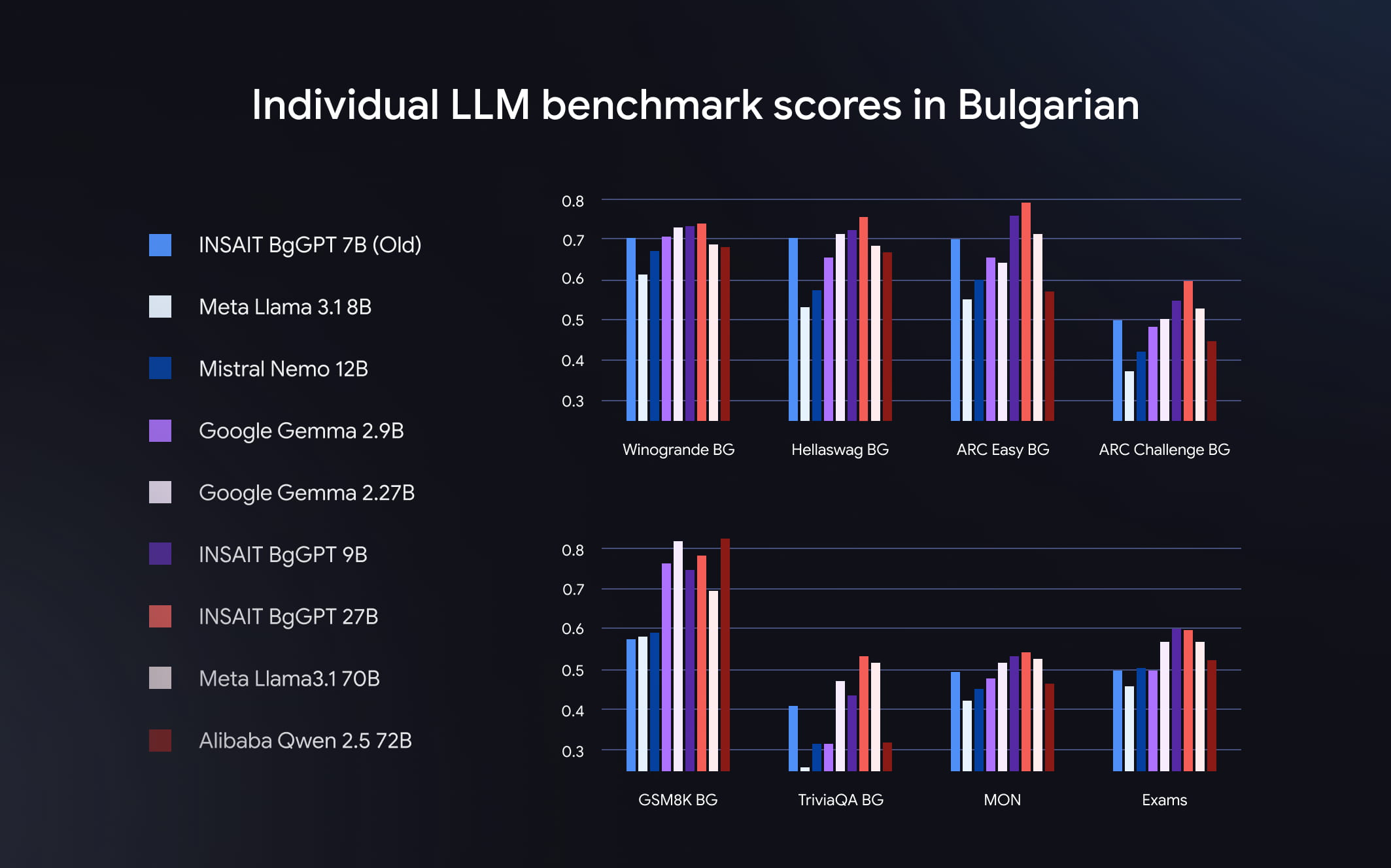

Los investigadores de INSAIT crearon BgGPT para cubrir una amplia gama de necesidades de los desarrolladores y usuarios que hablan búlgaro. El modelo tiene tamaños de parámetros de 27,000 millones, 9,000 millones y 2,000 millones. Tanto las variantes de 27,000 millones como las de 9,000 millones superan a modelos más grandes, como Qwen 2.5 de 72,000 millones de Alibaba y Llama 3.1 de 70,000 millones de Meta en búlgaro. Mientras tanto, la versión de 2B supera a otros modelos de lenguaje pequeños, como Phi 3.5 de Microsoft y Qwen 2.5 3B de Alibaba. Los tres modelos mantienen un rendimiento competitivo en inglés, gracias a las impresionantes capacidades lingüísticas de Gemma 2.

“Gemma nos ayuda a lograr un rendimiento de vanguardia en la NLP búlgara, ya que proporciona una base sólida y escalable para el ajuste fino”.

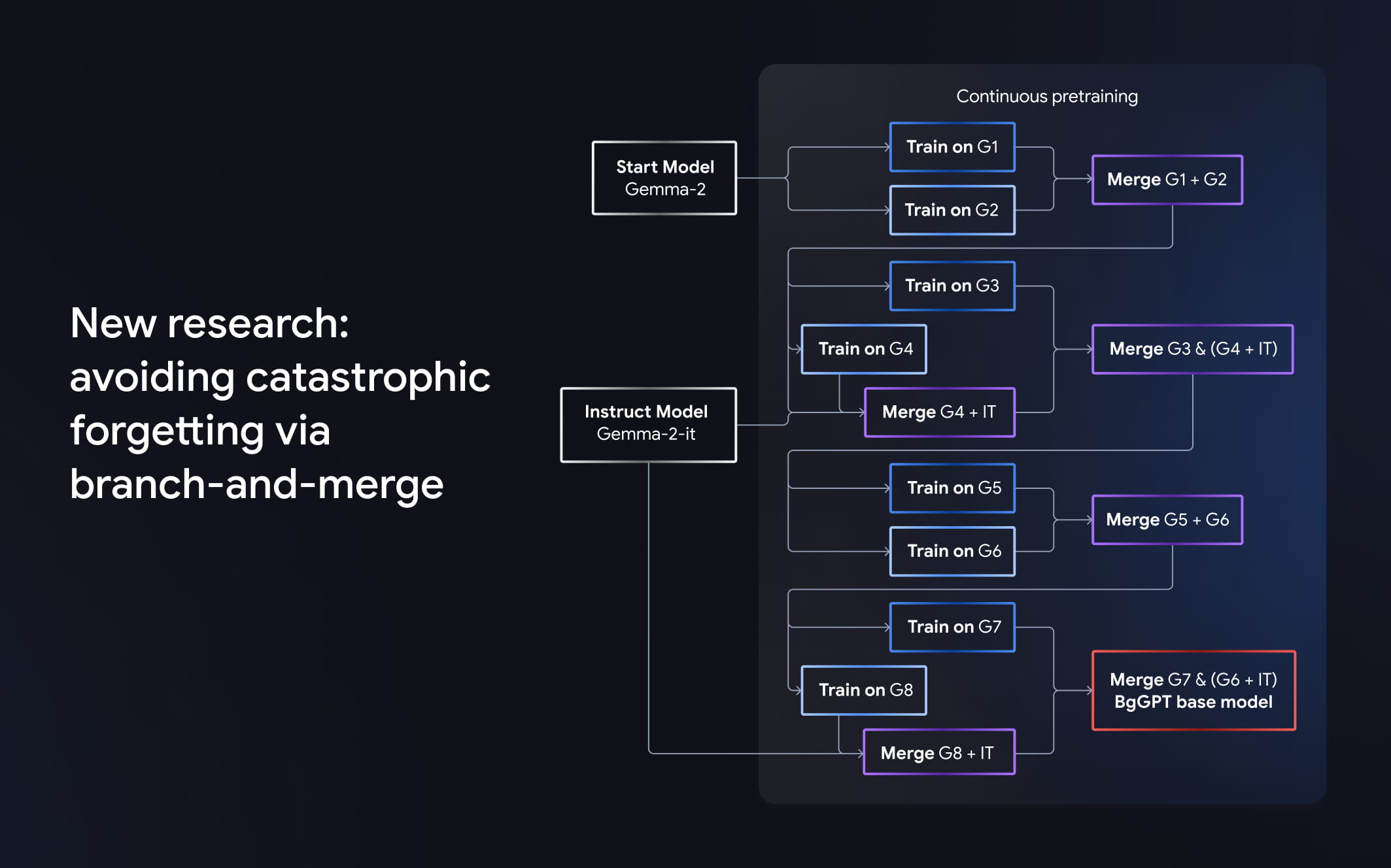

BgGPT se entrenó previamente con alrededor de 85,000 millones de tokens en búlgaro y 15,000 millones en inglés. Uno de los elementos más únicos del desarrollo de BgGPT fue el uso de la estrategia de preentrenamiento continuo Branch-and-Merge de INSAIT, que permite que el modelo aprenda información nueva, como el búlgaro, sin reemplazar ni perder información anterior, como el profundo conocimiento de Gemma de las matemáticas y el inglés. Este fenómeno se conoce como "olvido catastrófico" y sigue siendo un desafío recurrente en el desarrollo de LLM.

El impacto

BgGPT ahora potencia la plataforma de chat pública en BgGPTt.ai con sus variantes de 27B y 2B. Los modelos de 2B controlan tareas específicas, como reformular las consultas de los usuarios y la clasificación, mientras que el modelo de 27B controla los elementos de conversación. Desde su lanzamiento en marzo de 2024, BgGPT.ai respondió millones de preguntas de los usuarios. El lanzamiento de BgGPT también convierte a INSAIT en la primera organización de Europa Central y del Este en lanzar un LLM desarrollado públicamente y competitivo a nivel mundial, lo que la establece como líder en la región.

INSAIT también compartió su estrategia de entrenamiento previo continuo Branch-and-Merge con los desarrolladores, que tiene el potencial de acelerar rápidamente el crecimiento de los modelos de IA. También compartió toda su canalización de entrenamiento. La capacidad de expandir continuamente la base de conocimiento de un LLM sin perder los datos anteriores mejora la eficiencia del entrenamiento y hace que los LLM sean más inteligentes.

Más de 48,000

Descargas en Hugging Face*

5 millones

Preguntas respondidas en BgGPT.ai

- *Cantidad de descargas del 1 al 31 de diciembre de 2024

¿Qué sigue?

La adopción de BgGPT sigue creciendo. Se iniciaron programas piloto en agencias gubernamentales búlgaras, como la Agencia Nacional de Ingresos (NRA), para probar la eficacia de la LLM en situaciones especializadas. INSAIT también expresó interés en expandir el alcance de BgGPT a otras áreas, como la educación, la administración pública y las automatizaciones empresariales.

Los desarrolladores, investigadores y académicos apasionados de INSAIT se comprometen a promover la tecnología de IA en Europa del Este y en el extranjero. En el futuro, INSAIT planea mejorar BgGPT con la posible incorporación de llamadas a funciones y un mayor ajuste con modelos base más grandes, así como modelos de entrenamiento para otros países.