Mô hình mở Gemma

Một nhóm các mô hình mở, hiện đại và gọn nhẹ được xây dựng từ cùng một nghiên cứu và công nghệ dùng để tạo mô hình Gemini

Dùng thử Gemma 2

Được thiết kế lại để mang lại hiệu suất vượt trội và hiệu quả không thể so sánh, Gemma 2 tối ưu hoá để dự đoán nhanh chóng trên nhiều loại phần cứng.

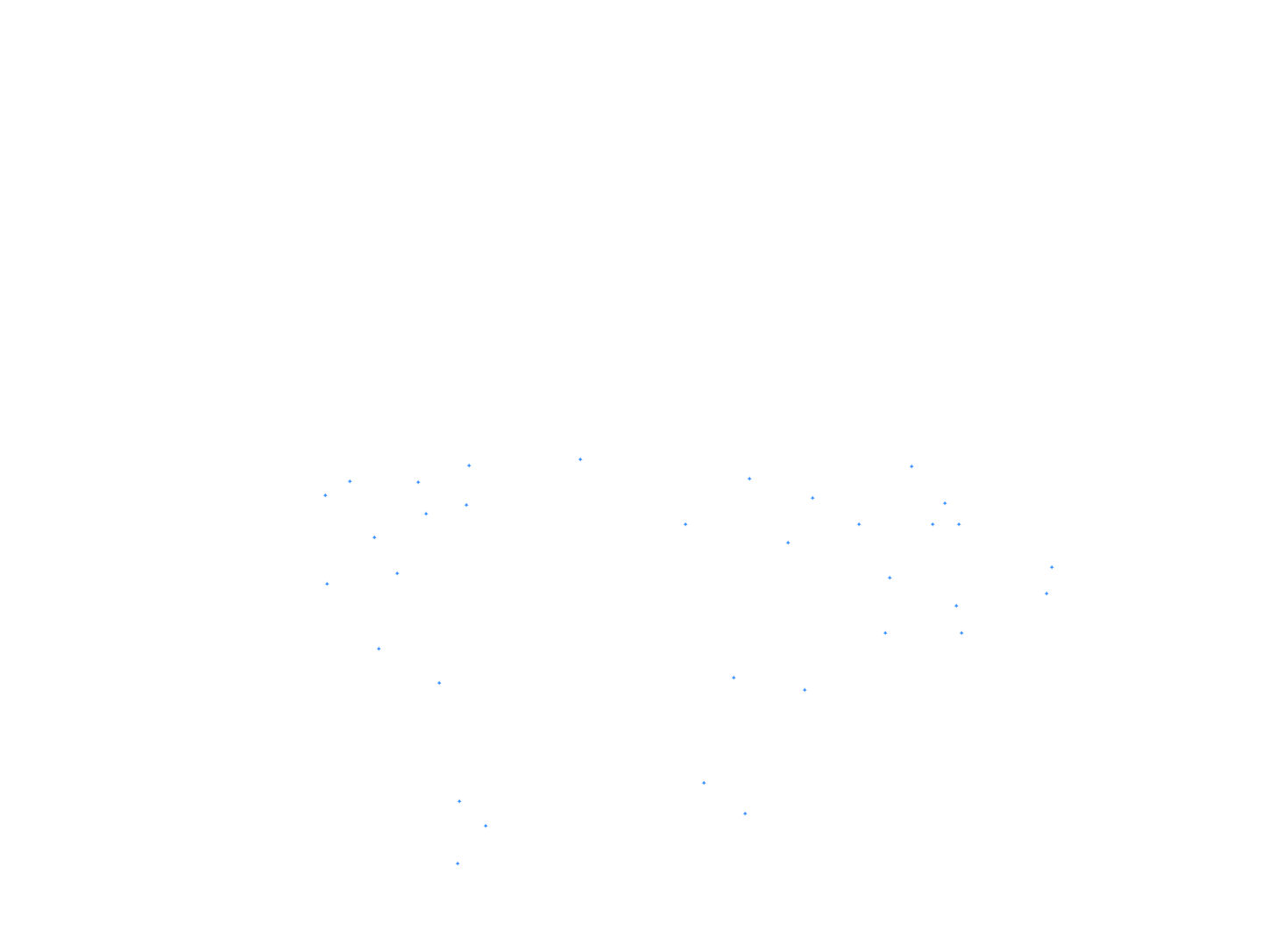

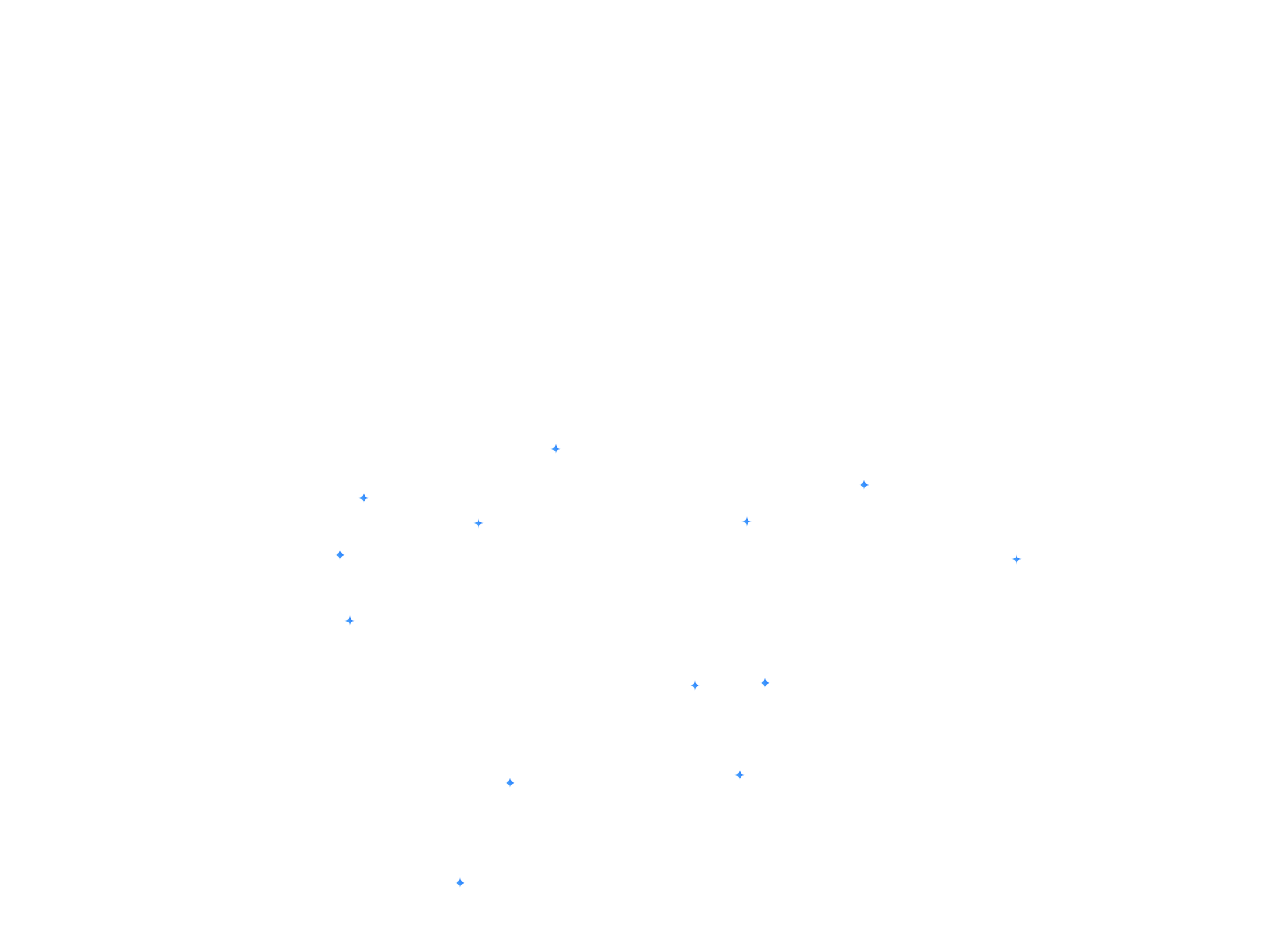

5 lần chụp

MMLU

Điểm chuẩn MMLU là một bài kiểm tra đo lường phạm vi kiến thức và khả năng giải quyết vấn đề mà các mô hình ngôn ngữ lớn có được trong quá trình huấn luyện trước.

25 ảnh

ARC-C

Điểm chuẩn ARC-c là một tập hợp con tập trung hơn của tập dữ liệu ARC-e, chỉ chứa những câu hỏi mà các thuật toán phổ biến (dựa trên truy xuất và đồng xuất hiện từ) trả lời không chính xác.

5 lần chụp

GSM8K

Điểm chuẩn GSM8K kiểm tra khả năng của một mô hình ngôn ngữ trong việc giải các bài toán ở cấp tiểu học, thường đòi hỏi nhiều bước suy luận.

3-5-shot

AGIEval

Điểm chuẩn AGIEval kiểm tra trí thông minh chung của một mô hình ngôn ngữ bằng cách sử dụng các câu hỏi bắt nguồn từ các bài kiểm tra thực tế được thiết kế để đánh giá khả năng trí tuệ của con người.

3 lần chụp, CoT

BBH

Điểm chuẩn BBH (BIG-Bench Hard) tập trung vào các nhiệm vụ được coi là vượt quá khả năng của các mô hình ngôn ngữ hiện tại, kiểm tra giới hạn của các mô hình này trên nhiều lĩnh vực suy luận và hiểu biết.

3 shot, F1

CÚI THẤP

DROP là điểm chuẩn về khả năng đọc hiểu, đòi hỏi phải có khả năng suy luận riêng biệt về các đoạn văn.

5 lần chụp

Winogrande

Điểm chuẩn Winogrande kiểm tra khả năng của một mô hình ngôn ngữ để giải quyết các nhiệm vụ điền vào chỗ trống không rõ ràng bằng các tuỳ chọn nhị phân, đòi hỏi phải có lý luận thông thường được tổng quát hoá.

10 cảnh

HellaSwag

Điểm chuẩn HellaSwag kiểm tra khả năng của mô hình ngôn ngữ trong việc hiểu và áp dụng suy luận theo lẽ thường bằng cách chọn kết thúc hợp lý nhất cho một câu chuyện.

4 cảnh quay

MATH

MATH đánh giá khả năng của một mô hình ngôn ngữ trong việc giải các bài toán đố toán học phức tạp, đòi hỏi phải suy luận, giải quyết vấn đề theo nhiều bước và hiểu các khái niệm toán học.

0-shot

ARC-e

Điểm chuẩn ARC-e kiểm tra kỹ năng trả lời câu hỏi nâng cao của một mô hình ngôn ngữ bằng các câu hỏi khoa học dạng trắc nghiệm ở cấp tiểu học.

0-shot

PIQA

Điểm chuẩn PIQA kiểm tra khả năng của một mô hình ngôn ngữ trong việc hiểu và áp dụng kiến thức thông thường về vật lý bằng cách trả lời các câu hỏi về các hoạt động tương tác vật lý hằng ngày.

0-shot

SIQA

Điểm chuẩn SIQA đánh giá khả năng hiểu biết của một mô hình ngôn ngữ về các hoạt động tương tác xã hội và tri thức xã hội thông thường bằng cách đặt câu hỏi về hành động của con người và tác động xã hội của hành động đó.

0-shot

Boolq

Điểm chuẩn BoolQ kiểm tra khả năng của mô hình ngôn ngữ trong việc trả lời các câu hỏi có/không xuất hiện tự nhiên, kiểm tra khả năng của mô hình trong việc thực hiện các nhiệm vụ suy luận bằng ngôn ngữ tự nhiên trong thực tế.

5 lần chụp

TriviaQA

Điểm chuẩn TriviaQA kiểm tra kỹ năng đọc hiểu bằng bộ ba câu hỏi-đáp án-bằng chứng.

5 lần chụp

NQ

Điểm chuẩn NQ (Câu hỏi tự nhiên) kiểm tra khả năng của một mô hình ngôn ngữ trong việc tìm và hiểu câu trả lời trong toàn bộ bài viết trên Wikipedia, mô phỏng các tình huống trả lời câu hỏi trong thực tế.

pass@1

HumanEval

Điểm chuẩn HumanEval kiểm tra khả năng tạo mã của mô hình ngôn ngữ bằng cách đánh giá xem các giải pháp của mô hình có vượt qua các bài kiểm thử đơn vị chức năng cho các vấn đề lập trình hay không.

3 lần chụp

MBPP

Điểm chuẩn MBPP kiểm tra khả năng của một mô hình ngôn ngữ trong việc giải quyết các vấn đề lập trình Python cơ bản, tập trung vào các khái niệm lập trình cơ bản và cách sử dụng thư viện chuẩn.

100%

75%

50%

25%

0%

100%

75%

50%

25%

0%

Gemma 1

2,5 tỷ

Gemma 2

2,6 tỷ

Mistral

7 tỷ

LLAMA 3

8B

Gemma 1

7 tỷ

Gemma 2

9B

Gemma 2

27 tỷ

Gemma 1

2,5 tỷ

Gemma 2

2,6 tỷ

Mistral

7 tỷ

LLAMA 3

8B

Gemma 1

7 tỷ

Gemma 2

9B

Gemma 2

27 tỷ

Gemma 1

2,5 tỷ

Gemma 2

2,6 tỷ

Mistral

7 tỷ

LLAMA 3

8B

Gemma 1

7 tỷ

Gemma 2

9B

Gemma 2

27 tỷ

Gemma 1

2,5 tỷ

Gemma 2

2,6 tỷ

Mistral

7 tỷ

LLAMA 3

8B

Gemma 1

7 tỷ

Gemma 2

9B

Gemma 2

27 tỷ

Gemma 1

2,5 tỷ

Gemma 2

2,6 tỷ

Mistral

7 tỷ

LLAMA 3

8B

Gemma 1

7 tỷ

Gemma 2

9B

Gemma 2

27 tỷ

Gemma 1

2,5 tỷ

Gemma 2

2,6 tỷ

Mistral

7 tỷ

LLAMA 3

8B

Gemma 1

7 tỷ

Gemma 2

9B

Gemma 2

27 tỷ

Gemma 1

2,5 tỷ

Gemma 2

2,6 tỷ

Mistral

7 tỷ

LLAMA 3

8B

Gemma 1

7 tỷ

Gemma 2

9B

Gemma 2

27 tỷ

Gemma 1

2,5 tỷ

Gemma 2

2,6 tỷ

Mistral

7 tỷ

LLAMA 3

8B

Gemma 1

7 tỷ

Gemma 2

9B

Gemma 2

27 tỷ

Gemma 1

2,5 tỷ

Gemma 2

2,6 tỷ

Mistral

7 tỷ

Gemma 1

7 tỷ

Gemma 2

9B

Gemma 2

27 tỷ

Gemma 1

2,5 tỷ

Gemma 2

2,6 tỷ

Mistral

7 tỷ

Gemma 1

7 tỷ

Gemma 2

9B

Gemma 2

27 tỷ

Gemma 1

2,5 tỷ

Gemma 2

2,6 tỷ

Mistral

7 tỷ

Gemma 1

7 tỷ

Gemma 2

9B

Gemma 2

27 tỷ

Gemma 1

2,5 tỷ

Gemma 2

2,6 tỷ

Mistral

7 tỷ

Gemma 1

7 tỷ

Gemma 2

9B

Gemma 2

27 tỷ

Gemma 1

2,5 tỷ

Gemma 2

2,6 tỷ

Mistral

7 tỷ

Gemma 1

7 tỷ

Gemma 2

9B

Gemma 2

27 tỷ

Gemma 1

2,5 tỷ

Gemma 2

2,6 tỷ

Mistral

7 tỷ

Gemma 1

7 tỷ

Gemma 2

9B

Gemma 2

27 tỷ

Gemma 1

2,5 tỷ

Gemma 2

2,6 tỷ

Mistral

7 tỷ

Gemma 1

7 tỷ

Gemma 2

9B

Gemma 2

27 tỷ

Gemma 1

2,5 tỷ

Gemma 2

2,6 tỷ

Mistral

7 tỷ

Gemma 1

7 tỷ

Gemma 2

9B

Gemma 2

27 tỷ

Gemma 1

2,5 tỷ

Gemma 2

2,6 tỷ

Mistral

7 tỷ

Gemma 1

7 tỷ

Gemma 2

9B

Gemma 2

27 tỷ

*Đây là điểm chuẩn cho các mô hình được huấn luyện trước, hãy xem báo cáo kỹ thuật để biết thông tin chi tiết về hiệu suất với các phương pháp khác.

Mô hình nghiên cứu

Khám phá gia đình mô hình Gemma mở rộng

Khám phá Gemmaverse

Một hệ sinh thái rộng lớn gồm các mô hình và công cụ Gemma do cộng đồng tạo ra, sẵn sàng hỗ trợ và truyền cảm hứng cho sự đổi mới của bạn

Tạo

Bắt đầu xây dựng với Gemma

Triển khai mô hình

Chọn mục tiêu triển khai

Thiết bị di động

Triển khai trên thiết bị bằng Google AI Edge

Triển khai trực tiếp trên thiết bị để có chức năng ngoại tuyến, độ trễ thấp. Lý tưởng cho các ứng dụng yêu cầu khả năng phản hồi và quyền riêng tư theo thời gian thực, chẳng hạn như ứng dụng di động, thiết bị IoT và hệ thống nhúng.

Web

Tích hợp liền mạch vào các ứng dụng web

Nâng cao hiệu quả cho trang web và dịch vụ web của bạn bằng các tính năng AI nâng cao, cho phép các tính năng tương tác, nội dung được cá nhân hoá và tính năng tự động hoá thông minh.

Đám mây

Dễ dàng mở rộng quy mô bằng cơ sở hạ tầng đám mây

Tận dụng khả năng mở rộng và linh hoạt của đám mây để xử lý các hoạt động triển khai trên quy mô lớn, khối lượng công việc đòi hỏi cao và các ứng dụng AI phức tạp.

Mở khoá khả năng giao tiếp trên toàn cầu

Tham gia cuộc thi Kaggle toàn cầu của chúng tôi. Tạo biến thể mô hình Gemma cho một ngôn ngữ cụ thể hoặc khía cạnh văn hoá độc đáo