ایجاد یک درخواست برای یک مدل هوش مصنوعی (AI) مانند Gemini یا Gemma که کاملاً هدف شما را به تصویر میکشد، میتواند یک کار غیر ضروری باشد. اغلب، شما باید یک درخواست را با دست بنویسید و سپس آن را در موارد مختلف آزمایش کنید تا مطمئن شوید که مطابق با نیازهای شما است. بر اساس نتایج، ممکن است بهروزرسانیهای هدفمندی را برای درخواست ایجاد کنید: تغییر برخی کلمات در یک مکان، افزودن یک جمله جدید در مکان دیگر. این فرآیند خیلی اصولی نیست و ممکن است به بهترین نتیجه منجر نشود.

Google روشی را توسعه داده است که از LLM برای بهروزرسانی خودکار یک الگوی درخواستی بر اساس بازخوردی که در مورد خروجی مدل به زبان ساده ارائه میکنید، استفاده میکند. بازخورد شما، همراه با اعلان و خروجی مدل، به یک LLM ارسال میشود که درخواست را بهروزرسانی میکند تا با رفتار مورد نظر شما هماهنگ شود.

این روش به دو صورت در دسترس است:

- کتابخانه Python

model-alignmentمنبع باز به شما امکان میدهد این رویکرد را به طور انعطافپذیر در نرمافزار و گردش کار خود بگنجانید. - نسخه ای از این رویکرد در Vertex AI Studio ادغام شده است و به شما امکان می دهد از این گردش کار تنها با چند کلیک استفاده کنید.

کتابخانه منبع باز

Model Alignment یک کتابخانه Python منبع باز است که به عنوان یک بسته در PyPI منتشر شده است که امکان تراز کردن درخواستهای بازخورد انسانی را از طریق یک API فراهم میکند. این کتابخانه بر اساس تحقیقات ما برای بهروزرسانی سریع از طریق بازخورد انسانی و ایجاد طبقهبندی خودکار از دادههای برچسبگذاری شده است.

با استفاده از کتابخانه Model Alignment، الگوهای درخواستی را برای Gemma انتخاب کنید

| |

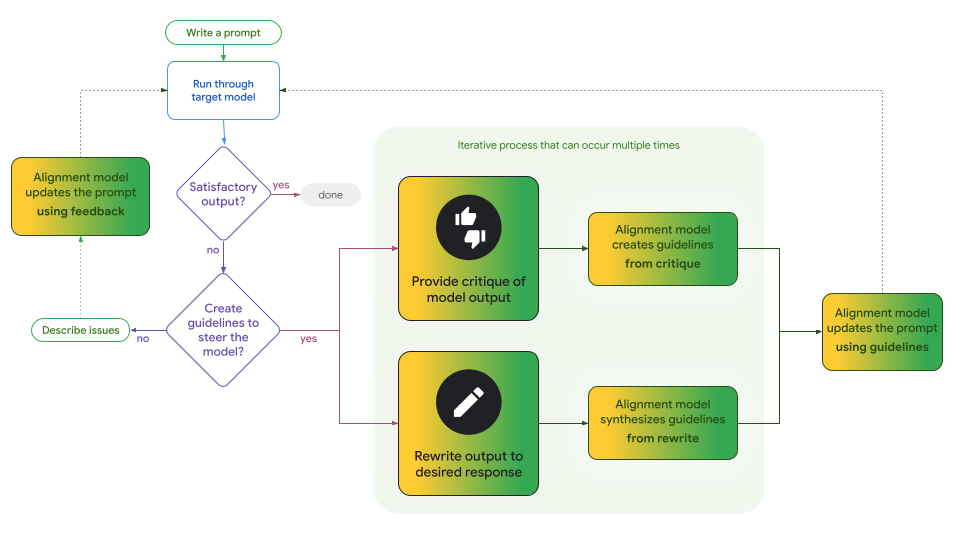

این کتابخانه از دو گردش کار برای به روز رسانی خودکار الگوهای درخواست پشتیبانی می کند:

- به روز رسانی های تکراری از اصول . این گردش کار از یک LLM برای تقطیر دستورالعملها از نقدهای غیرمستقیم خروجی مدل یا از ویرایشهای مستقیم خروجی مدل استفاده میکند. میتوانید به طور مکرر یک یا چند دستورالعمل را قبل از ارسال به LLM ایجاد کنید، که الگوی درخواستی را برای رعایت آن دستورالعملها بهروزرسانی میکند. شما همچنین می توانید دستورالعمل ها را به صورت دستی تنظیم کنید و آنها را در کنار دستورالعمل های تقطیر شده با LLM قرار دهید.

- نقد مستقیم خروجی های مدل . این گردش کار بازخورد شما را در مورد کل خروجی مدل میگیرد و آن را به همراه خروجی اعلان و مدل، مستقیماً به LLM میدهد تا یک الگوی درخواستی بهروز شده تولید کند.

این دو گردش کار ممکن است هر دو برای برنامه شما مفید باشند. معاوضه قابل توجه وجود دستورالعملهایی است که میتواند یک مصنوع فرآیندی مفید و ملموس باشد که میتواند به اطلاعرسانی، برای مثال، رویکرد شما به شفافیت کمک کند.

شکل 1. این فلوچارت نشان می دهد که کجا و چگونه دو جریان کار کتابخانه Model Alignment برای فعال کردن به روز رسانی های دستورالعمل محور یا مستقیم به الگوهای درخواستی شما از هم جدا می شوند. توجه داشته باشید که این فرآیند تکراری است و این گردشهای کاری متقابلاً انحصاری نیستند، میتوانید در هر زمان بین آنها جابجا شوید.

نوت بوک Colab را بررسی کنید که از Gemini برای تراز کردن دستورات Gemma 2 با استفاده از هر دو گردش کار استفاده می کند.

تراز در Vertex AI Studio

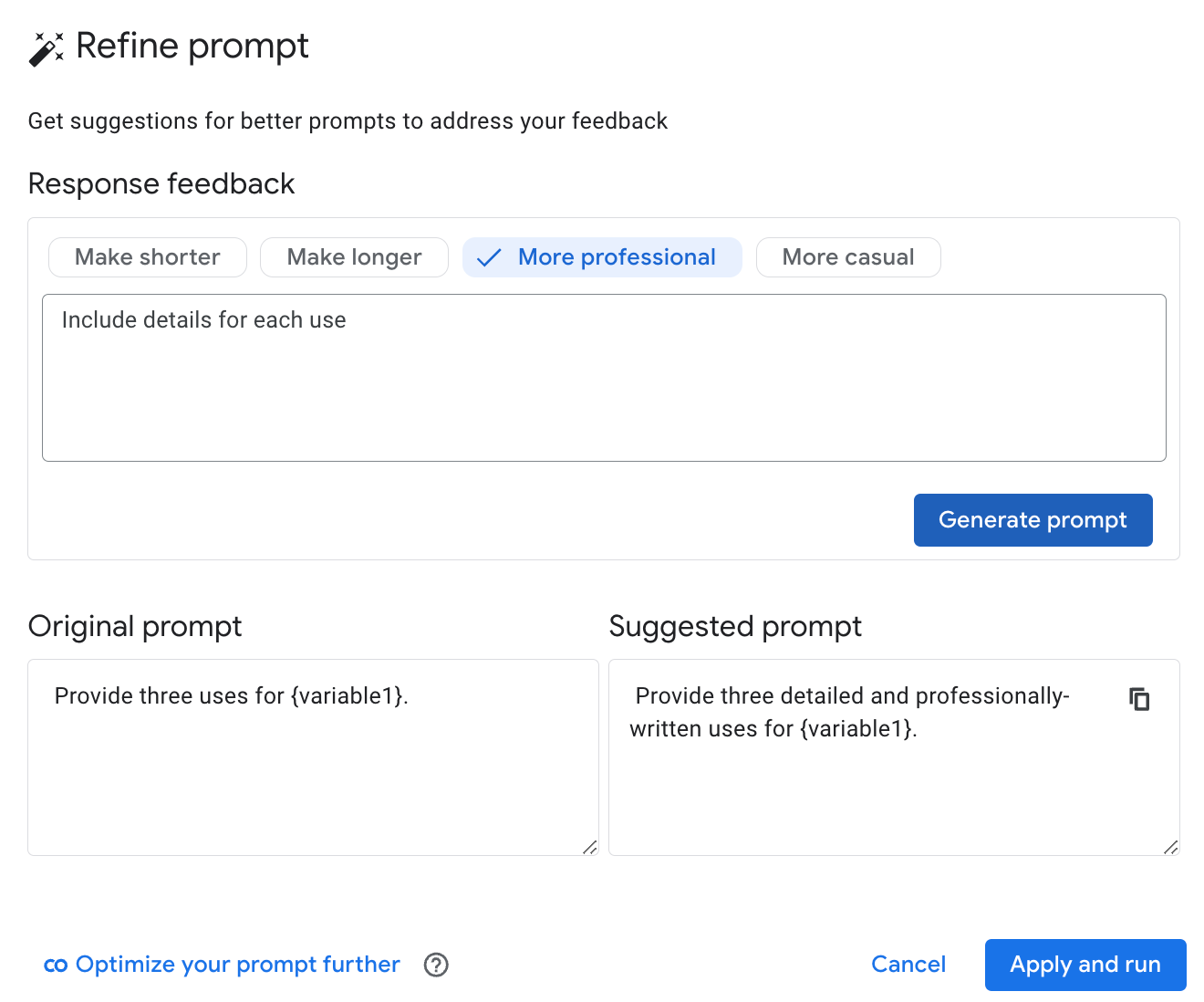

استودیوی Vertex AI Google یک ویژگی «تصحیح سریع» را بر اساس گردش کار مستقیم از کتابخانه منبع باز Model Alignment اضافه کرده است تا ابزارهای تألیف، اجرا، ارزیابی و مقایسه آن را تحسین کند.

پس از اجرای یک درخواست، میتوانید بازخوردی در مورد روشهایی ارائه دهید که مدل باید متفاوت رفتار کند، و Vertex AI Studio از Gemini برای پیشنویس بازنویسی استفاده میکند. می توانید تغییرات پیشنهادی را بپذیرید و با کلیک یک دکمه دستور به روز شده را مجدداً اجرا کنید یا بازخورد خود را به روز کنید و از Gemini یک نامزد دیگر بخواهید.

شکل 2. ویژگی "تصفیه اعلان" Vertex AI Studio که برای به روز رسانی یک درخواست بر اساس بازخورد کاربر استفاده می شود.

پیوندها

تراز مدل را برای خودتان کاوش کنید:

- این نوت بوک Colab را اجرا کنید که از Gemini برای تراز کردن اعلان های مختلف برای مدل Gemma 2 وزن باز ما با استفاده از هر دو روش تراز استفاده می کند.

- ویژگی همترازی مدل «Refine Prompt» را در Vertex AI Studio امتحان کنید.