에지 플랫폼에서 고성능 ML 및 생성형 AI 배포

효율적인 변환, 런타임, 기기 내 머신러닝 최적화

실전에서 검증된 TensorFlow Lite 기반으로 구축

LiteRT는 새로운 기능일 뿐만 아니라 전 세계에서 가장 널리 배포된 머신러닝 런타임의 차세대 버전입니다. 매일 사용하는 앱을 지원하며 수십억 대의 기기에서 짧은 지연 시간과 높은 개인 정보 보호를 제공합니다.

가장 중요한 Google 앱에서 신뢰함

10만 개 이상의 애플리케이션, 수십억 명의 전 세계 사용자

LiteRT 하이라이트

크로스 플랫폼 지원

생성형 AI 활용

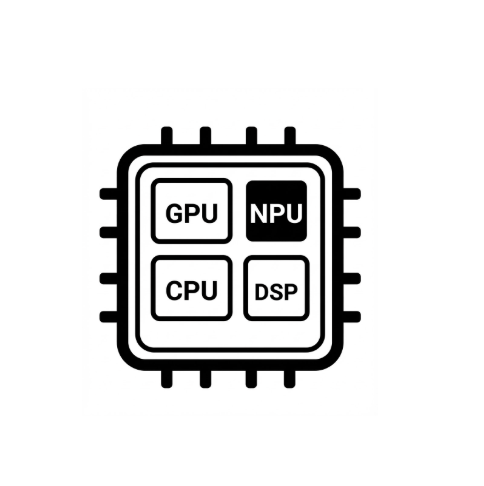

간소화된 하드웨어 가속

다중 프레임워크 지원

LiteRT를 통해 배포

모델 획득

.tflite 선행 학습된 모델 사용 또는 PyTorch, JAX, TensorFlow 모델을 .tflite로 변환

모델 최적화

선택적으로 모델 양자화

실행

원하는 가속기를 선택하고 LiteRT에서 실행

샘플, 모델, 데모

샘플 앱 보기

튜토리얼에서는 완벽한 엔드 투 엔드 예제와 함께 LiteRT를 사용하는 방법을 보여줍니다.

생성형 AI 모델 보기

선행 학습된 즉시 사용 가능한 생성형 AI 모델

데모 보기 - Google AI Edge 갤러리 앱

온디바이스 ML/생성형 AI 사용 사례를 보여주는 갤러리