Segmentuesit e imazheve parashikojnë nëse çdo piksel i një imazhi është i lidhur me një klasë të caktuar. Kjo është në kontrast me zbulimin e objekteve, i cili zbulon objektet në rajone drejtkëndëshe, dhe klasifikimin e imazheve, i cili klasifikon imazhin në tërësi. Shihni shembullin e përmbledhjes së segmentimit të imazheve për më shumë informacion rreth segmentuesve të imazheve.

Përdorni API-n ImageSegmenter të Bibliotekës së Detyrave për të vendosur segmentuesit e imazheve të personalizuar ose ata të parapërgatitur në aplikacionet tuaja mobile.

Karakteristikat kryesore të API-t ImageSegmenter

Përpunimi i imazhit hyrës, duke përfshirë rrotullimin, ndryshimin e madhësisë dhe konvertimin e hapësirës së ngjyrave.

Etiketo vendndodhjen e hartës.

Dy lloje rezultatesh, maska e kategorisë dhe maska e besimit.

Etiketë me ngjyra për qëllime shfaqjeje.

Modelet e segmentuesit të imazhit të mbështetura

Modelet e mëposhtme garantohen të jenë të pajtueshme me ImageSegmenter API.

Modelet e segmentimit të imazhit të para-trajnuara në TensorFlow Hub .

Modele të personalizuara që plotësojnë kërkesat e përputhshmërisë së modelit .

Ekzekutoni përfundimin në Java

Shihni aplikacionin referues të Segmentimit të Imazheve për një shembull se si të përdorni ImageSegmenter në një aplikacion Android.

Hapi 1: Importoni varësinë e Gradle dhe cilësimet e tjera

Kopjoni skedarin e modelit .tflite në direktorinë e aseteve të modulit Android ku do të ekzekutohet modeli. Specifikoni që skedari nuk duhet të kompresohet dhe shtoni bibliotekën TensorFlow Lite në skedarin build.gradle të modulit:

android {

// Other settings

// Specify tflite file should not be compressed for the app apk

aaptOptions {

noCompress "tflite"

}

}

dependencies {

// Other dependencies

// Import the Task Vision Library dependency

implementation 'org.tensorflow:tensorflow-lite-task-vision'

// Import the GPU delegate plugin Library for GPU inference

implementation 'org.tensorflow:tensorflow-lite-gpu-delegate-plugin'

}

Hapi 2: Përdorimi i modelit

// Initialization

ImageSegmenterOptions options =

ImageSegmenterOptions.builder()

.setBaseOptions(BaseOptions.builder().useGpu().build())

.setOutputType(OutputType.CONFIDENCE_MASK)

.build();

ImageSegmenter imageSegmenter =

ImageSegmenter.createFromFileAndOptions(context, modelFile, options);

// Run inference

List<Segmentation> results = imageSegmenter.segment(image);

Shihni kodin burimor dhe javadoc për më shumë opsione për të konfiguruar ImageSegmenter .

Ekzekutoni përfundimin në iOS

Hapi 1: Instaloni varësitë

Biblioteka e Detyrave mbështet instalimin duke përdorur CocoaPods. Sigurohuni që CocoaPods është instaluar në sistemin tuaj. Ju lutemi shihni udhëzuesin e instalimit të CocoaPods për udhëzime.

Ju lutemi shihni udhëzuesin e CocoaPods për detaje mbi shtimin e pod-eve në një projekt Xcode.

Shtoni pod-in TensorFlowLiteTaskVision në Podfile.

target 'MyAppWithTaskAPI' do

use_frameworks!

pod 'TensorFlowLiteTaskVision'

end

Sigurohuni që modeli .tflite që do të përdorni për nxjerrjen e përfundimeve është i pranishëm në paketën e aplikacionit tuaj.

Hapi 2: Përdorimi i modelit

I shpejtë

// Imports

import TensorFlowLiteTaskVision

// Initialization

guard let modelPath = Bundle.main.path(forResource: "deeplabv3",

ofType: "tflite") else { return }

let options = ImageSegmenterOptions(modelPath: modelPath)

// Configure any additional options:

// options.outputType = OutputType.confidenceMasks

let segmenter = try ImageSegmenter.segmenter(options: options)

// Convert the input image to MLImage.

// There are other sources for MLImage. For more details, please see:

// https://developers.google.com/ml-kit/reference/ios/mlimage/api/reference/Classes/GMLImage

guard let image = UIImage (named: "plane.jpg"), let mlImage = MLImage(image: image) else { return }

// Run inference

let segmentationResult = try segmenter.segment(mlImage: mlImage)

Objektivi-C

// Imports

#import <TensorFlowLiteTaskVision/TensorFlowLiteTaskVision.h>

// Initialization

NSString *modelPath = [[NSBundle mainBundle] pathForResource:@"deeplabv3" ofType:@"tflite"];

TFLImageSegmenterOptions *options =

[[TFLImageSegmenterOptions alloc] initWithModelPath:modelPath];

// Configure any additional options:

// options.outputType = TFLOutputTypeConfidenceMasks;

TFLImageSegmenter *segmenter = [TFLImageSegmenter imageSegmenterWithOptions:options

error:nil];

// Convert the input image to MLImage.

UIImage *image = [UIImage imageNamed:@"plane.jpg"];

// There are other sources for GMLImage. For more details, please see:

// https://developers.google.com/ml-kit/reference/ios/mlimage/api/reference/Classes/GMLImage

GMLImage *gmlImage = [[GMLImage alloc] initWithImage:image];

// Run inference

TFLSegmentationResult *segmentationResult =

[segmenter segmentWithGMLImage:gmlImage error:nil];

Shihni kodin burimor për më shumë opsione për të konfiguruar TFLImageSegmenter .

Ekzekutoni përfundimin në Python

Hapi 1: Instaloni paketën pip

pip install tflite-support

Hapi 2: Përdorimi i modelit

# Imports

from tflite_support.task import vision

from tflite_support.task import core

from tflite_support.task import processor

# Initialization

base_options = core.BaseOptions(file_name=model_path)

segmentation_options = processor.SegmentationOptions(

output_type=processor.SegmentationOptions.output_type.CATEGORY_MASK)

options = vision.ImageSegmenterOptions(base_options=base_options, segmentation_options=segmentation_options)

segmenter = vision.ImageSegmenter.create_from_options(options)

# Alternatively, you can create an image segmenter in the following manner:

# segmenter = vision.ImageSegmenter.create_from_file(model_path)

# Run inference

image_file = vision.TensorImage.create_from_file(image_path)

segmentation_result = segmenter.segment(image_file)

Shihni kodin burimor për më shumë opsione për të konfiguruar ImageSegmenter .

Ekzekutoni përfundimin në C++

// Initialization

ImageSegmenterOptions options;

options.mutable_base_options()->mutable_model_file()->set_file_name(model_path);

std::unique_ptr<ImageSegmenter> image_segmenter = ImageSegmenter::CreateFromOptions(options).value();

// Create input frame_buffer from your inputs, `image_data` and `image_dimension`.

// See more information here: tensorflow_lite_support/cc/task/vision/utils/frame_buffer_common_utils.h

std::unique_ptr<FrameBuffer> frame_buffer = CreateFromRgbRawBuffer(

image_data, image_dimension);

// Run inference

const SegmentationResult result = image_segmenter->Segment(*frame_buffer).value();

Shihni kodin burimor për më shumë opsione për të konfiguruar ImageSegmenter .

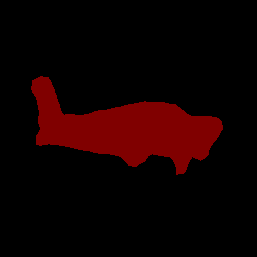

Rezultatet e shembujve

Ja një shembull i rezultateve të segmentimit të deeplab_v3 , një model i përgjithshëm segmentimi i disponueshëm në TensorFlow Hub.

Color Legend:

(r: 000, g: 000, b: 000):

index : 0

class name : background

(r: 128, g: 000, b: 000):

index : 1

class name : aeroplane

# (omitting multiple lines for conciseness) ...

(r: 128, g: 192, b: 000):

index : 19

class name : train

(r: 000, g: 064, b: 128):

index : 20

class name : tv

Tip: use a color picker on the output PNG file to inspect the output mask with

this legend.

Maska e kategorisë së segmentimit duhet të duket si kjo:

Provoni mjetin e thjeshtë demo CLI për ImageSegmenter me modelin tuaj dhe të dhënat e testimit.

Kërkesat e përputhshmërisë së modelit

API-ja ImageSegmenter pret një model TFLite me Metadata të Modelit TFLite të detyrueshme. Shihni shembuj të krijimit të metadatave për segmentuesit e imazheve duke përdorur API-në e Shkruesit të Metadatave TensorFlow Lite .

Tensori i imazhit të hyrjes (kTfLiteUInt8/kTfLiteFloat32)

- madhësia e hyrjes së imazhit

[batch x height x width x channels]. - Përfundimi i grupit nuk mbështetet (

batchduhet të jetë 1). - Mbështeten vetëm hyrjet RGB (

channelsduhet të jenë 3). - Nëse lloji është kTfLiteFloat32, NormalizationOptions duhet t'i bashkëngjiten meta të dhënave për normalizimin e hyrjes.

- madhësia e hyrjes së imazhit

Tensori i maskave të daljes: (kTfLiteUInt8/kTfLiteFloat32)

- tenzori i madhësisë

[batch x mask_height x mask_width x num_classes], kubatchkërkohet të jetë 1,mask_widthdhemask_heightjanë dimensionet e maskave të segmentimit të prodhuara nga modeli, dhenum_classesështë numri i klasave të mbështetura nga modeli. - Hartat opsionale (por të rekomanduara) të etiketave mund të bashkëngjiten si AssociatedFile-s me llojin TENSOR_AXIS_LABELS, që përmbajnë një etiketë për rresht. AssociatedFile i parë i tillë (nëse ka) përdoret për të mbushur fushën e

label(e emërtuar siclass_namenë C++) të rezultateve. Fushadisplay_nameplotësohet nga AssociatedFile (nëse ka) lokalizimi i të cilit përputhet me fushëndisplay_names_localetëImageSegmenterOptionstë përdorur në kohën e krijimit ("en" si parazgjedhje, dmth. Anglisht). Nëse asnjëra prej këtyre nuk është e disponueshme, vetëm fusha eindextë rezultateve do të plotësohet.

- tenzori i madhësisë