모바일, 웹, 삽입된 애플리케이션 전반에 AI 배포

-

기기에 보관

지연 시간 감소 오프라인에서 작업합니다. 데이터를 로컬에서 비공개로 유지합니다.

-

크로스 플랫폼

Android, iOS, 웹, 삽입된 환경에서 동일한 모델을 실행합니다.

-

멀티 프레임워크

JAX, Keras, PyTorch, TensorFlow 모델과 호환됩니다.

-

전체 AI 에지 스택

유연한 프레임워크, 턴키 솔루션, 하드웨어 가속기

기성 솔루션 및 유연한 프레임워크

교차 플랫폼에서 커스텀 모델 배포

기존 ML 및 생성형 AI에 최적화된 JAX, Keras, PyTorch, TensorFlow 모델을 Android, iOS, 웹, 삽입된 기기에서 성능 좋게 실행합니다.

LiteRT 시작하기

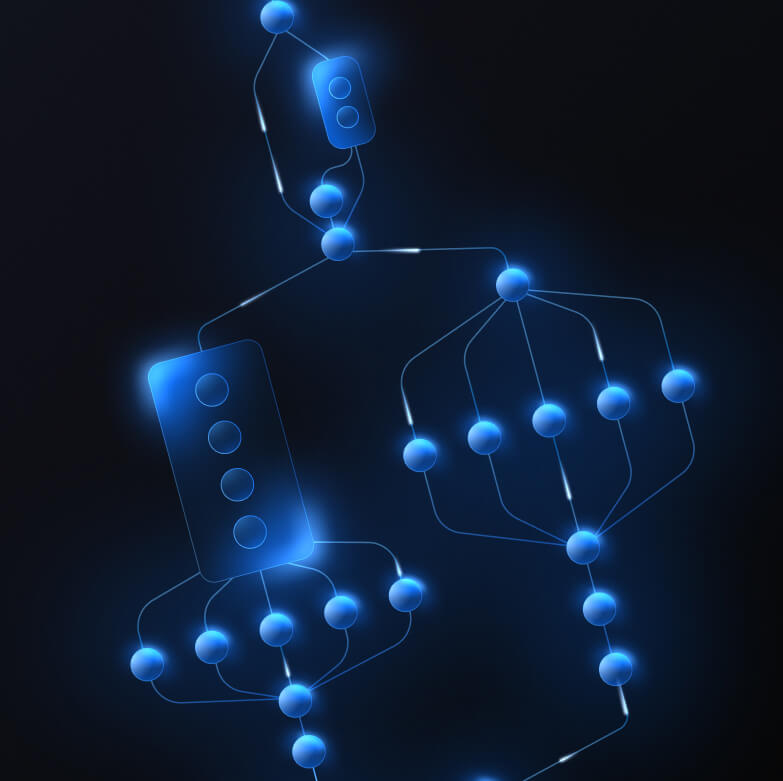

복잡한 ML 기능을 위한 맞춤 파이프라인 빌드

사전 처리 및 사후 처리 로직과 함께 여러 ML 모델을 성능적으로 체이닝하여 자체 태스크를 빌드합니다. CPU에서 차단 없이 가속 (GPU 및 NPU) 파이프라인을 실행합니다.

MediaPipe 프레임워크 시작하기

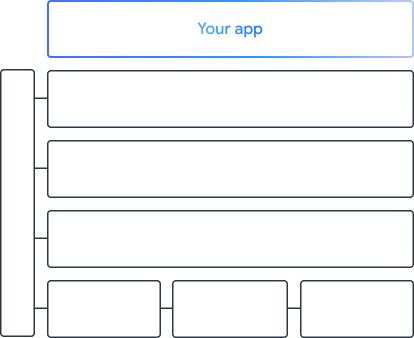

Google 앱을 지원하는 도구 및 프레임워크

로우 코드 API에서 하드웨어별 가속 라이브러리까지 모든 수준의 제품을 갖춘 전체 AI 에지 스택을 살펴보세요.

MediaPipe Tasks

MediaPipe Tasks

생성형 AI, 컴퓨터 비전, 텍스트, 오디오에 걸쳐 일반적인 작업을 위한 로우 코드 API를 사용하여 모바일 및 웹 앱에 AI 기능을 빠르게 빌드하세요.

생성형 AI

즉시 사용 가능한 API를 사용하여 생성형 언어 및 이미지 모델을 앱에 직접 통합하세요.

Vision

세분화, 분류, 감지, 인식, 신체 지형지물에 걸쳐 다양한 비전 작업을 살펴보세요.

텍스트 및 오디오

언어, 감정, 자체 맞춤 카테고리를 비롯한 다양한 카테고리에서 텍스트와 오디오를 분류합니다.

MediaPipe 프레임워크

MediaPipe 프레임워크

고성능 가속 ML 파이프라인을 빌드하는 데 사용되는 하위 수준 프레임워크로, 전처리 및 후처리와 결합된 여러 ML 모델을 포함하는 경우가 많습니다.

LiteRT

LiteRT

최적화된 하드웨어별 가속을 통해 모바일, 웹, 마이크로컨트롤러 전반에 어떤 프레임워크로 작성된 AI 모델이든 배포합니다.

멀티 프레임워크

JAX, Keras, PyTorch, TensorFlow의 모델을 변환하여 에지에서 실행합니다.

크로스 플랫폼

네이티브 SDK를 사용하여 Android, iOS, 웹, 마이크로컨트롤러에서 동일한 모델을 실행합니다.

가볍고 빠름

LiteRT의 효율적인 런타임은 메가바이트 단위의 공간만 차지하며 CPU, GPU, NPU 전반에서 모델 가속을 지원합니다.

모델 탐색기

모델 탐색기

모델을 시각적으로 탐색, 디버그, 비교합니다. 성능 벤치마크와 숫자를 오버레이하여 문제가 있는 핫스팟을 파악합니다.

Android 및 Chrome의 Gemini Nano

Google의 가장 강력한 온디바이스 모델을 사용하여 생성형 AI 환경 빌드