在行動、網頁和嵌入式應用程式中部署 AI

-

裝置上

減少延遲時間。離線工作。將資料保留在本機並確保隱私。

-

跨平台

在 Android、iOS、網頁和嵌入式中執行相同的模型。

-

多架構

與 JAX、Keras、PyTorch 和 TensorFlow 模型相容。

-

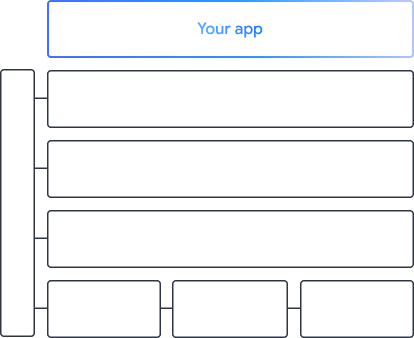

完整 AI 邊緣堆疊

彈性架構、一站式解決方案、硬體加速器

現成解決方案和彈性架構

跨平台部署自訂模型

在 Android、iOS、網頁和嵌入式裝置上執行 JAX、Keras、PyTorch 和 TensorFlow 模型,並針對傳統機器學習和生成式 AI 進行最佳化。

開始使用 LiteRT

支援 Google 應用程式的工具和架構

探索完整的 AI 邊緣堆疊,其中包含各層級的產品,從低程式碼 API 到硬體專屬加速程式庫皆囊括其中。

MediaPipe Tasks

MediaPipe Tasks

使用低程式碼 API,在行動應用程式和網頁應用程式中快速建構 AI 功能,用於處理涵蓋生成式 AI、電腦視覺、文字和音訊的常見工作。

生成式 AI

使用現成 API,將生成式語言和圖像模型直接整合至應用程式。

Vision

探索多種視覺工作,包括區隔、分類、偵測、辨識和人體標記。

文字和音訊

將文字和音訊分類至多個類別,包括語言、情緒和自訂類別。

MediaPipe 架構

MediaPipe 架構

用於建構高效加速機器學習管道的低階架構,通常會結合多個機器學習模型,並搭配前後處理。

LiteRT

LiteRT

在行動裝置、網頁和微控制器上部署使用任何架構編寫的 AI 模型,並享有最佳化的硬體專屬加速功能。

多架構

將 JAX、Keras、PyTorch 和 TensorFlow 的模型轉換為可在邊緣裝置上執行的模型。

跨平台

在 Android、iOS、網頁和微控制器上,使用原生 SDK 執行相同的模型。

輕巧快速

LiteRT 的執行階段效率極高,只會佔用幾 MB 的空間,並可在 CPU、GPU 和 NPU 上加速模型。

Model Explorer

Model Explorer

以視覺化方式探索、偵錯及比較模型。重疊顯示效能基準和數值,找出問題熱點。

Android 和 Chrome 中的 Gemini Nano

使用 Google 最強大的裝置端模型,建構生成式 AI 體驗