Esegui il deployment dell'AI in applicazioni mobile, web e incorporate

-

Sul dispositivo

Riduci la latenza. Lavora offline. Mantieni i tuoi dati locali e privati.

-

Multipiattaforma

Esegui lo stesso modello su Android, iOS, web e in modalità incorporata.

-

Multi-framework

Compatibile con i modelli JAX, Keras, PyTorch e TensorFlow.

-

Stack edge AI completo

Framework flessibili, soluzioni chiavi in mano, acceleratori hardware

Soluzioni pronte all'uso e framework flessibili

API low-code per attività di IA comuni

API multipiattaforma per gestire attività comuni di AI generativa, visione, testo e audio.

Inizia a utilizzare le attività MediaPipeEsegui il deployment di modelli personalizzati su più piattaforme

Esegui modelli JAX, Keras, PyTorch e TensorFlow su Android, iOS, web e dispositivi embedded, ottimizzati per il machine learning tradizionale e l'IA generativa.

Iniziare a utilizzare LiteRT

Abbrevia i cicli di sviluppo con la visualizzazione

Visualizza la trasformazione del modello tramite conversione e quantizzazione. Esegui il debug degli hotspot sovrapponendo i risultati dei benchmark.

Iniziare a utilizzare Esplorazione modelli

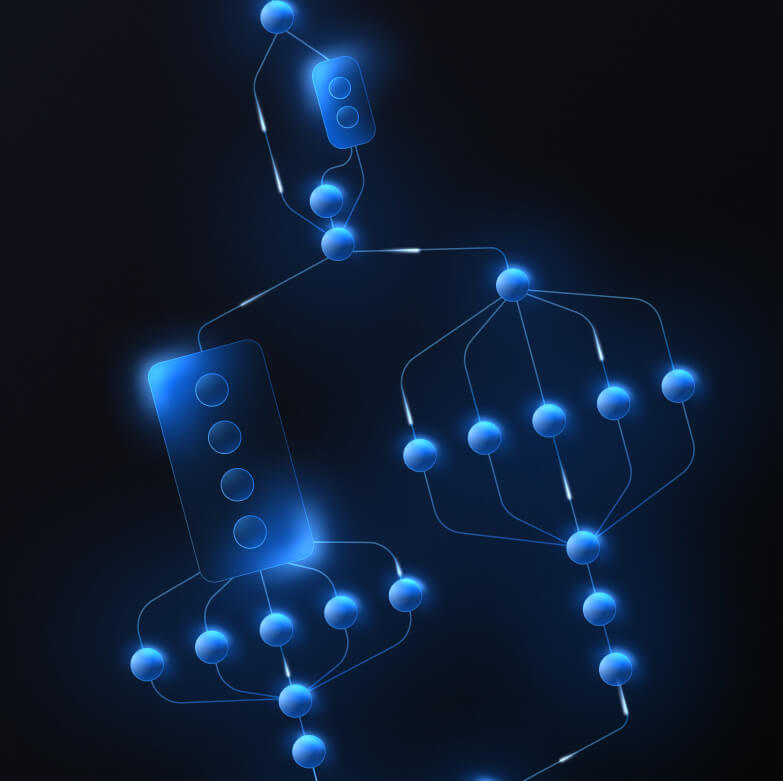

Crea pipeline personalizzate per funzionalità ML complesse

Crea la tua attività incatenando in modo efficiente più modelli ML insieme alla logica di pre e post-elaborazione. Esegui pipeline accelerate (GPU e NPU) senza blocchi sulla CPU.

Iniziare a utilizzare il framework MediaPipe

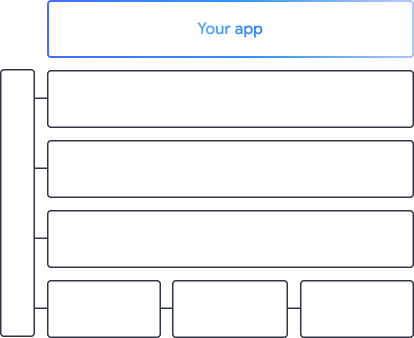

Gli strumenti e i framework alla base delle app di Google

Esplora l'intera AI edge stack, con prodotti a ogni livello, dalle API low-code alle librerie di accelerazione specifiche per l'hardware.

MediaPipe Tasks

MediaPipe Tasks

Integra rapidamente funzionalità di IA nelle app mobile e web utilizzando API low-code per attività comuni che spaziano dall'IA generativa alla visione artificiale, dal testo all'audio.

AI generativa

Integra modelli di linguaggio e immagini generative direttamente nelle tue app con API pronte all'uso.

Vision

Esplora una vasta gamma di attività di visione che comprendono segmentazione, classificazione, rilevamento, riconoscimento e punti di riferimento del corpo.

Testo e audio

Classifica il testo e l'audio in molte categorie, tra cui lingua, sentiment e le tue categorie personalizzate.

Inizia

Framework MediaPipe

Framework MediaPipe

Un framework di basso livello utilizzato per creare pipeline ML accelerate ad alte prestazioni, spesso con più modelli ML combinati con l'elaborazione precedente e successiva.

LiteRT

LiteRT

Esegui il deployment di modelli di IA creati in qualsiasi framework su dispositivi mobili, web e microcontrollori con accelerazione specifica dell'hardware ottimizzata.

Multi-framework

Converti i modelli da JAX, Keras, PyTorch e TensorFlow per eseguirli all'edge.

Multipiattaforma

Esegui lo stesso identico modello su Android, iOS, web e microcontrollori con SDK nativi.

Leggero e veloce

Il runtime efficiente di LiteRT occupa solo pochi megabyte e consente l'accelerazione dei modelli su CPU, GPU e NPU.

Inizia

Esplorazione modelli

Esplorazione modelli

Esplora, esegui il debug e confronta visivamente i tuoi modelli. Sovrapponi benchmark e dati numerici sul rendimento per individuare gli hotspot problematici.

Gemini Nano su Android e Chrome

Crea esperienze di IA generativa utilizzando il modello on-device più potente di Google