Vendosni AI në celular, ueb dhe aplikacione të integruara

Në pajisje

Ulja e vonesës. Punoni jashtë linje. Mbajini të dhënat tuaja lokale dhe private.

Ndër-platformë

Ekzekutoni të njëjtin model në Android, iOS, ueb dhe të integruar.

Multi-kornizë

E përputhshme me modelet JAX, Keras, PyTorch dhe TensorFlow.

Stack i plotë i skajeve të AI

Korniza fleksibël, zgjidhje me çelës në dorë, përshpejtues harduerësh

Zgjidhje të gatshme dhe korniza fleksibël

API me kod të ulët për detyrat e zakonshme të AI

API-të ndër-platformë për të trajtuar detyrat e zakonshme gjeneruese të AI, vizion, tekst dhe audio.

Filloni me detyrat MediaPipeVendosni modele të personalizuara ndër-platformë

Drejtoni në mënyrë performuese modelet JAX, Keras, PyTorch dhe TensorFlow në pajisjet Android, iOS, ueb dhe të integruara, të optimizuara për ML tradicionale dhe AI gjeneruese.

Filloni me LiteRT

Shkurtoni ciklet e zhvillimit me vizualizim

Vizualizoni transformimin e modelit tuaj përmes konvertimit dhe kuantizimit. Korrigjoni pikat kryesore duke mbivendosur rezultatet e standardeve.

Filloni me Model Explorer

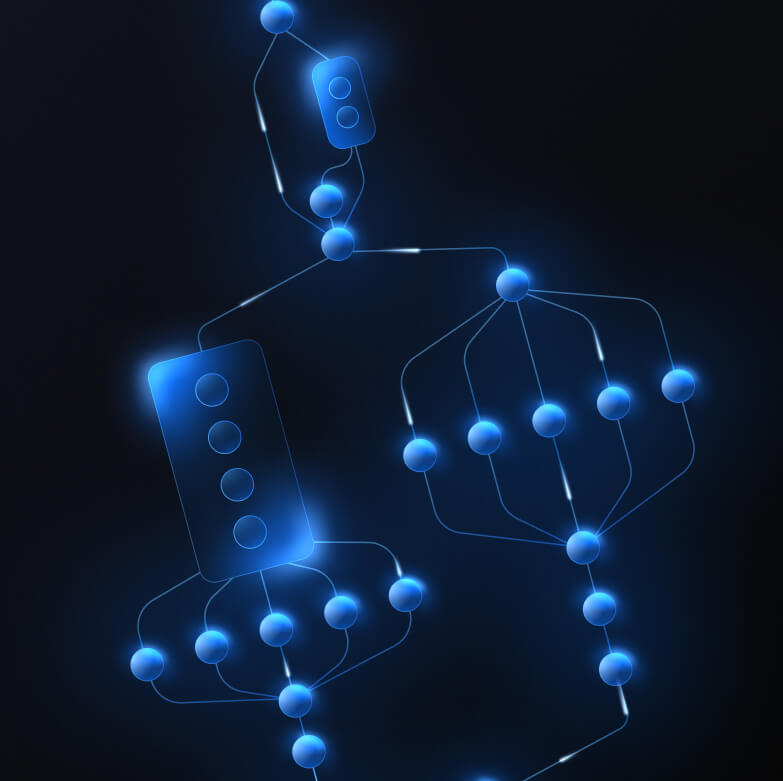

Ndërtoni tubacione të personalizuara për veçori komplekse ML

Ndërtoni detyrën tuaj duke lidhur me performancë modele të shumta ML së bashku me logjikën e përpunimit para dhe pas. Drejtoni tubacionet e përshpejtuara (GPU & NPU) pa bllokuar CPU.

Filloni me MediaPipe Framework

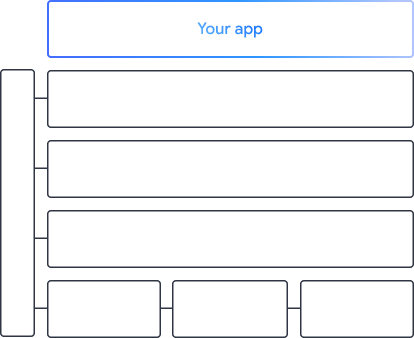

Mjetet dhe kornizat që fuqizojnë aplikacionet e Google

Eksploroni grupin e plotë të skajeve të AI, me produkte në çdo nivel - nga API-të me kod të ulët deri te bibliotekat specifike të përshpejtimit të harduerit.

Detyrat MediaPipe

Detyrat MediaPipe

Ndërtoni me shpejtësi veçoritë e AI në aplikacione celulare dhe në ueb duke përdorur API me kod të ulët për detyra të zakonshme që përfshijnë AI gjeneruese, vizion kompjuterik, tekst dhe audio.

AI gjeneruese

Integroni gjuhë gjeneruese dhe modele imazhi direkt në aplikacionet tuaja me API të gatshme për përdorim.

Vizioni

Eksploroni një gamë të madhe detyrash vizioni që përfshijnë segmentimin, klasifikimin, zbulimin, njohjen dhe pikat referuese të trupit.

Tekst dhe audio

Klasifikoni tekstin dhe audion në shumë kategori, duke përfshirë gjuhën, ndjenjat dhe kategoritë tuaja të personalizuara.

Filloni

Dokumentacioni i detyrave

Gjeni të gjitha detyrat tona të gatshme me kod të ulët MediaPipe me dokumentacion dhe mostra kodesh.

Detyrat gjeneruese të AI

Ekzekutoni LLM dhe modelet e difuzionit në avantazh me detyrat tona gjeneruese të AI nga MediaPipe.

Provoni demonstrimet

Eksploroni bibliotekën tonë të MediaPipe Tasks dhe provoni ato vetë.

Dokumentacioni i prodhuesit të modelit

Personalizoni modelet në detyrat tona MediaPipe me të dhënat tuaja.