Gemma オープンモデル

Gemini モデルの作成に使用されたものと同じ研究とテクノロジーに基づいて構築された、軽量で最先端のオープンモデルのファミリー

Gemma 2 を試す

圧倒的なパフォーマンスと比類のない効率性のために再設計された Gemma 2 は、さまざまなハードウェアで超高速の推論を実現するように最適化されています。

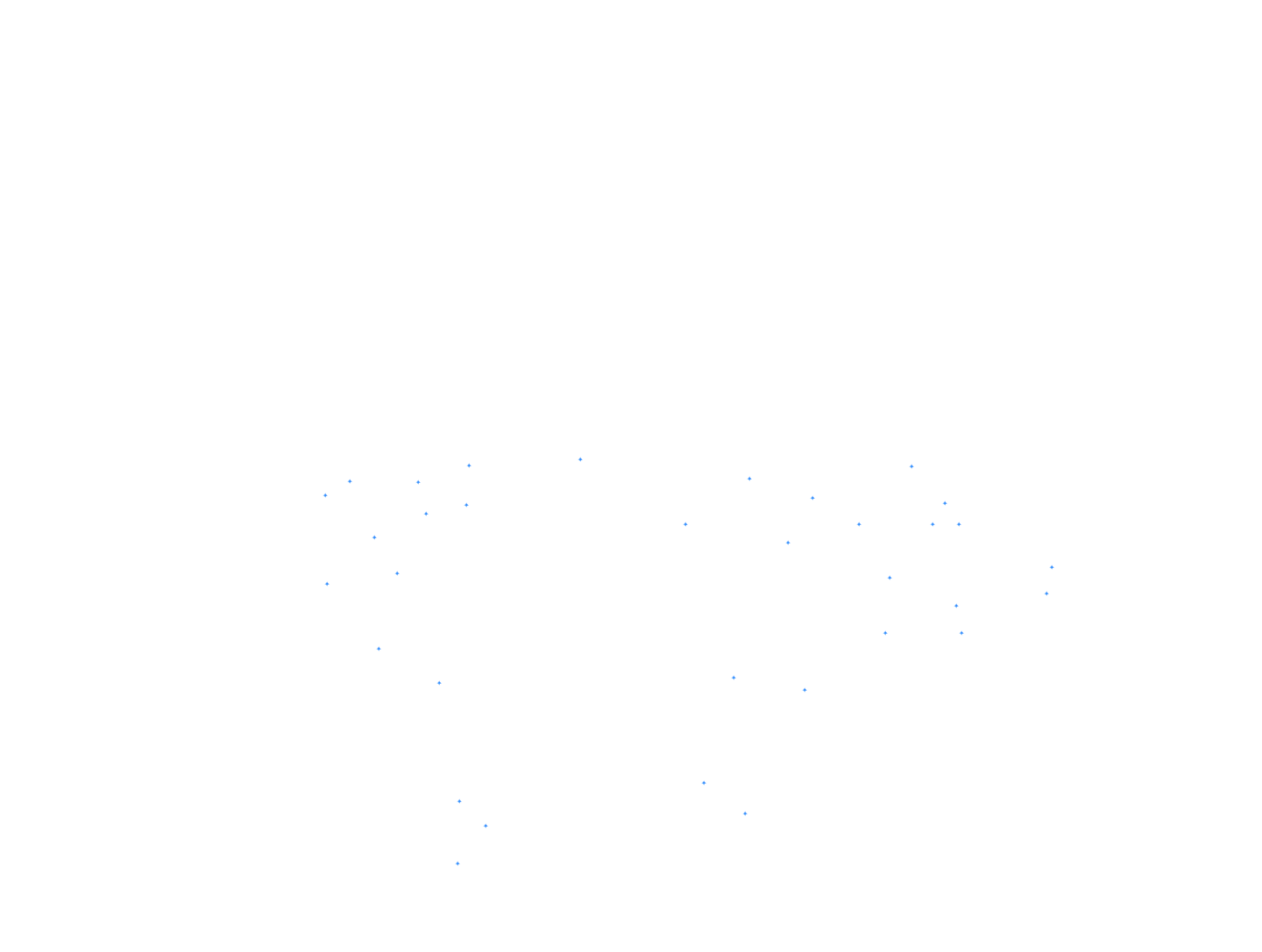

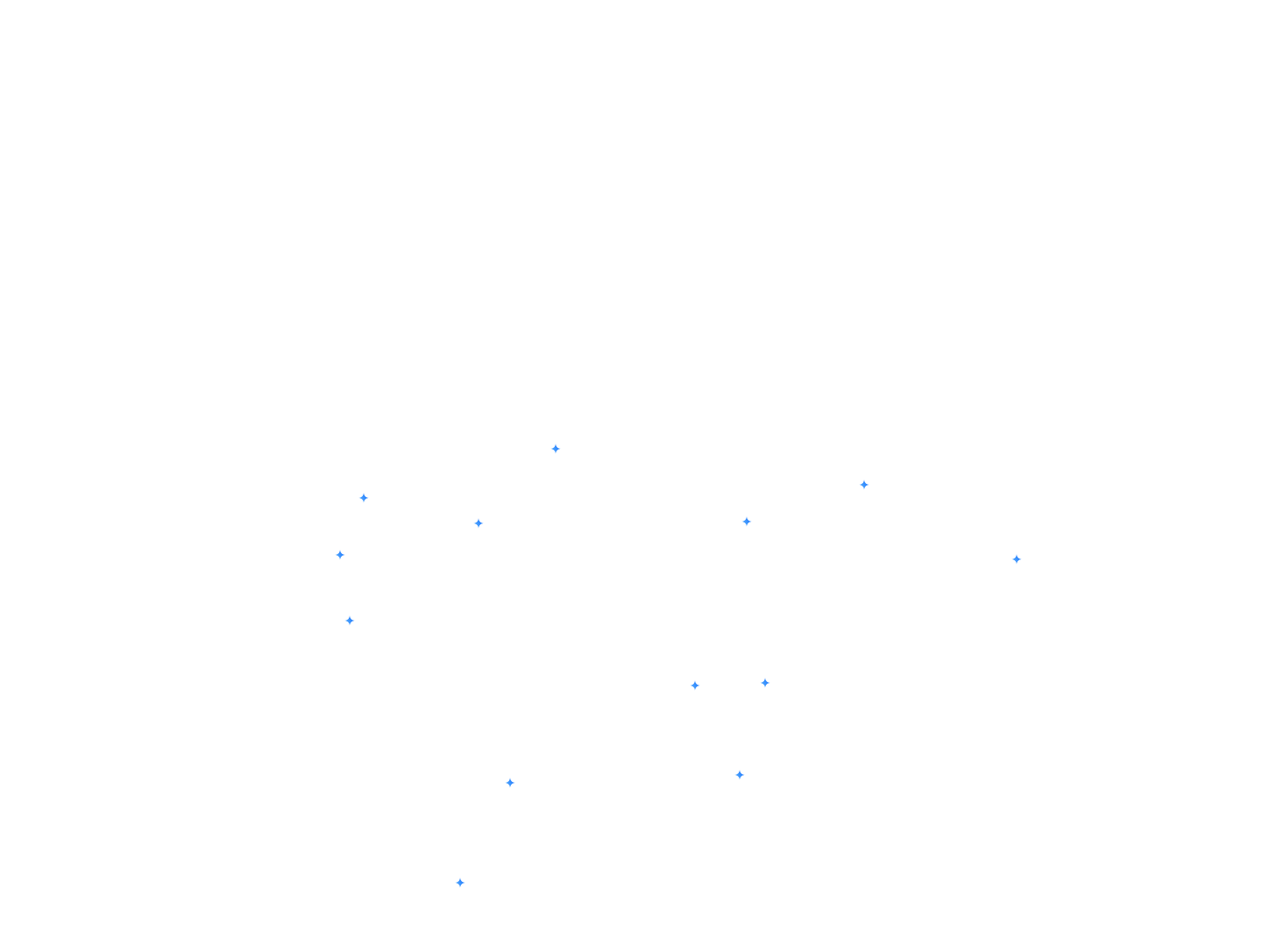

5 ショット

MMLU

MMLU ベンチマークは、大規模言語モデルが事前トレーニング中に獲得した知識の広さと問題解決能力を測定するテストです。

25 ショット

ARC-C

ARC-c ベンチマークは、ARC-e データセットのより限定的なサブセットであり、一般的な(検索ベースと単語の共起)アルゴリズムで誤って回答された質問のみが含まれています。

5 ショット

GSM8K

GSM8K ベンチマークは、複数の推論ステップが必要な小学校レベルの数学の問題を解く言語モデルの能力をテストします。

3 ~ 5 ショット

AGIEval

AGIEval ベンチマークでは、人間の知的能力を評価するために設計された実際の試験から得られた質問を使用して、言語モデルの一般的な知能をテストします。

3 ショット、CoT

BBH

BBH(BIG-Bench Hard)ベンチマークは、現在の言語モデルの能力を超えていると見なされるタスクに焦点を当て、さまざまな推論と理解のドメインでその限界をテストします。

3 ショット、F1

DROP

DROP は、段落に関する個別の推論を必要とする読解力ベンチマークです。

5 ショット

Winogrande

Winogrande ベンチマークは、一般化された常識的推論を必要とする、バイナリ オプションによるあいまいな穴埋めタスクを解決する言語モデルの能力をテストします。

10 ショット

HellaSwag

HellaSwag ベンチマークは、物語の最も論理的な結末を選択することで、常識的な推論を理解して適用する言語モデルの能力をテストします。

4 ショット

MATH

MATH は、推論、複数ステップの問題解決、数学のコンセプトの理解を必要とする複雑な数学の問題を解く言語モデルの能力を評価します。

ゼロショット

ARC-e

ARC-e ベンチマークは、小学校レベルの実際の科学に関する多肢選択式の問題を使用して、言語モデルの高度な質問応答スキルをテストします。

ゼロショット

PIQA

PIQA ベンチマークは、日常的な物理的な相互作用に関する質問に回答することで、物理的な常識的な知識を理解して適用する言語モデルの能力をテストします。

ゼロショット

SIQA

SIQA ベンチマークでは、人々の行動とその社会的影響について質問することで、言語モデルが社会的インタラクションと社会的常識をどの程度理解しているかを評価します。

ゼロショット

Boolq

BoolQ ベンチマークは、自然発生する「はい/いいえ」の質問に回答する言語モデルの能力をテストし、現実世界の自然言語推論タスクを実行するモデルの能力をテストします。

5 ショット

TriviaQA

TriviaQA ベンチマークは、質問、回答、証拠のトリプルを使用して読解力をテストします。

5 ショット

NQ

NQ(自然な質問)ベンチマークは、Wikipedia 記事全体で回答を見つけて理解する言語モデルの能力をテストし、実際の質問応答シナリオをシミュレートします。

pass@1

HumanEval

HumanEval ベンチマークは、ソリューションがプログラミング問題の機能単体テストに合格するかどうかを評価することで、言語モデルのコード生成能力をテストします。

3 ショット

MBPP

MBPP ベンチマークは、基本的なプログラミングのコンセプトと標準ライブラリの使用に焦点を当てて、基本的な Python プログラミングの問題を解決する言語モデルの能力をテストします。

100%

75%

50%

25%

0%

100%

75%

50%

25%

0%

Gemma 1

25 億

Gemma 2

26 億

Mistral

70 億人

LLAMA 3

8B

Gemma 1

70 億人

Gemma 2

90 億

Gemma 2

270 億

Gemma 1

25 億

Gemma 2

26 億

Mistral

70 億人

LLAMA 3

8B

Gemma 1

70 億人

Gemma 2

90 億

Gemma 2

270 億

Gemma 1

25 億

Gemma 2

26 億

Mistral

70 億人

LLAMA 3

8B

Gemma 1

70 億人

Gemma 2

90 億

Gemma 2

270 億

Gemma 1

25 億

Gemma 2

26 億

Mistral

70 億人

LLAMA 3

8B

Gemma 1

70 億人

Gemma 2

90 億

Gemma 2

270 億

Gemma 1

25 億

Gemma 2

26 億

Mistral

70 億人

LLAMA 3

8B

Gemma 1

70 億人

Gemma 2

90 億

Gemma 2

270 億

Gemma 1

25 億

Gemma 2

26 億

Mistral

70 億人

LLAMA 3

8B

Gemma 1

70 億人

Gemma 2

90 億

Gemma 2

270 億

Gemma 1

25 億

Gemma 2

26 億

Mistral

70 億人

LLAMA 3

8B

Gemma 1

70 億人

Gemma 2

90 億

Gemma 2

270 億

Gemma 1

25 億

Gemma 2

26 億

Mistral

70 億人

LLAMA 3

8B

Gemma 1

70 億人

Gemma 2

90 億

Gemma 2

270 億

Gemma 1

25 億

Gemma 2

26 億

Mistral

70 億人

Gemma 1

70 億人

Gemma 2

90 億

Gemma 2

270 億

Gemma 1

25 億

Gemma 2

26 億

Mistral

70 億人

Gemma 1

70 億人

Gemma 2

90 億

Gemma 2

270 億

Gemma 1

25 億

Gemma 2

26 億

Mistral

70 億人

Gemma 1

70 億人

Gemma 2

90 億

Gemma 2

270 億

Gemma 1

25 億

Gemma 2

26 億

Mistral

70 億人

Gemma 1

70 億人

Gemma 2

90 億

Gemma 2

270 億

Gemma 1

25 億

Gemma 2

26 億

Mistral

70 億人

Gemma 1

70 億人

Gemma 2

90 億

Gemma 2

270 億

Gemma 1

25 億

Gemma 2

26 億

Mistral

70 億人

Gemma 1

70 億人

Gemma 2

90 億

Gemma 2

270 億

Gemma 1

25 億

Gemma 2

26 億

Mistral

70 億人

Gemma 1

70 億人

Gemma 2

90 億

Gemma 2

270 億

Gemma 1

25 億

Gemma 2

26 億

Mistral

70 億人

Gemma 1

70 億人

Gemma 2

90 億

Gemma 2

270 億

Gemma 1

25 億

Gemma 2

26 億

Mistral

70 億人

Gemma 1

70 億人

Gemma 2

90 億

Gemma 2

270 億

*これは事前トレーニング済みモデルのベンチマークです。他の手法でのパフォーマンスの詳細については、技術レポートをご覧ください。

モデルを調査する

Gemma 拡張モデル ファミリーについて

Gemmaverse を探索する

コミュニティが作成した Gemma モデルとツールの広大なエコシステム。イノベーションを推進し、刺激します。

構築

Gemma で構築を開始する

モデルのデプロイ

デプロイ ターゲットを選択する

モバイル

Google AI Edge を使用してデバイスにデプロイする

デバイスに直接デプロイして、低レイテンシのオフライン機能を実現します。モバイルアプリ、IoT デバイス、組み込みシステムなど、リアルタイムの応答性とプライバシーが必要なアプリケーションに最適です。

ウェブ

ウェブ アプリケーションにシームレスに統合

高度な AI 機能によりウェブサイトとウェブサービスを強化し、インタラクティブな機能、パーソナライズされたコンテンツ、インテリジェントな自動化を実現します。

クラウド

クラウド インフラストラクチャで簡単にスケーリングする

クラウドのスケーラビリティと柔軟性を活用して、大規模なデプロイ、負荷の高いワークロード、複雑な AI アプリケーションを処理します。

グローバルなコミュニケーションを可能にする

グローバルな Kaggle コンペティションに参加しましょう。特定の言語や独自の文化的側面に対応する Gemma モデルのバリエーションを作成する