Ngày 30 tháng 10 năm 2024

Đưa các AI Agent vào hoạt động sản xuất bằng Gemini API

Việc xây dựng và triển khai các tác nhân AI là một bước tiến thú vị, nhưng việc quản lý các hệ thống phức tạp này trong môi trường phát hành chính thức đòi hỏi khả năng quan sát mạnh mẽ. AgentOps là một SDK Python để theo dõi tác nhân, theo dõi chi phí LLM, đo điểm chuẩn và nhiều tính năng khác, giúp nhà phát triển chuyển tác nhân từ nguyên mẫu sang sản xuất, đặc biệt là khi kết hợp với sức mạnh và hiệu quả chi phí của Gemini API.

Lợi thế của Gemini

Adam Silverman, Giám đốc vận hành của Agency AI (nhóm phát triển AgentOps) giải thích rằng chi phí là một yếu tố quan trọng đối với các doanh nghiệp triển khai tác nhân AI ở quy mô lớn. "Chúng tôi nhận thấy các doanh nghiệp chi 80.000 USD mỗi tháng cho các lệnh gọi LLM. Với Gemini 1.5, chi phí cho cùng một kết quả sẽ là vài nghìn đô la".

Tính hiệu quả về chi phí này, kết hợp với khả năng hiểu và tạo ngôn ngữ mạnh mẽ của Gemini, khiến Gemini trở thành lựa chọn lý tưởng cho các nhà phát triển xây dựng những tác nhân AI tinh vi. Silverman cho biết: "Gemini 1.5 Flash mang lại cho chúng tôi chất lượng tương đương với các mô hình lớn hơn, với chi phí thấp hơn nhiều và tốc độ cực kỳ nhanh". Nhờ đó, nhà phát triển có thể tập trung vào việc xây dựng quy trình làm việc phức tạp, nhiều bước của tác nhân mà không lo lắng về chi phí vượt quá.

"Chúng tôi nhận thấy mỗi lần chạy của một tác nhân riêng lẻ với các nhà cung cấp LLM khác có chi phí từ 500 USD trở lên. Những lần chạy tương tự với Gemini (1.5 Flash-8B) có chi phí dưới 50 USD".

Hỗ trợ tác nhân AI

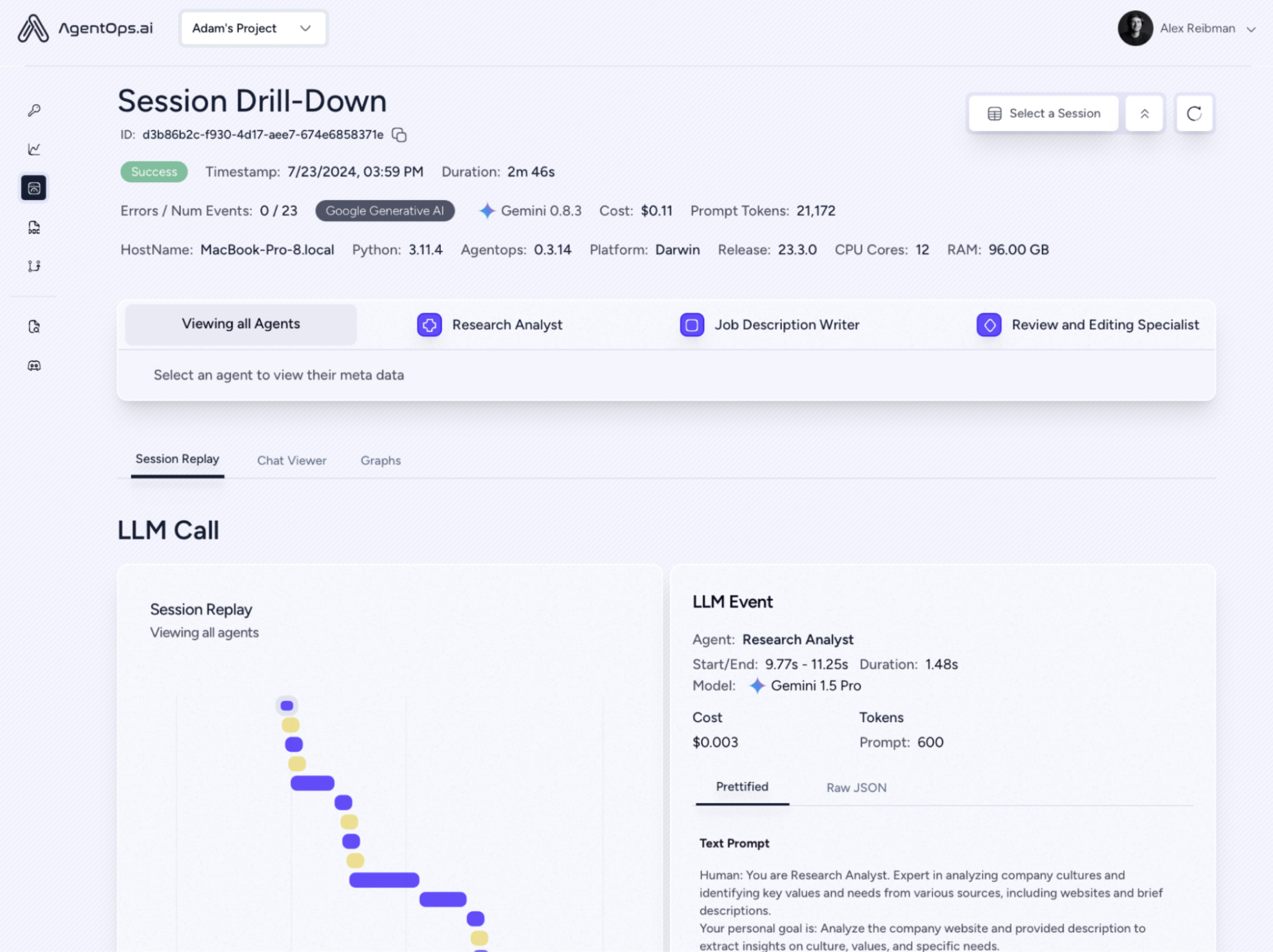

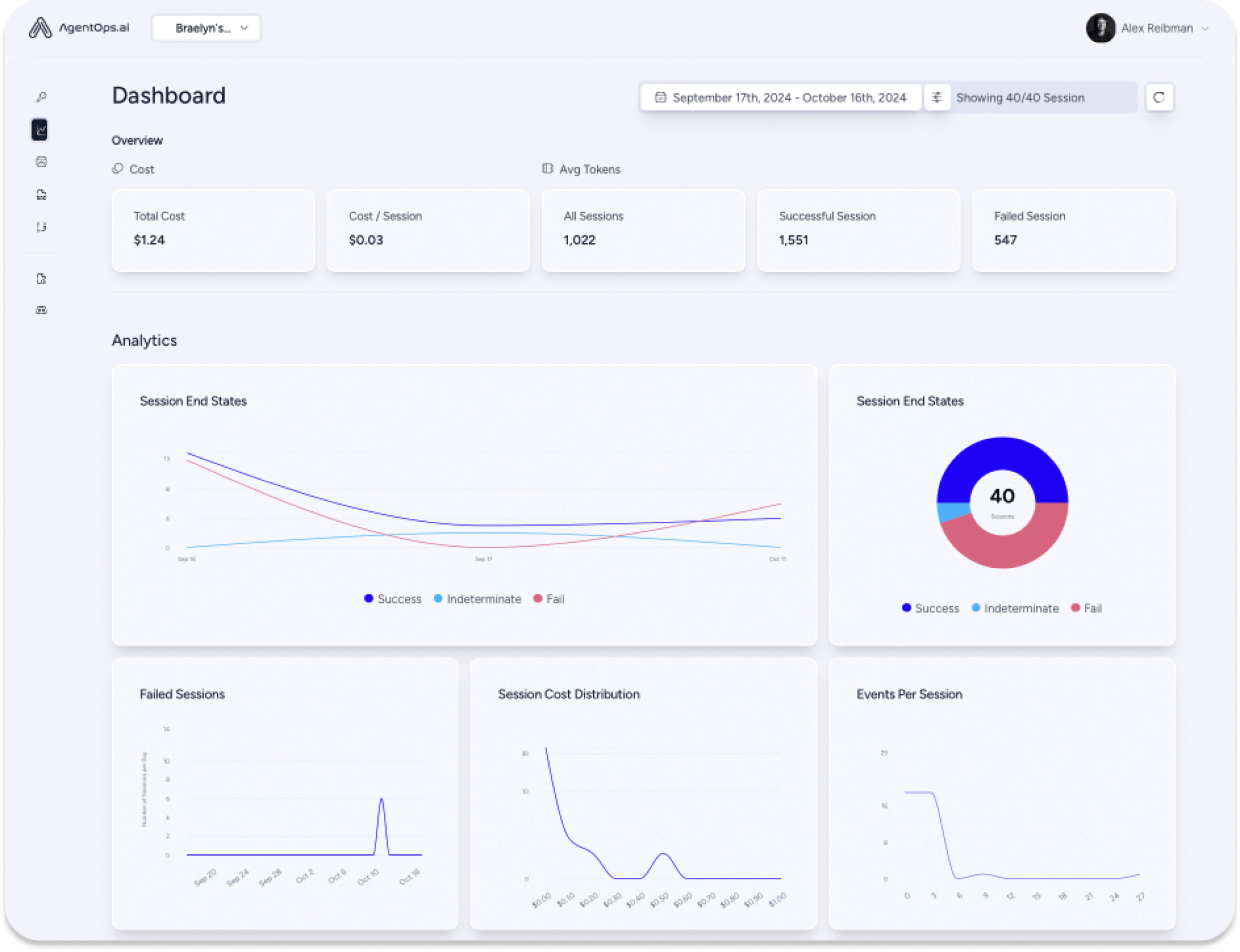

AgentOps thu thập dữ liệu về mọi lượt tương tác của tác nhân, không chỉ các lệnh gọi LLM, mang đến cái nhìn toàn diện về cách các hệ thống đa tác nhân hoạt động. Mức độ chi tiết này là điều cần thiết cho các nhóm kỹ thuật và tuân thủ, cung cấp thông tin chi tiết quan trọng cho việc gỡ lỗi, tối ưu hoá và nhật ký kiểm tra.

Việc tích hợp các mô hình Gemini với AgentOps rất đơn giản, thường chỉ mất vài phút khi sử dụng LiteLLM. Các nhà phát triển có thể nhanh chóng nắm được thông tin về các lệnh gọi Gemini API, theo dõi chi phí theo thời gian thực và đảm bảo độ tin cậy của các tác nhân trong quá trình sản xuất.

Hướng đến tương lai

AgentOps cam kết hỗ trợ các nhà phát triển nhân viên hỗ trợ khi họ mở rộng quy mô dự án. AI của công ty quảng cáo đang giúp các doanh nghiệp giải quyết những vấn đề phức tạp khi xây dựng các tác nhân có chi phí hợp lý và có khả năng mở rộng, từ đó củng cố thêm đề xuất giá trị của việc kết hợp AgentOps với Gemini API. Như Silverman nhấn mạnh, "Điều này sẽ thu hút nhiều nhà phát triển chú trọng đến giá cả hơn để xây dựng các tác nhân".

Đối với những nhà phát triển đang cân nhắc sử dụng Gemini, Silverman đưa ra lời khuyên rõ ràng: "Hãy thử dùng Gemini và bạn sẽ thấy ấn tượng."