2024 年 11 月 7 日

Gemini モデルの長いコンテキストで AI コーディング アシスタントを強化する

長いコンテキスト ウィンドウの応用分野で最もエキサイティングな分野の 1 つは、コードの生成と理解です。大規模なコードベースでは、複雑な関係と依存関係を深く理解する必要がありますが、従来の AI モデルではこの把握が困難です。コンテキスト ウィンドウの大きいコードの量を増やすことで、コードの生成と理解の精度と有用性を新たなレベルに引き上げることができます。

Google は、Gemini 1.5 Pro や Flash などの LLM をサポートする Cody AI コーディング アシスタントの作成者である Sourcegraph と提携し、実際のコーディング シナリオにおける長いコンテキスト ウィンドウの可能性を探りました。Sourcegraph は、コード検索とインテリジェンスを AI コード生成に統合することに重点を置いており、Palo Alto Networks や Leidos などの大規模で複雑なコードベースを持つ企業に Cody を導入することに成功しているため、この調査に最適なパートナーでした。

Sourcegraph のアプローチと結果

Sourcegraph は、100 万トークンのコンテキスト ウィンドウ(Google の Gemini 1.5 Flash を使用)を備えた Cody のパフォーマンスを、本番環境バージョンと比較しました。この直接比較により、コンテキストの拡張によるメリットを特定できました。大規模なコードベースを扱うデベロッパーにとって重要なタスクである、技術的な質問への回答に重点を置いています。このモデルは、コードの深い理解を必要とする難しい質問のデータセットを使用してトレーニングされました。

結果は驚くべきものでした。Sourcegraph の主要なベンチマークである Essential Recall、Essential Concision、Helpfulness の 3 つで、長いコンテキストを使用した場合に大幅な改善が見られました。

重要な事実の再現率: 回答に含まれる重要な事実の割合が大幅に増加しました。

Essential Concision: 回答の長さを基準として正規化した重要な事実の割合も改善され、より簡潔で関連性の高い回答が得られるようになりました。

有用性: 全体的な有用性スコアが、回答の長さで正規化された後、大幅に増加しました。これは、ユーザー フレンドリーなエクスペリエンスが向上したことを示しています。

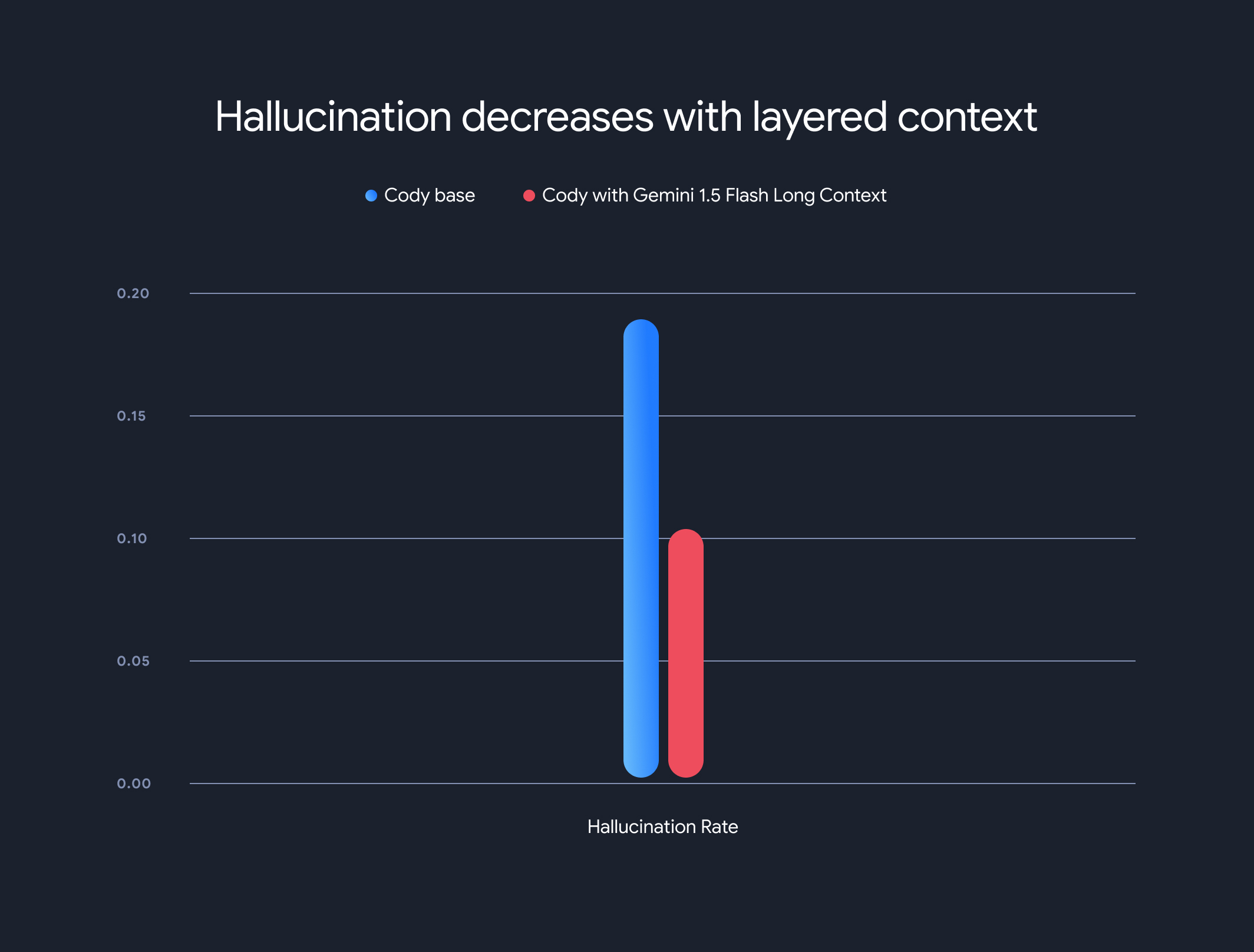

さらに、長文コンテキスト モデルを使用することで、全体的なハルシネーション率(事実と異なる情報の生成)が大幅に低下しました。ハルシネーション率が 18.97% から 10.48% に低下し、精度と信頼性が大幅に向上しました。

トレードオフと今後の方向性

長いコンテキストには大きなメリットがありますが、トレードオフもあります。最初のトークンまでの時間は、コンテキストの長さに比例して増加します。この問題を軽減するため、Sourcegraph はモデル実行状態のキャッシュ保存にプリフェッチ メカニズムとレイヤード コンテキスト モデル アーキテクチャを実装しました。Gemini 1.5 Flash と Gemini 1.5 Pro の長文コンテキスト モデルにより、1 MB のコンテキストで最初のトークンまでの時間が 30 ~ 40 秒から約 5 秒に短縮されました。これは、リアルタイムのコード生成とテクニカル アシスタンスにとって大きな改善です。

このコラボレーションは、コードの理解と生成に革命をもたらすロング コンテキスト モデルの変革の可能性を示しています。Sourcegraph のような企業と提携して、大規模なコンテキスト ウィンドウでさらに革新的なアプリケーションとパラダイムを実現できることを楽しみにしています。

Sourcegraph の詳細な評価方法、ベンチマーク、分析(例を含む)について詳しくは、詳細なブログ投稿をご覧ください。