7 nëntor 2024

Asistentët e Kodimit me IA që Mbushin me Kontekstin e Gjatë të Modeleve Gemini

Një nga kufijtë më emocionues në zbatimin e dritareve me kontekst të gjatë është gjenerimi dhe kuptimi i kodit. Bazat e mëdha të kodit kërkojnë një kuptim të thellë të marrëdhënieve dhe varësive komplekse, diçka që modelet tradicionale të inteligjencës artificiale kanë vështirësi ta kuptojnë. Duke zgjeruar sasinë e kodit me dritare të mëdha konteksti, ne mund të zhbllokojmë një nivel të ri saktësie dhe dobie në gjenerimin dhe kuptimin e kodit.

Ne u bashkuam me Sourcegraph, krijuesit e asistentit të kodimit Cody AI që mbështet LLM si Gemini 1.5 Pro dhe Flash , për të eksploruar potencialin e dritareve të gjata të kontekstit në skenarë kodimi në botën reale. Fokusi i Sourcegraph në integrimin e kërkimit dhe inteligjencës së kodit në gjenerimin e kodit AI, dhe vendosja e suksesshme e Cody në ndërmarrje me baza kodi të mëdha dhe komplekse, të tilla si Palo Alto Networks dhe Leidos, i bëri ata partnerin ideal për këtë eksplorim.

Qasja dhe Rezultatet e Sourcegraph

Sourcegraph krahasoi performancën e Cody-t me një dritare konteksti prej 1 milion tokenësh (duke përdorur Gemini 1.5 Flash të Google) me versionin e tij të prodhimit. Ky krahasim i drejtpërdrejtë i lejoi ata të izolonin përfitimet e kontekstit të zgjeruar. Ata u përqendruan në përgjigjen e pyetjeve teknike, një detyrë thelbësore për zhvilluesit që punojnë me baza të mëdha kodesh. Ata përdorën një grup të dhënash me pyetje sfiduese që kërkonin kuptim të thellë të kodit.

Rezultatet ishin mbresëlënëse. Tre nga kriteret kryesore të Sourcegraph - Kujtesa Thelbësore, Konciziteti Thelbësor dhe Ndihmshmëria - treguan përmirësime të konsiderueshme kur u përdor konteksti më i gjatë.

Kujtesë thelbësore: Përqindja e fakteve thelbësore në përgjigje u rrit ndjeshëm.

Konciziteti Thelbësor: Përqindja e fakteve thelbësore të normalizuara sipas gjatësisë së përgjigjes gjithashtu u përmirësua, duke treguar përgjigje më koncize dhe relevante.

Ndihmshmëria: Rezultati i përgjithshëm i ndihmës, i normalizuar sipas gjatësisë së përgjigjes, u rrit ndjeshëm, duke treguar një përvojë më miqësore për përdoruesit.

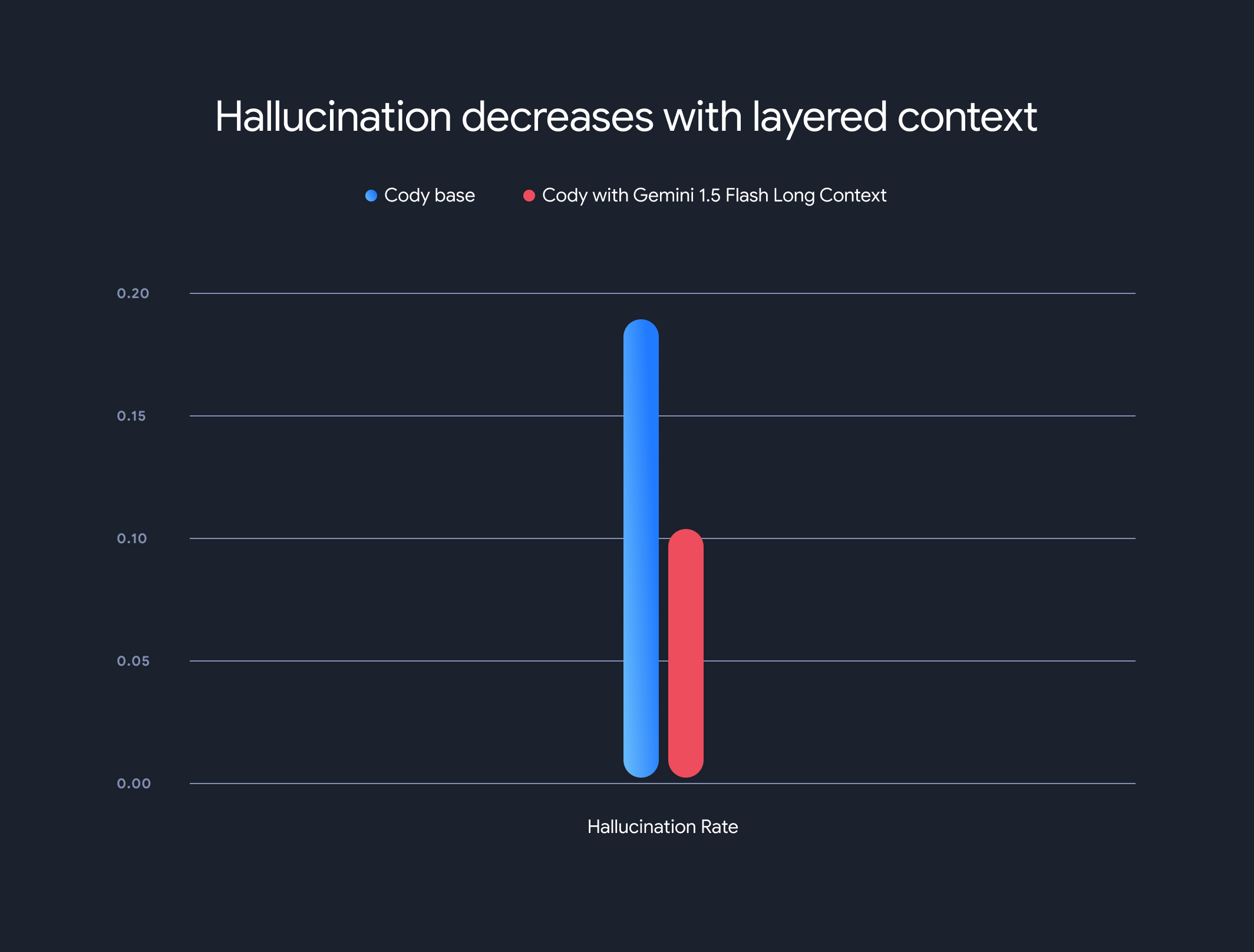

Për më tepër, përdorimi i modeleve me kontekst të gjatë uli në mënyrë drastike shkallën e përgjithshme të halucinacioneve (gjenerimin e informacionit faktikisht të pasaktë). Shkalla e halucinacioneve ra nga 18.97% në 10.48%, një përmirësim i ndjeshëm në saktësi dhe besueshmëri.

Kompromiset dhe Drejtimi i së Ardhmes

Ndërsa përfitimet e kontekstit të gjatë janë të rëndësishme, ka edhe disavantazhe. Koha për të krijuar tokenin e parë rritet në mënyrë lineare me gjatësinë e kontekstit. Për ta zbutur këtë, Sourcegraph zbatoi një mekanizëm paraprak të marrjes dhe një arkitekturë modeli konteksti me shtresa për ruajtjen në memorje të gjendjes së ekzekutimit të modelit. Me modelet e kontekstit të gjatë Gemini 1.5 Flash dhe Pro, kjo optimizoi kohën për të krijuar tokenin e parë nga 30-40 sekonda në rreth 5 sekonda për kontekstet 1MB - një përmirësim i konsiderueshëm për gjenerimin e kodit në kohë reale dhe asistencën teknike.

Ky bashkëpunim shfaq potencialin transformues të modeleve me kontekst të gjatë në revolucionarizimin e të kuptuarit dhe gjenerimit të kodit. Jemi të emocionuar që do të bashkëpunojmë me kompani si Sourcegraph për të vazhduar të zhbllokojmë aplikacione dhe paradigma edhe më inovative me dritare të mëdha konteksti.

Për t'u zhytur më thellë në metodologjitë e detajuara të vlerësimit, standardet dhe analizat e Sourcegraph, duke përfshirë shembuj ilustrues, mos e humbisni postimin e tyre të hollësishëm në blog .

Dhomat

Zhbllokimi i ndërveprimeve më të pasura të avatarëve me aftësitë tekstuale dhe audio të Gemini 2.0