Gemini モデル ファミリーの最小バージョンである Gemini Nano は、Google Pixel 8 Pro と Samsung S24 シリーズ以降の対応 Android デバイスでデバイス上で実行できます。

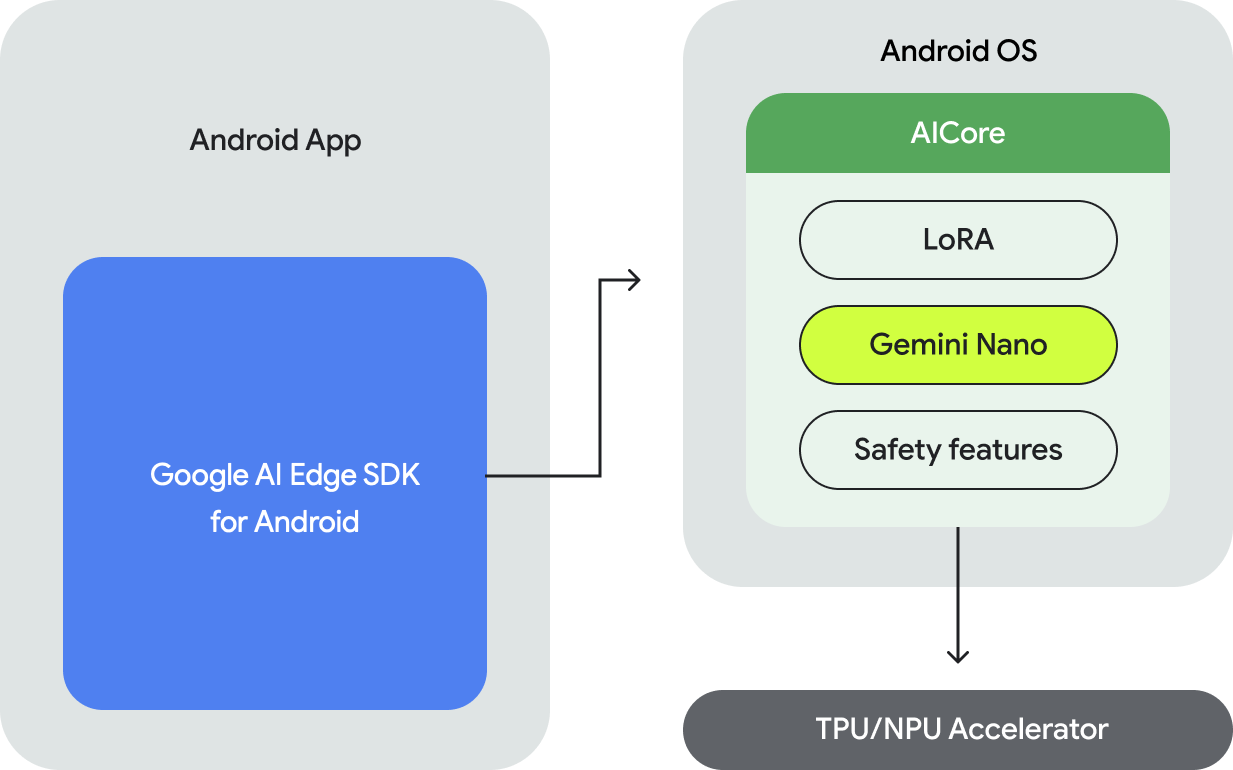

Android で Gemini Nano モデルを実行するには、次の処理を行う API を提供する Google AI Edge SDK for Android を使用する必要があります。

- 基盤となる Android 搭載デバイスがサポートされているかどうかを判断します。

- Gemini Nano モデルにアクセスします。

- 安全性設定を調整する。

- 推論を高パフォーマンスで実行し、フォールバックを実装します。

- 必要に応じて、LoRA ファインチューニング ブロックを指定して、ユースケースのモデルのパフォーマンスを改善します。

Gemini Nano にアクセスするための API はテキストからテキストへのモダリティをサポートしており、今後さらに多くのモダリティが提供される予定です。

オンデバイス実行のメリット

オンデバイス実行により、次のことが可能になります。

- 機密データのローカル処理: データをローカルで処理すると、ユーザーデータのクラウドへの送信を回避できます。これは、エンドツーエンドの暗号化を使用するメッセージ アプリなど、センシティブ データを処理するアプリにとって重要です。

- オフライン アクセス: インターネットに接続されていなくても AI 機能にアクセスできます。これは、オフラインや接続が不安定な状態で動作する必要があるアプリケーションに役立ちます。

- コスト削減: 実行をコンシューマ ハードウェアにオフロードすることで、推論コストを削減できます。これにより、頻繁に使用されるユーザーフローを大幅に節約できます。

Gemini のデバイス上での実行には多くの利点があります。ただし、より大きな Gemini モデルを必要とするユースケースで、幅広いデバイスをサポートするには、Gemini API を使用してサーバー上の Gemini にアクセスすることをおすすめします。これは、バックエンドの統合(Python、Go、Node.js、または REST)によって行うことも、新しい Google AI Client SDK for Android を介して Android アプリから直接行うこともできます。

仕組み

Gemini Nano のデバイス上での実行は Android AICore を利用しています。これは、Android 14 で導入された、デバイス上で実行するための基盤モデルへのアクセスを提供する新しいシステムレベルの機能です。基盤モデルは AICore を使用してプリインストールされているため、アプリ内でダウンロードしたり配布したりする必要はありません。LoRa を使用して、ダウンストリームのタスク用にこれらのモデルを微調整できます。Android AICore は現在、Google Pixel 8 Pro デバイスと Samsung S24 シリーズ デバイスで製品版として利用可能で、すでに Google アプリの革新的な機能を実現しています。

詳しくは、Android AICore をご覧ください。

次のステップ

アプリで Gemini Nano をデバイス上で使用するには、Google AI Edge SDK for Android の早期アクセス プレビューにお申し込みください。

Android アプリで Google のサーバーで Gemini Pro 推論を利用する方法については、Android 用 Google AI クライアント SDK のクイックスタートをご覧ください。