从 Google Pixel 8 Pro 和 Samsung S24 系列开始,Gemini Nano 是 Gemini 型号系列的最小版本,可在支持 Android 设备的 Android 设备上执行。

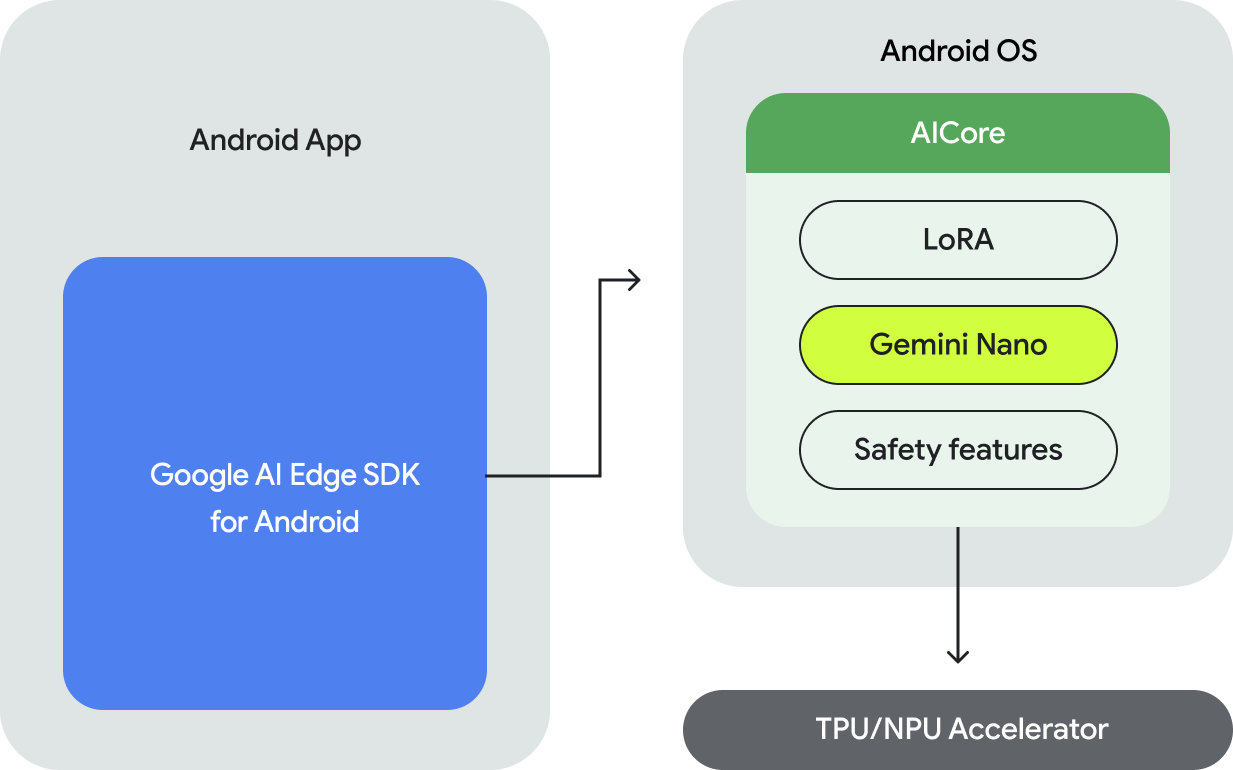

如需在 Android 上执行 Gemini Nano 模型,您需要使用 Android 版 Google AI Edge SDK,该 SDK 提供了用于执行以下操作的 API:

- 确定是否支持底层 Android 设备。

- 获取 Gemini Nano 模型的访问权限。

- 调整安全设置。

- 以高性能运行推断并实现回退。

- (可选)提供 LoRA 微调块,以针对您的使用场景提升模型的性能。

用于访问 Gemini Nano 的 API 支持文本到文本模态,未来还将支持更多模态。

设备端执行的优势

设备端执行可启用以下功能:

- 在本地处理敏感数据:在本地处理数据有助于避免将用户数据发送到云端。这对于处理敏感数据的应用(例如采用端到端加密的即时通讯应用)来说非常重要。

- 离线访问:即使没有互联网连接,用户也可以使用 AI 功能。这对于需要离线工作或使用可变连接的应用非常有用。

- 费用节省:您可以将执行任务分流到消费类硬件上,从而降低推断费用。这可以为经常使用的用户流节省大量费用。

在设备端执行 Gemini 有许多好处;但是,对于需要更大的 Gemini 模型以及支持各种设备的用例,您可能需要考虑使用 Gemini API 在服务器上访问 Gemini。您可以通过后端集成(使用 Python、Go、Node.js 或 REST),或通过新的适用于 Android 的 Google AI 客户端 SDK 直接从 Android 应用中完成此操作。

运作方式

Gemini Nano 的设备端执行由 Android AICore 提供支持,Android AICore 是 Android 14 中引入的一项新的系统级功能,可让您访问设备端执行的基础模型。基础模型是使用 AICore 预安装的,因此您无需在应用中下载或分发基础模型。您可以使用 LoRa 针对下游任务微调这些模型。Android AICore 现已在 Google Pixel 8 Pro 和三星 S24 系列设备上正式发布,并且已经在支持 Google 应用的创新功能。

如需了解详情,请参阅 Android AICore。

后续步骤

如要开始在设备端使用 Gemini Nano 应用,请申请抢先体验 Android 版 Google AI Edge SDK。

如需了解如何在 Android 应用中利用 Google 服务器上的 Gemini Pro 推断功能,请阅读 Android 版 Google AI 客户端 SDK 快速入门。