Dodanie generatywnej AI do aplikacji może znacznie zwiększyć możliwości użytkowników, ale wymaga także starannej dbania o bezpieczeństwo i prywatność, których oczekują użytkownicy.

Projektowanie z myślą o bezpieczeństwie

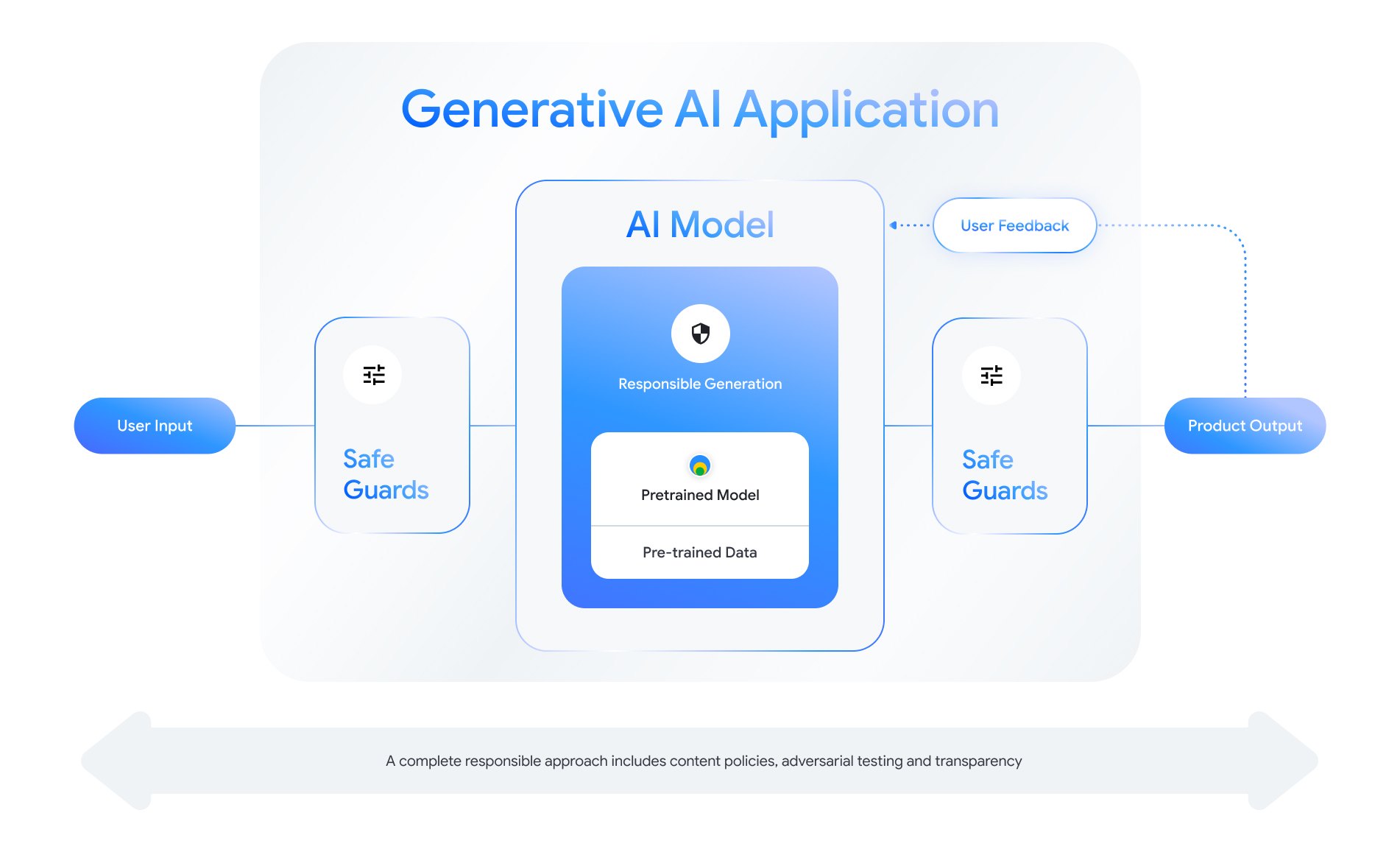

Każda funkcja obsługująca generatywną AI stwarza możliwość projektowania warstw zabezpieczeń. Jako na poniższej ilustracji. Jednym ze sposobów podejścia do bezpieczeństwa jest umieszczenie Model AI, który włącza tę funkcję pośrodku. Powinien to być ten model:

- Dopasowane, aby wykonać przypisane zadanie;

- Chronione środkami ochrony, aby zapewnić, że poza granicami dane wejściowe i wyjściowe są odrzucane; oraz

- oceny całościowo, co pozwala ocenić, jak model reakcji systemu na interakcje wpływające na bezpieczeństwo.

Zobacz „Tworzenie usług odpowiedzialnej AI” sesja od Podczas konferencji Google I/O 2024 można dowiedzieć się więcej o kwestii projektowania, i metod prototypowania, które mogą przyspieszyć odpowiedzialny rozwój praktyk biznesowych.

Możesz także zapoznać się ze sprawdzonymi metodami oraz zobaczyć przykłady dotyczące:

- Definiowanie zasad, które będą określać zasady działania AI aplikacji;

- tworzenie artefaktów przejrzystości do komunikacji; odpowiedzialnego podejścia do użytkowników; oraz

- Ochrona aplikacji przed złośliwym oprogramowaniem.

Pamiętaj, że rozsądne podejście do bezpieczeństwa i odpowiedzialności autorefleksyjny i adaptacyjny do kwestii technicznych, kulturowych i procesowych. . Zaangażuj siebie i swój zespół w regularne sprawdzanie w celu uzyskania najlepszych wyników.

Zdefiniuj zasady na poziomie systemu

Zasady bezpieczeństwa treści określają, jakie rodzaje szkodliwych treści są niedozwolone na platformie online. Być może znasz już politykę treści na różnych platformach np. YouTube lub Google Play. Content (sieć partnerska), zastosowania generatywnej AI są podobne: definiują rodzaj treści, których aplikacja nie powinna generować, i podpowiadają, jak dostroić modele oraz odpowiednie środki ochrony, które warto dodać.

Zasady powinny odzwierciedlać przypadek użycia aplikacji. Na przykład plik usługa generatywnej AI, która zapewnia pomysły na aktywności dla rodzin oparte na propozycje członków społeczności mogą podlegać polityce zakazującej generowania treści przedstawiające przemoc, które mogą być szkodliwe dla użytkowników; I odwrotnie: aplikacja z podsumowaniem pomysłów na fabułę science fiction zaproponowana przez użytkowników może pozwalają na generowanie przemocy, ponieważ krąży to wiele historii tego gatunku.

Twoje zasady bezpieczeństwa powinny uniemożliwiać generowanie szkodliwych treści użytkownikom lub nielegalnych. Powinni też określić, jakie typy generowanych treści spełniają ten pasek aplikacji. Możesz też dodać wyjątki dotyczą treści edukacyjnych, dokumentalnych, naukowych lub artystycznych, w innych przypadkach mogłyby zostać uznane za szkodliwe.

Sformułowanie jasnych zasad na bardzo szczegółowym poziomie, w tym: wyjątków od zasad, podając przykłady, ma fundamentalne znaczenie dla budowania odpowiedzialnego usługi. Twoje zasady są używane na każdym etapie tworzenia modelu. Dane czyszczenie lub oznakowanie, niedokładność może prowadzić do błędnego oznaczenia danych, nadmiernego usunięcia zbyt mało danych, co wpłynie na reakcje bezpieczeństwa modelu. Dla: niewłaściwie określone zasady będą prowadzić do wysokiej przez co trudniej jest określić, czy model spełnia wymagania do standardów statystycznych.

Hipotetyczne zasady (tylko do celów ilustracyjnych)

Oto kilka przykładów zasad, które warto rozważyć w odniesieniu do o ile pasują do danego przypadku użycia.

| Kategoria zasad | Zasady |

|---|---|

| Poufne informacje umożliwiające identyfikację osoby | W zgłoszeniu nie będą podawane informacje poufne ani umożliwiające identyfikację informacji (np. adresu e-mail, numeru karty kredytowej lub numeru PESEL osoby prywatnej). |

| Szerzenie nienawiści | Aplikacja nie będzie generować negatywnych ani szkodliwych treści kierowanie na tożsamość i cechy chronione (np. obelgi rasowe, promujące dyskryminację, nawoływanie do przemocy wobec osób chronionych ). |

| Nękanie | Aplikacja nie może generować złośliwego oprogramowania, zastraszania, dokuczania czy lub treści krzywdzące dotyczące innej osoby (np. groźby, zaprzeczanie tragicznym wydarzeniom, ubliżanie ofiarom przemoc). |

| Treści niebezpieczne | Aplikacja nie wygeneruje instrukcji ani porad dotyczących wyrządzenia szkody (np. uzyskiwanie dostępu do broni palnej lub budowanie jej urządzenia wybuchowe, promowanie terroryzmu, instrukcje samobójstwo). |

| Treści erotyczne | Aplikacja nie wygeneruje treści zawierających odwołania do akty seksualne lub inne lubieżne treści (np. obrazowe o charakterze erotycznym); opisów, treści mających na celu wywołanie pobudzenia). |

| Ułatwianie dostępu do szkodliwych towarów i usług | Aplikacja nie będzie generowała treści, które promują lub umożliwiają dostęp do potencjalnie szkodliwych towarów, usług i działań (np. ułatwiania dostępu do promowania hazardu, leków, fajerwerki, usługi seksualne). |

| Szkodliwe treści | Aplikacja nie wygeneruje instrukcji dotyczących wykonywania lub działań wprowadzających w błąd (np. służących do wyłudzania informacji, wysyłania spamu lub treści przeznaczonych do masowego nagabywania czy stosowania metod jailbreaku). |

Artefakty przejrzystości

Dokumentacja to kluczowy element zwiększania przejrzystości dla deweloperów, rządom, podmiotom odpowiedzialnym za zasady i użytkownikom produktu. Może to obejmować szczegółowe raporty techniczne lub model, dane i karty systemowe, odpowiednio udostępniać publiczne informacje na podstawie bezpieczeństwa i innych modeli. ocen. Artefakty związane z przejrzystością to coś więcej niż środki komunikacji. oni oraz wskazówki dla badaczy AI, wdrażających i deweloperów w zakresie odpowiedzialnego korzystania z modelu. Te informacje są przydatne dla użytkowników aby dowiedzieć się więcej o danym modelu.

Kilka wskazówek dotyczących przejrzystości, które warto wziąć pod uwagę:

- Wyraźnie informuj użytkowników, kiedy biorą udział w eksperymencie technologii generatywnej AI i podkreślają możliwość wystąpienia nieoczekiwanego modelu zachowanie użytkownika.

- Przedstawienie szczegółowej dokumentacji dotyczącej sposobu działania usługi lub produktu generatywnej AI używając zrozumiałego języka. Warto opublikować ustrukturyzowaną strukturę artefakty związane z przejrzystością, takie jak karty modelu. Karty te zawierają zamierzonego wykorzystania modelu oraz podsumuj oceny wykonywane w trakcie opracowywania modelu.

- Pokaż ludziom, jak mogą przekazywać opinie i w jaki sposób sprawują nad nimi kontrolę.

jako:

- Udostępniamy mechanizmy, które pomagają użytkownikom weryfikować pytania oparte na faktach

- Ikony kciuka w górę i w dół do przekazywania opinii użytkowników

- Linki do zgłaszania problemów i oferowania szybkiej pomocy opinie użytkowników

- Kontrola użytkowników dotycząca przechowywania i usuwania aktywności użytkownika

Bezpieczne systemy AI

Aplikacje obsługujące generatywną AI stanowią złożone powierzchnie ataku które wymagają bardziej zróżnicowanych środków łagodzących niż konwencjonalne zastosowania. Opracowana przez Google platforma Secure AI Framework (SAIF) zapewnia całościowy platforma koncepcyjna, która pozwala zaprojektować aplikację z wykorzystaniem generatywnej AI do bezpiecznych zastosowań. Ten schemat pomoże Ci zdecydować, w jaki sposób dopasowanie, ocena kontrowersyjna oraz skuteczne zabezpieczenia – ale pamiętaj, że to dopiero początek. Dodatkowe zmiany w: praktyk organizacji, monitorowania i tworzenia alertów aby osiągnąć cele w zakresie bezpieczeństwa w konkretnym przypadku użycia i kontekście.

Materiały dla programistów

Przykłady zasad dotyczących generatywnej AI:

- Cloud Gemini API i PaLM API zapewniają lista atrybutów bezpieczeństwa, które mogą służyć za podstawę do tworzenia .

- Przykłady zasad uwzględnionych w Aktualizacja zasad Google dotyczących AI na 2023 rok.

- MLCommons Association, konsorcjum inżynierskie oparte na filozofia otwartej współpracy na rzecz ulepszania systemów AI, odniesienia 6 zagrożeń, w których oceniają modele bezpieczeństwa AI, w ramach Test porównawczy bezpieczeństwa AI

Nie ma jednego szablonu dla artefaktów związanych z przejrzystością ale istniejące karty modelowe mogą służyć jako punkt wyjścia aby utworzyć własny:

- Karta modelu Gemmy

- Szablon karty modelu z oryginalnego papieru do modelowania

- Karty modeli z interfejsów Google Cloud APIs

Dodatkowe odnośniki

- Karty modeli na potrzeby raportowania modeli

- Karty modeli

- Karty danych: celowa i przejrzysta dokumentacja zbioru danych w zakresie odpowiedzialnej AI

- Poradnik dotyczący kart danych

- Bard ze specjalnie dostrojoną kartą systemową Gemini Pro

- Materiały z forum Frontier Modeling dotyczące współpracy Red Team