9 KWIETNIA 2025 R.

Wydajni i tani agenci AI z Gemini Flash na platformie Langbase

Tworzenie agentów AI, którzy potrafią samodzielnie zarządzać swoimi działaniami i narzędziami zewnętrznymi, zwykle wiąże się z koniecznością pokonania przeszkód związanych z integracją i infrastrukturą. Langbase eliminuje konieczność zarządzania tymi złożonymi procesami, udostępniając platformę do tworzenia i wdrażania bezserwerowych agentów AI opartych na modelach takich jak Gemini, a wszystko to bez konieczności korzystania z frameworka.

Od czasu wprowadzenia Gemini Flash użytkownicy Langbase szybko dostrzegli zalety tych lekkich modeli pod względem wydajności i kosztów w przypadku funkcji opartych na agentach.

Skalowalność i szybsze działanie agentów AI dzięki Gemini Flash

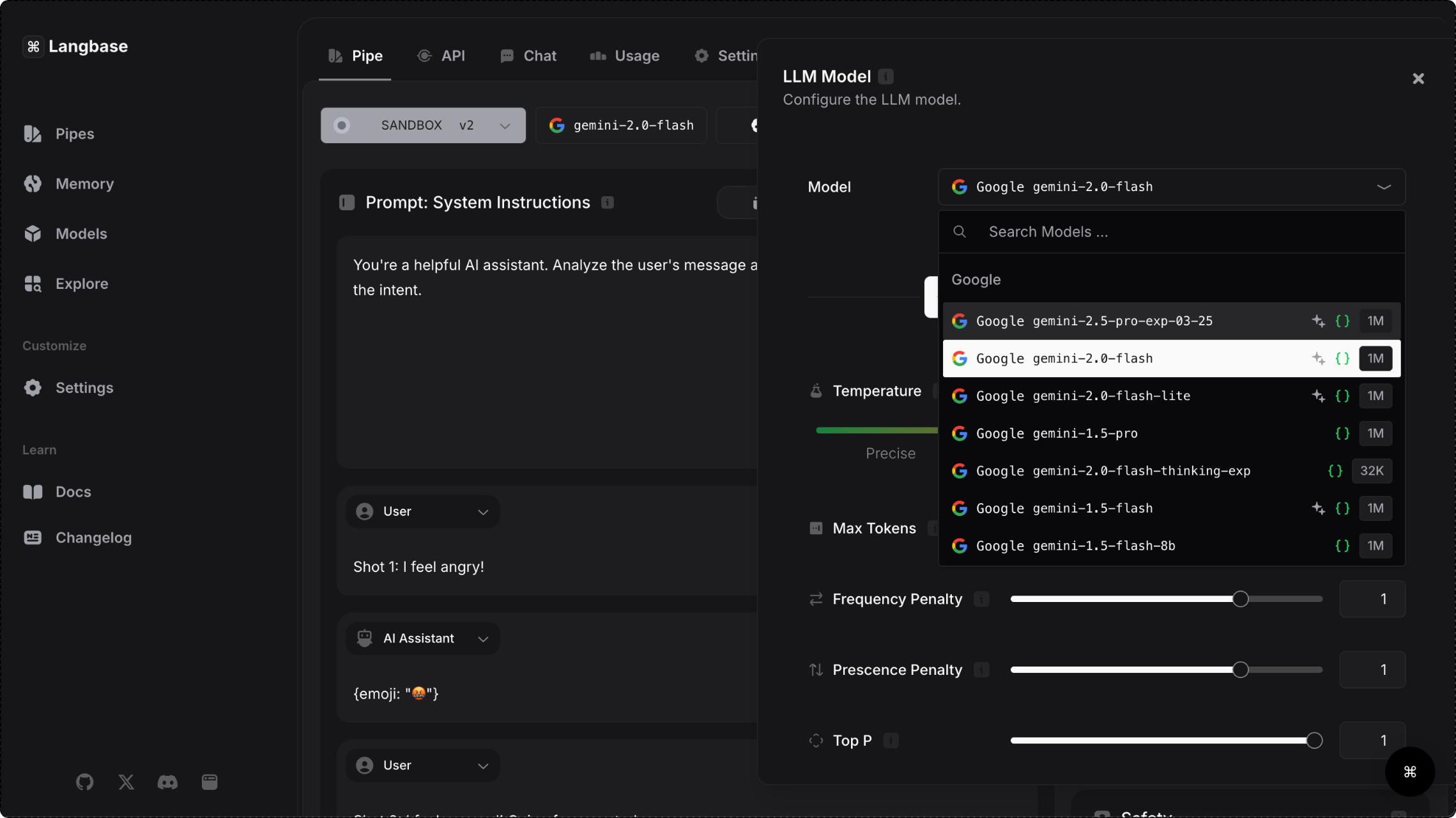

Platforma Langbase zapewnia dostęp do modeli Gemini za pomocą Gemini API, dzięki czemu użytkownicy mogą wybierać szybkie modele, które radzą sobie ze złożonymi zadaniami i przetwarzają ogromne ilości danych. Niskie opóźnienia są kluczowe dla zapewnienia płynnego działania w czasie rzeczywistym, dlatego modele z rodziny Gemini Flash szczególnie dobrze nadają się do tworzenia agentów dostępnych dla użytkowników.

Oprócz 28% szybszych czasów odpowiedzi użytkownicy platformy odnotowali 50% redukcję kosztów i 78% wzrost przepustowości w swoich operacjach podczas korzystania z Gemini 1.5 Flash. Możliwość obsługi dużej liczby żądań bez obniżania wydajności sprawia, że modele Gemini Flash są oczywistym wyborem w przypadku aplikacji o dużym zapotrzebowaniu, takich jak tworzenie treści w mediach społecznościowych, podsumowywanie artykułów naukowych i aktywna analiza dokumentów medycznych.

31,1 tokena/s

78% wyższa przepustowość w przypadku modelu Flash w porównaniu z podobnymi modelami

7,8x

większe okno kontekstu w przypadku modelu Flash w porównaniu z podobnymi modelami;

28%

Krótszy czas odpowiedzi w porównaniu z podobnymi modelami

50%

Niższe koszty w przypadku Flash w porównaniu z podobnymi modelami

- Źródło: blog Langbase

Jak Langbase upraszcza tworzenie agentów

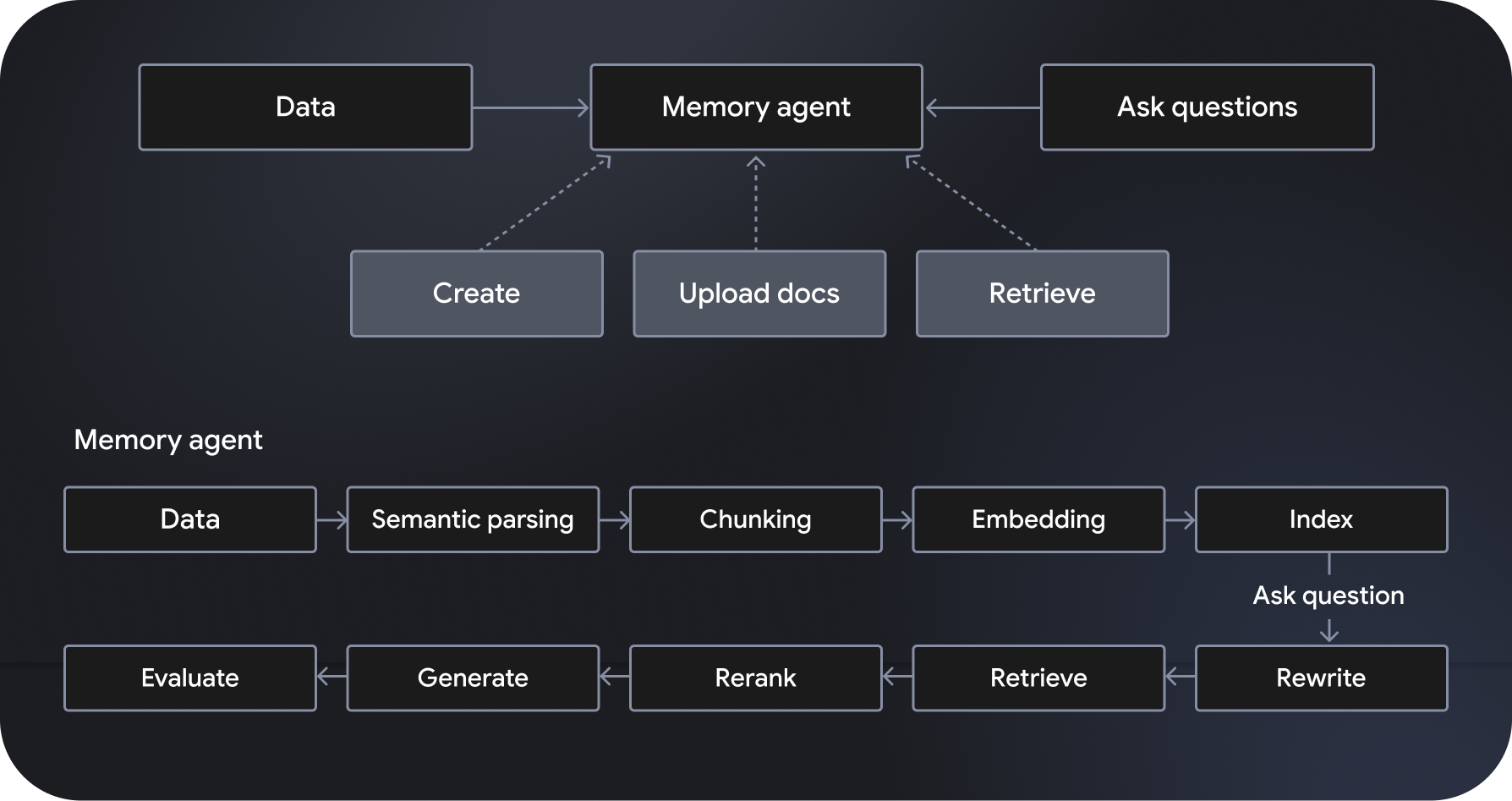

Langbase to bezserwerowa platforma do tworzenia i wdrażania agentów AI, która umożliwia tworzenie bezserwerowych agentów AI. Oferuje w pełni zarządzane, skalowalne systemy generowania odpowiedzi na podstawie wyszukiwania semantycznego (RAG), zwane „agentami pamięci”. Dodatkowe funkcje obejmują orkiestrację przepływu pracy, zarządzanie danymi, obsługę interakcji z użytkownikami i integrację z usługami zewnętrznymi.

„Agenci potokowi”, którzy korzystają z modeli takich jak Gemini 2.0 Flash, postępują zgodnie z określonymi instrukcjami i wykonują je. Mają też dostęp do zaawansowanych narzędzi, w tym do wyszukiwania i indeksowania w internecie. Z drugiej strony agenci pamięci dynamicznie uzyskują dostęp do odpowiednich danych, aby generować odpowiedzi oparte na faktach. Interfejsy API Pipe i Memory od Langbase umożliwiają programistom tworzenie zaawansowanych funkcji poprzez łączenie zaawansowanego wnioskowania z nowymi źródłami danych, co zwiększa wiedzę i użyteczność modeli AI.

Automatyzując skomplikowane procesy, zwiększając wydajność przepływu pracy i zapewniając użytkownikom wysoce spersonalizowane doświadczenia, agenci AI otwierają możliwości tworzenia bardziej zaawansowanych aplikacji. Połączenie zaawansowanego rozumowania, niskich kosztów i większej szybkości sprawia, że modele Gemini Flash są preferowanym wyborem użytkowników Langbase. Poznaj platformę, aby zacząć tworzyć i wdrażać wysoce wydajne i skalowalne agenty AI.