প্রান্তিক প্ল্যাটফর্মগুলিতে উচ্চ-কার্যক্ষমতাসম্পন্ন ML এবং GenAI স্থাপনা

ডিভাইসে মেশিন লার্নিংয়ের জন্য দক্ষ রূপান্তর, রানটাইম এবং অপ্টিমাইজেশন।

TensorFlow Lite-এর যুদ্ধ-পরীক্ষিত ভিত্তির উপর নির্মিত

LiterRT কেবল নতুন নয়; এটি বিশ্বের সবচেয়ে ব্যাপকভাবে ব্যবহৃত মেশিন লার্নিং রানটাইমের পরবর্তী প্রজন্ম। এটি আপনার প্রতিদিন ব্যবহৃত অ্যাপগুলিকে শক্তিশালী করে, কোটি কোটি ডিভাইসে কম ল্যাটেন্সি এবং উচ্চ গোপনীয়তা প্রদান করে।

সবচেয়ে গুরুত্বপূর্ণ Google অ্যাপগুলির দ্বারা বিশ্বস্ত

১ লক্ষেরও বেশি অ্যাপ্লিকেশন, বিশ্বব্যাপী কোটি কোটি ব্যবহারকারী

LiterRT হাইলাইটস

ক্রস প্ল্যাটফর্ম প্রস্তুত

জেনএআই প্রকাশ করুন

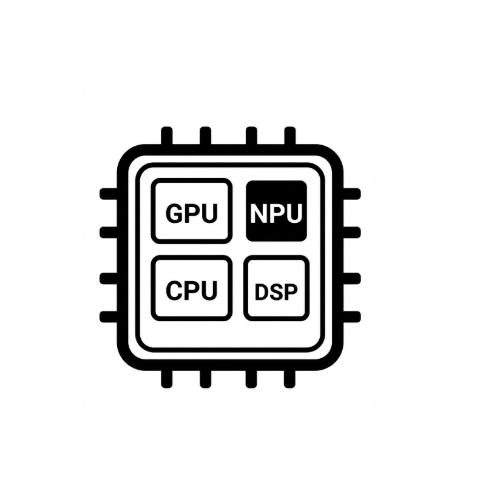

সরলীকৃত হার্ডওয়্যার ত্বরণ

মাল্টি-ফ্রেমওয়ার্ক সাপোর্ট

LiterRT এর মাধ্যমে স্থাপন করুন

একটি মডেল পান

.tflite-এর পূর্ব-প্রশিক্ষিত মডেল ব্যবহার করুন অথবা PyTorch, JAX অথবা TensorFlow মডেলগুলিকে .tflite-এ রূপান্তর করুন।

মডেলটি অপ্টিমাইজ করুন

ঐচ্ছিকভাবে মডেলের পরিমাণ নির্ধারণ করুন

চালান

পছন্দসই অ্যাক্সিলারেটরটি বেছে নিন এবং LiterRT তে চালান।

নমুনা, মডেল এবং ডেমো

নমুনা অ্যাপ দেখুন

টিউটোরিয়ালগুলি আপনাকে সম্পূর্ণ, এন্ড-টু-এন্ড উদাহরণ সহ LiterRT কীভাবে ব্যবহার করতে হয় তা দেখায়।

genAI মডেলগুলি দেখুন

পূর্ব-প্রশিক্ষিত, অত্যাধুনিক জেনারেশন এআই মডেল।

ডেমো দেখুন - গুগল এআই এজ গ্যালারি অ্যাপ

একটি গ্যালারি যা ডিভাইসে থাকা ML/GenAI ব্যবহারের কেসগুলি প্রদর্শন করে