एज प्लैटफ़ॉर्म पर बेहतर परफ़ॉर्मेंस देने वाले एमएल और जेन एआई को डिप्लॉय करना

ऑन-डिवाइस मशीन लर्निंग के लिए, कन्वर्ज़न, रनटाइम, और ऑप्टिमाइज़ेशन को बेहतर तरीके से मैनेज करना.

इसे TensorFlow Lite के भरोसेमंद फ़्रेमवर्क पर बनाया गया है

LiteRT सिर्फ़ नया नहीं है, बल्कि यह दुनिया में सबसे ज़्यादा इस्तेमाल किए जाने वाले मशीन लर्निंग रनटाइम की अगली जनरेशन है. यह आपके रोज़ाना इस्तेमाल किए जाने वाले ऐप्लिकेशन को बेहतर बनाता है. साथ ही, अरबों डिवाइसों पर कम समय में डेटा ट्रांसफ़र करने और ज़्यादा निजता देने में मदद करता है.

Google के सबसे ज़रूरी ऐप्लिकेशन के लिए भरोसेमंद

एक लाख से ज़्यादा ऐप्लिकेशन, दुनिया भर के अरबों उपयोगकर्ता

LiteRT की खास बातें

क्रॉस प्लैटफ़ॉर्म के लिए तैयार है

GenAI की मदद से बेहतर तरीके से काम करना

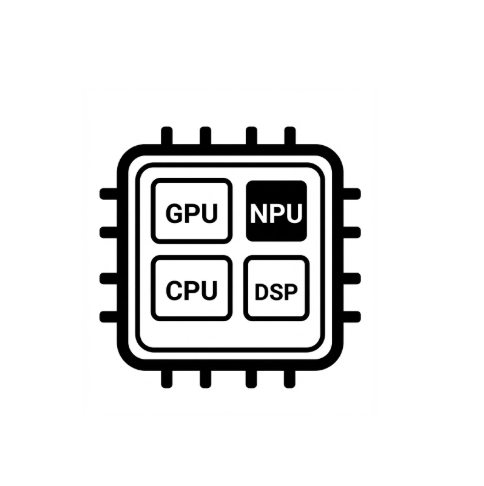

हार्डवेयर से तेज़ी लाने की सुविधा को आसान बनाना

एक से ज़्यादा फ़्रेमवर्क इस्तेमाल करने की सुविधा

LiteRT के ज़रिए लागू करना

मॉडल पाना

पहले से ट्रेन किए गए .tflite मॉडल का इस्तेमाल करें या PyTorch, JAX या TensorFlow मॉडल को .tflite में बदलें

मॉडल को ऑप्टिमाइज़ करना

मॉडल को वैकल्पिक रूप से क्वॉन्टाइज़ करना

चलाएं

अपनी पसंद का ऐक्सेलरेटर चुनें और उसे LiteRT पर चलाएं

सैंपल, मॉडल, और डेमो

सैंपल ऐप्लिकेशन देखें

ट्यूटोरियल में, LiteRT को इस्तेमाल करने का तरीका बताया गया है. साथ ही, इसमें शुरू से लेकर आखिर तक के उदाहरण भी दिए गए हैं.

जेन एआई मॉडल देखना

पहले से ट्रेन किए गए, इस्तेमाल के लिए तैयार जेन एआई मॉडल.

डेमो देखें - Google AI Edge Gallery ऐप्लिकेशन

एक गैलरी, जिसमें डिवाइस पर मौजूद एमएल/जेन एआई के इस्तेमाल के उदाहरण दिखाए गए हैं