Uç platformlarda yüksek performanslı makine öğrenimi ve üretken yapay zeka dağıtımı

Cihaz üzerinde makine öğrenimi için verimli dönüşüm, çalışma zamanı ve optimizasyon.

TensorFlow Lite'ın savaşta test edilmiş temeli üzerine kurulmuştur.

LiteRT sadece yeni bir ürün değil, aynı zamanda dünyanın en yaygın kullanılan makine öğrenimi çalışma zamanının yeni nesli. Her gün kullandığınız uygulamalara güç vererek milyarlarca cihazda düşük gecikme süresi ve yüksek gizlilik sağlar.

En önemli Google uygulamaları tarafından güvenle kullanılır

100.000'den fazla uygulama, dünya genelinde milyarlarca kullanıcı

LiteRT'de öne çıkanlar

Platformlar arası kullanıma hazır

Üretken yapay zekanın gücünden yararlanma

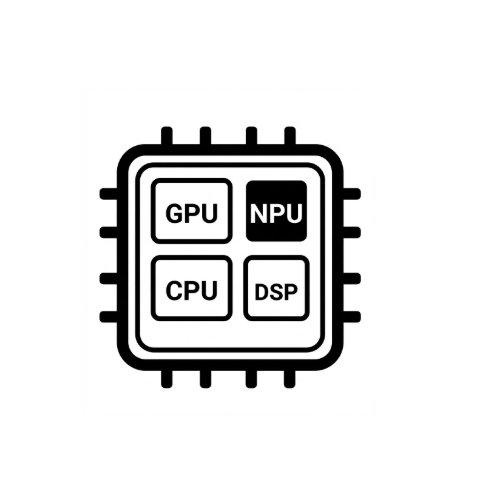

Basitleştirilmiş donanım hızlandırma

Çoklu çerçeve desteği

LiteRT aracılığıyla dağıtma

Model edinme

.tflite önceden eğitilmiş modellerini kullanın veya PyTorch, JAX ya da TensorFlow modellerini .tflite'a dönüştürün

Modeli optimize etme

İsteğe bağlı olarak modeli nicelendirin.

Çalıştır

İstediğiniz hızlandırıcıyı seçin ve LiteRT'de çalıştırın.

Örnekler, modeller ve demo

Örnek uygulamayı göster

Eğitimlerde, LiteRT'nin nasıl kullanılacağı uçtan uca örneklerle gösterilir.

Üretken yapay zeka modellerini inceleyin

Önceden eğitilmiş, kullanıma hazır üretken yapay zeka modelleri.

Demoları inceleyin - Google AI Edge Gallery uygulaması

Cihazda makine öğrenimi/üretken yapay zeka kullanım alanlarını sergileyen bir galeri