يمكن أن تؤدي إضافة الذكاء الاصطناعي التوليدي إلى تطبيقك إلى الاستفادة من إمكانات وقيمة هائلة المستخدمين، ولكنها تتطلب أيضًا عينًا حريصة للحفاظ على السلامة والخصوصية يتوقع المستخدمون.

مراعاة السلامة عند التصميم

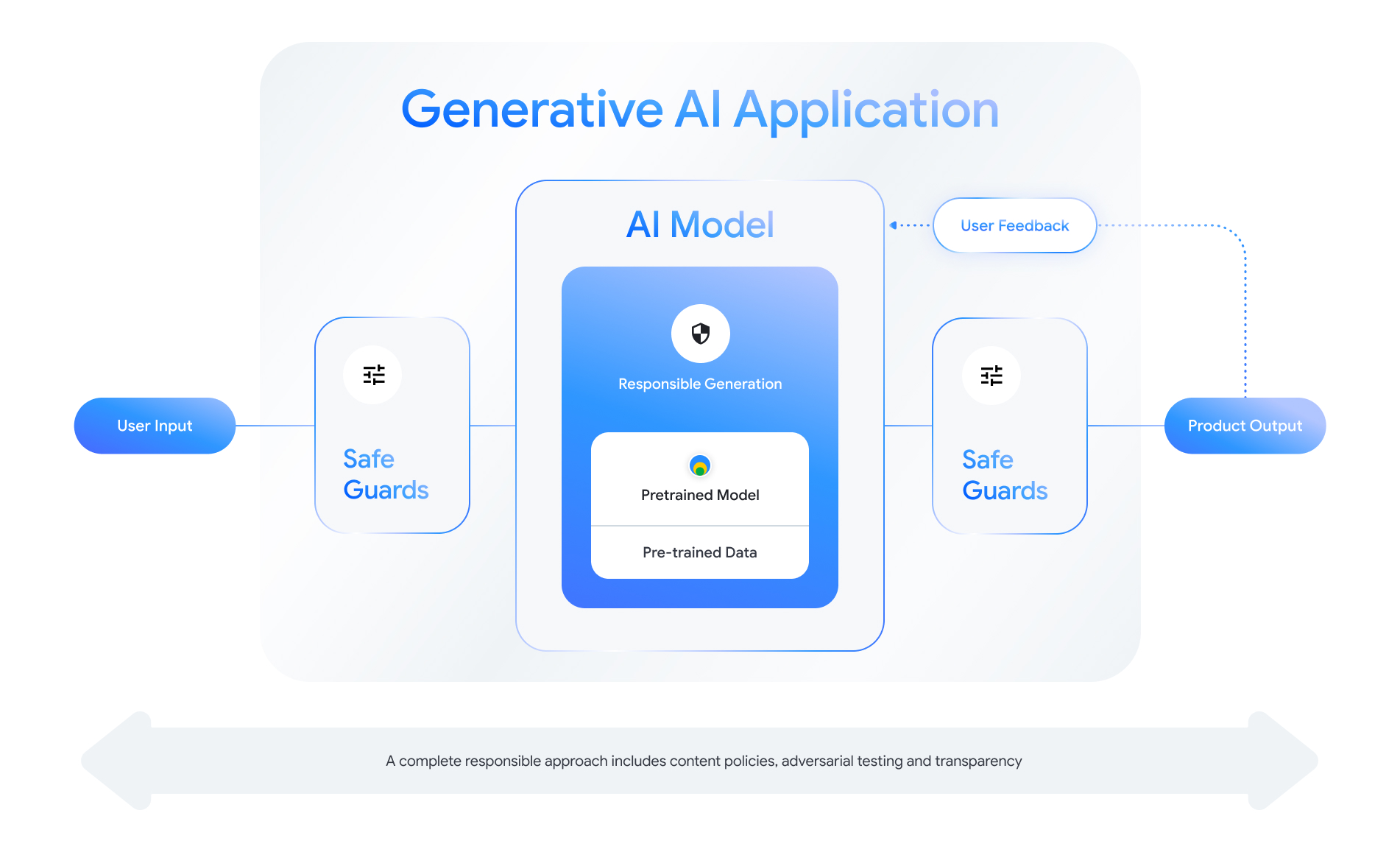

تقدّم كل ميزة تتيح الذكاء الاصطناعي التوليدي فرصًا لتصميم طبقات من الأمان. بالنسبة كما هو موضح في الشكل التالي، تتمثل إحدى الطرق التي يمكنك من خلالها التفكير في الأمان في وضع تمثّل هذه السمة نموذج الذكاء الاصطناعي الذي يتيح هذه الميزة في الوسط. يجب أن يكون هذا النموذج:

- تمت محاذاته لتنفيذ المهمة الموكلة إليه

- حماية من خلال تدابير الوقاية للتأكد من أنّ الحدود خارج الحدود يتم رفض المدخلات والمخرجات؛ أو

- يتم تقييمه بشكل شامل لتقييم كيفية استجابة النموذج استجابة النظام للتفاعلات المؤثرة على السلامة.

ننصحك بالاطّلاع على "إنشاء منتجات مسؤولة تستند إلى الذكاء الاصطناعي" جلسة من سنتعرّف أكثر في مؤتمر Google I/O لعام 2024 على الاعتبارات المتعلقة بالتصميم وتمارين التفكير وإنشاء نماذج أولية لها يمكنها المساعدة في تسريع التطوير المسؤول التقليدية.

بالإضافة إلى ذلك، يمكنك الاطّلاع على أفضل الممارسات والاطّلاع على أمثلة حول:

- تحديد السياسات التي ستحكم سلوك الذكاء الاصطناعي في تطبيقك؛

- إنشاء عناصر الشفافية للتواصل ونهجك المسؤول تجاه المستخدمين أو

- تأمين تطبيقك من الاستخدام الضار:

وقبل كل شيء، تذكر أن النهج السليم للسلامة والمسئولية هو أحد انعكاسية ذاتية وتتكيّف مع الجوانب الفنية والثقافية والعملية التحديات. شارك أنت وفريقك في المراجعات النقدية المنتظمة نهجنا لضمان أفضل النتائج.

تحديد السياسات على مستوى النظام

تحدّد سياسات "أمان المحتوى" أنواع المحتوى الضارّ التي لا يُسمح بها. في منصة على الإنترنت. قد تكون على دراية بسياسات المحتوى على المنصات مثل YouTube أو Google Play. قانع تتشابه سياسات تطبيقات الذكاء الاصطناعي التوليدي: فهي تحدد نوع المحتوى الذي يجب ألا ينشئه تطبيقك، كما أنّها ترشدك إلى كيفية ضبط النماذج وإجراءات الوقاية المناسبة التي يجب إضافتها.

يجب أن تعكس سياساتك حالة استخدام تطبيقك. على سبيل المثال، منتج يعتمد على الذكاء الاصطناعي التوليدي ويهدف إلى تقديم أفكار للأنشطة العائلية استنادًا إلى اقتراحات المنتدى قد تتضمن سياسة تمنع إنشاء محتوى عنيف بطبيعته، فقد يكون ضارًا للمستخدمين. وعلى العكس، تطبيق يلخص أفكار قصص الخيال العلمي التي اقترحها المستخدمون تريد السماح بتوليد العنف، نظرًا لأنه موضوع للعديد من القصص في من هذا النوع.

يجب أن تحظر سياسات الأمان إنشاء محتوى ضارّ للمستخدمين أو غير القانوني، ويجب أن تحدد أنواع المحتوى الذي يتم إنشاؤه هذا الشريط لتطبيقك. قد ترغب أيضًا في التفكير في تضمين استثناءات المحتوى التعليمي أو الوثائقي أو العلمي أو الفني يمكن اعتباره ضارًا لولا ذلك.

تحديد سياسات واضحة مع مستوى عالٍ من التفاصيل، بما في ذلك واستثناءات السياسة مع أمثلة، هو أمر أساسي لبناء بيئة المنتج. يتم استخدام سياساتك في كل خطوة من خطوات تطوير النموذج. للبيانات أو التنظيف أو التسمية، أو عدم الدقة، يمكن أن يؤدي إلى بيانات مصنفة بشكل خاطئ أو الإفراط في الإزالة أو عدم إزالة البيانات بشكل كافٍ سيؤثر ذلك في استجابة نموذجك للأمان بالنسبة من أغراض التقييم، ستؤدي السياسات غير المحددة إلى مقيّمين مما يزيد من صعوبة معرفة ما إذا كان نموذجك يتوافق مع سلامتك المعايير.

السياسات الافتراضية (للتوضيح فقط)

فيما يلي بعض الأمثلة على السياسات التي يمكنك استخدامها بشرط أن تتطابق مع حالة الاستخدام لديك.

| فئة السياسة | السياسة |

|---|---|

| معلومات حسّاسة تكشف عن الهويّة (SPII) | لن يذكر التطبيق المعلومات الحساسة أو التي تحدّد الهوية الشخصية المعلومات (مثل البريد الإلكتروني، أو رقم بطاقة الائتمان، أو رقم التأمين الاجتماعي لفرد عادي). |

| كلام يحض على الكراهية | لن ينشئ التطبيق محتوى سلبيًا أو ضارًا. يستهدف الهوية و/أو السمات المحمية (مثل الافتراءات العرقية، الترويج للتمييز أو الدعوات إلى العنف ضد الحماية مجموعات). |

| التحرش | لن ينشئ التطبيق أي محتوى ضار أو ترهيب أو تنمّر أو محتوى مسيء يستهدف فردًا آخر (على سبيل المثال، والتهديدات وإنكار أحداث مأساوية وإهانة ضحايا العنف). |

| المحتوى الخطير | لن ينشئ التطبيق تعليمات أو نصائح حول إلحاق الضرر الشخص و/أو الآخرين (على سبيل المثال، الوصول إلى أسلحة نارية أو تصنيعها الأجهزة المتفجرة، الترويج للإرهاب، تعليمات الانتحار). |

| محتوى جنسي فاضح | لن ينشئ التطبيق محتوى يتضمّن مراجع إلى الممارسات الجنسية أو محتوى بذيء آخر (مثل المحتوى الجنسي الذي يتضمّن مشاهد جنسية والأوصاف والمحتوى الذي يهدف إلى الإثارة). |

| إتاحة الوصول إلى السلع والخدمات الضارة | لن ينشئ التطبيق محتوى يروّج أو يتيح الوصول إلى السلع والخدمات والأنشطة التي قد تتسبّب بضرر (مثل تسهيل الوصول إلى الترويج للمقامرة والمستحضرات الصيدلانية والألعاب النارية والخدمات الجنسية). |

| المحتوى الضارّ | لن ينشئ التطبيق تعليمات لتنفيذ إجراءات غير قانونية. أو أنشطة خادعة (مثل إنشاء عمليات تصيّد احتيالي أو تقديم محتوى غير مرغوب فيه أو المحتوى المخصص لطلبات التوظيف الجماعي وأساليب التخلص من جميع القيود). |

عناصر الشفافية

ويُعد التوثيق طريقة أساسية لتحقيق الشفافية للمطورين الحكومات والجهات الفاعلة في السياسات والمستخدمين النهائيين لمنتجك. يمكن أن يستلزم ذلك إصدار تقارير فنية تفصيلية أو نماذج وبيانات وبطاقات نظام المعلومات الأساسية العامة بشكل مناسب استنادًا إلى معايير السلامة التقييمات. أدوات الشفافية هي أكثر من مجرد وسائل اتصال؛ هم أيضًا تقديم إرشادات للباحثين في مجال الذكاء الاصطناعي والناشرين والمطوّرين في مجال تطوير التطبيقات الاستخدام المسؤول للنموذج. هذه المعلومات مفيدة لمستخدمي منتجك أيضًا، الذين يرغبون في فهم تفاصيل النموذج.

بعض إرشادات الشفافية التي يجب أخذها في الاعتبار:

- كن واضحًا مع المستخدمين عند المشاركة في تجربة تكنولوجيا الذكاء الاصطناعي التوليدي وتسليط الضوء على إمكانية إنشاء نموذج غير متوقّع السلوك.

- تقديم وثائق شاملة حول طريقة عمل خدمة أو منتج الذكاء الاصطناعي التوليدي باستخدام لغة مفهومة. ننصحك بالنشر بشكل منظَّم عناصر الشفافية مثل بطاقات النماذج. توفّر هذه البطاقات الاستخدام المقصود لنموذجك وتلخيص التقييمات التي تم تنفيذها خلال عملية تطوير النموذج.

- وضِّحوا لهم كيف يمكنهم تقديم الملاحظات وطريقة التحكّم فيها، مثل

كـ:

- توفير آليات لمساعدة المستخدمين في التحقّق من صحة الأسئلة المستندة إلى الحقائق

- رمزا الإعجاب وعدم الإعجاب لملاحظات المستخدمين

- روابط للإبلاغ عن المشكلات وتقديم الدعم للاستجابة السريعة ملاحظات المستخدمين

- عناصر تحكُّم المستخدم في تخزين نشاط المستخدم أو حذفه

أنظمة الذكاء الاصطناعي الآمنة

التطبيقات المستنِدة إلى الذكاء الاصطناعي التوليدي تعرض مساحات عرض معقّدة للهجوم تتطلب إجراءات تخفيف أثر تنوعًا أكثر من التطبيقات التقليدية. يوفّر "إطار عمل الذكاء الاصطناعي الآمن" (SAIF) من Google نظرة شاملة إطار عمل مفهومي للنظر في كيفية تصميم تطبيقك المستند إلى الذكاء الاصطناعي التوليدي للاستخدامات الآمنة. يمكن أن يساعدك إطار العمل هذا في تقييم كيفية توظيف التوافق والتقييم العدائي الإجراءات الوقائية بشكل فعال للمساعدة في تأمين التطبيق، مع ذلك، تذكر أن هذه ليست سوى لبنات البداية. هناك تغييرات إضافية على من المحتمل أن تكون هناك حاجة إلى ممارسات المؤسسة والمراقبة والتنبيه تحقيق أهدافك الأمنية حسب حالة الاستخدام والسياق المحدَّدين

موارد المطوِّرين

أمثلة على سياسات الذكاء الاصطناعي التوليدي:

- توفّر Cloud Gemini API وPaLM API قائمة بسمات الأمان التي يمكن أن تشكِّل أساسًا لتعزيز الأمان .

- مثال على السياسات المضمّنة في تعديل على مستوى التقدُّم في مبادئ الذكاء الاصطناعي من Google لعام 2023

- اتحاد MLCommons، وهو اتحاد هندسي بني عليه فلسفة من التعاون المفتوح لتحسين أنظمة الذكاء الاصطناعي، المرجع 6 المخاطر، حيث يقيّمون نماذج حول أمان الذكاء الاصطناعي كجزء من مقياس أداء الذكاء الاصطناعي

لا يوجد نموذج واحد لعناصر الشفافية عبر غير أن بطاقات النماذج الحالية يمكن أن تكون نقطة انطلاق لإنشاء مجموعتك الخاصة: