A avaliação lado a lado surgiu como uma estratégia comum para avaliar qualidade e segurança das respostas de modelos de linguagem grandes (LLMs). Lado a lado as comparações podem ser usadas para escolher entre dois modelos diferentes, dois modelos comandos para o mesmo modelo ou até mesmo dois ajustes diferentes de um modelo. No entanto, analisar manualmente os resultados de comparação lado a lado pode ser complicado e entediante.

O Comparador de LLM é um app da Web com um complemento Biblioteca Python que permite análises escalonáveis mais eficazes de avaliações lado a lado com visualizações interativas. O Comparador de LLM ajuda você a:

Confira onde o desempenho do modelo é diferente: é possível dividir as respostas identificar subconjuntos dos dados de avaliação em que as saídas sejam significativas diferem entre os dois modelos.

Por que ela é diferente: é comum ter uma política contra qual desempenho do modelo e a conformidade são avaliados. A avaliação lado a lado ajuda a automatizar a conformidade com as políticas. avaliações e fornece justificativas para quais modelos provavelmente em conformidade. O Comparador de LLM resume esses motivos em vários temas e destaca qual modelo se alinha melhor com cada tema.

Analise as diferenças nas saídas do modelo: é possível investigar melhor como as saídas de dois modelos diferem entre as métricas integradas funções de comparação. A ferramenta pode destacar padrões específicos no texto gerado pelos modelos, fornecendo uma âncora clara para entender as diferenças.

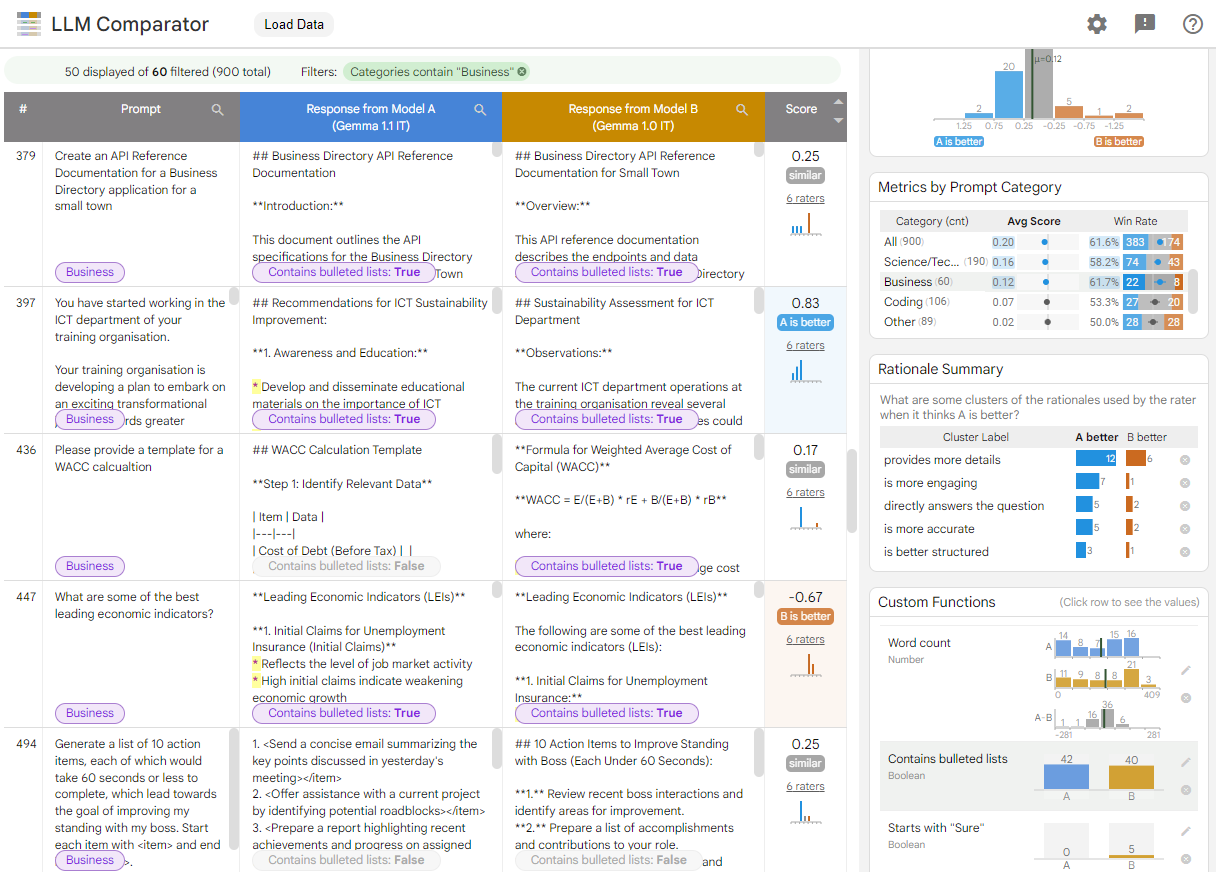

Figura 1. Interface do comparador de LLM mostrando uma comparação do Gemma Instruir o modelo v1.1 7B em relação à v1.0

O Comparador de LLM ajuda a analisar os resultados da avaliação lado a lado. Ele resume visualmente a performance do modelo de vários ângulos, permitindo que você inspecione interativamente as saídas de modelos individuais para uma compreensão mais profunda.

Confira o Comparador de LLM:

- Esta demonstração compara o desempenho do Gemma Instruct 7B v1.1 contra o Gemma Instruct 7B v1.0 no Conjunto de dados Chatbot Arena Conversations (em inglês).

- Este bloco do Colab (em inglês) usa a biblioteca Python para executar avaliação lado a lado usando a API Vertex AI e carrega resultados no app Comparador LLM em uma célula.

Para saber mais sobre o Comparador de LLMs, confira o artigo de pesquisa e Repositório do GitHub.