Este kit de ferramentas oferece recursos e ferramentas para aplicar as práticas recomendadas uso responsável de modelos abertos, como o Gemma, incluindo:

- Orientação sobre a definição de políticas de segurança, ajustes de segurança e classificadores de segurança e avaliação de modelos.

- A ferramenta de aprendizado de interpretabilidade para investigação e depurando o comportamento do Gemma em resposta a comandos.

- O LLM Comparator (em inglês) para execução e visualização de comparações os resultados da avaliação.

- Uma metodologia para criar classificadores de segurança robustos com o mínimo de exemplos.

Esta versão do kit de ferramentas concentra-se apenas em modelos de texto para texto em inglês. Você podem dar feedback para tornar este kit de ferramentas mais útil mecanismo na parte inferior da página.

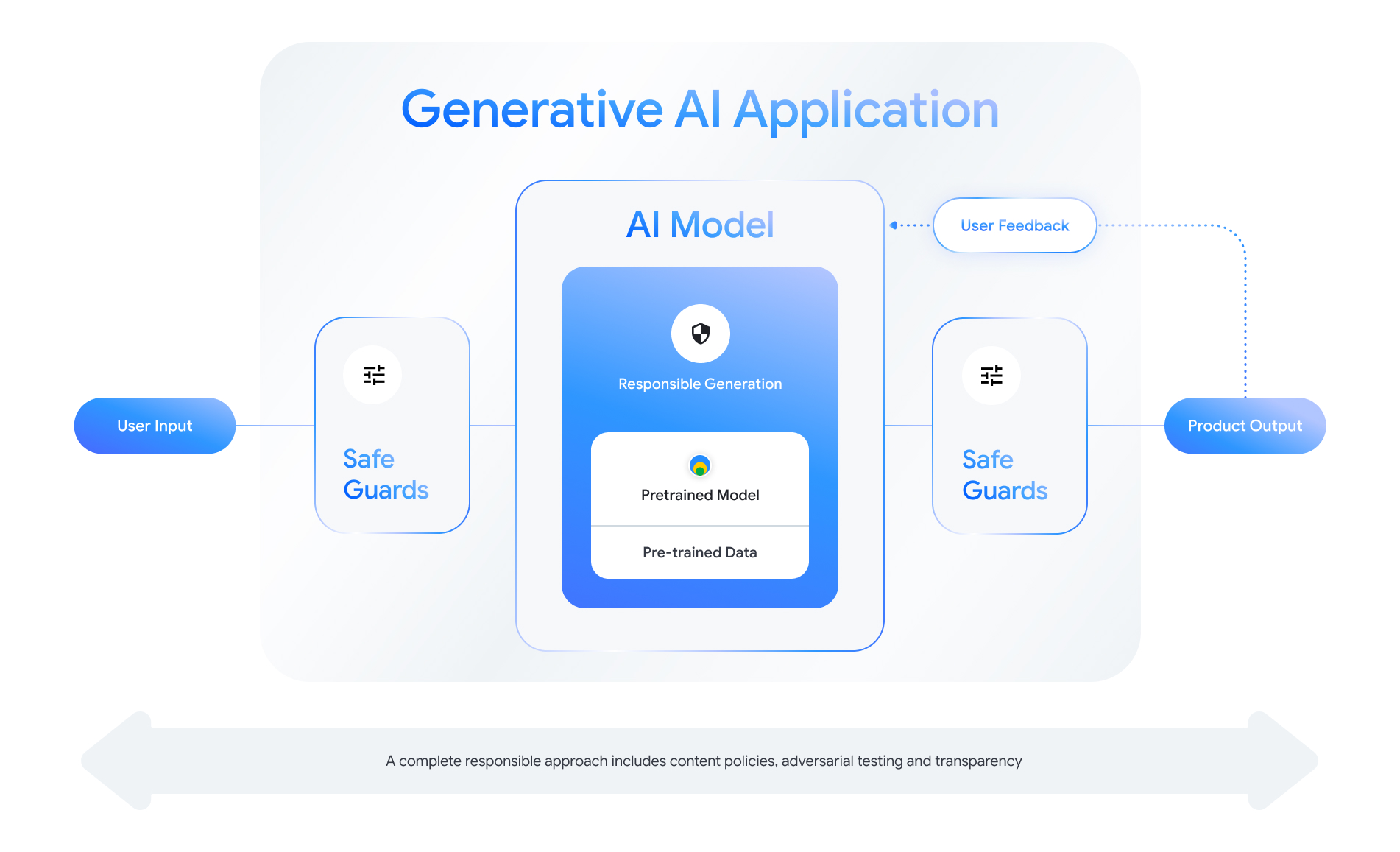

Ao desenvolver com o Gemma, você deve ter uma abordagem holística de responsabilidade e considerar todos os desafios possíveis nos níveis do aplicativo e do modelo. Esse kit de ferramentas abrange técnicas de risco e mitigação para lidar com questões de segurança, privacidade, imparcialidade e responsabilidade.

Confira o restante deste kit de ferramentas para mais informações e orientações: