Bu araç setinde, başarılı bir proje için en iyi uygulamaları kullanabileceğiniz Aşağıdakiler dahil olmak üzere, Gemma gibi açık modellerin sorumlu bir şekilde kullanımı:

- Güvenlik politikaları, güvenlik ayarları ve güvenlik sınıflandırıcıları ayarlama rehberi model değerlendirmesi.

- sorunları araştırmak ve değerlendirmek için Learning Yorumlanabilirlik Aracı istemlere yanıt olarak Gemma'nın davranışlarında hata ayıklama.

- Karşılaştırmaları çalıştırmak ve görselleştirmek için LLM Karşılaştırıcı sonuçları belirleyebilirsiniz.

- Güçlü güvenlik sınıflandırıcıları oluşturmaya yönelik bir metodoloji örneklerle özetleyelim.

Araç setinin bu sürümü yalnızca İngilizce metinden metne dönüştürme modellerine odaklanıyor. Siz geri bildirim vererek bu araç setini daha faydalı hale getirmek için geri bildirimde bulunabilir. mekanizma bağlantısını tıklayın.

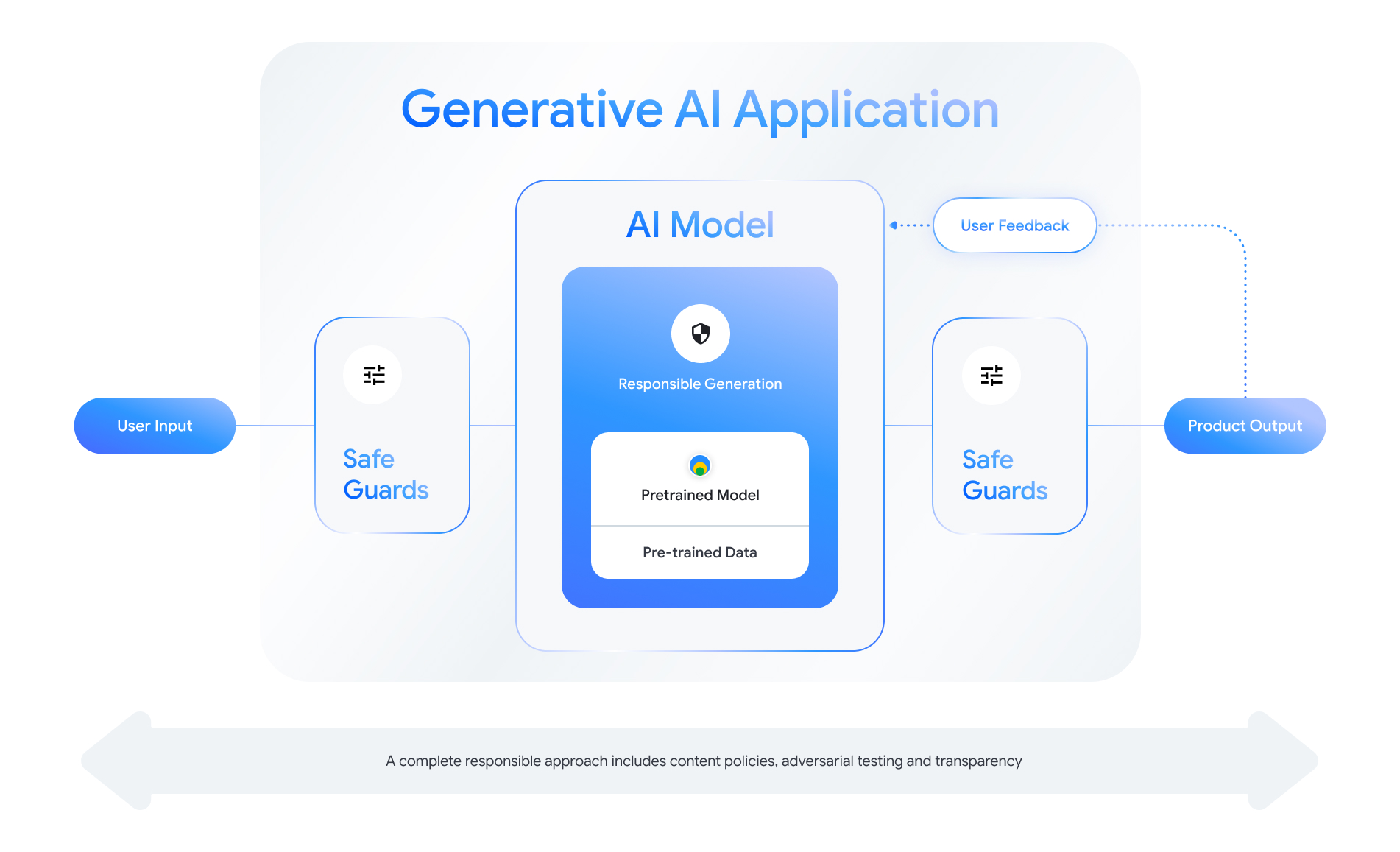

Gemma ile geliştirme yaparken, sorumluluk konusunda bütüncül bir yaklaşım benimsemelisiniz. uygulama ve model düzeylerinde olası tüm zorlukları göz önünde bulundurmalısınız. Bu araç setinde güvenlik, gizlilik ve güvenlik gibi konuları ele almak için risk ve azaltma ve hesap verilebilirlik konularını netleştirmek sizin işinizdir.

Daha fazla bilgi ve yol gösterici bilgiler için bu araç setinin diğer bölümlerine de göz atabilirsiniz: