在边缘平台上部署高性能 ML 和 GenAI

高效的转化、运行时和设备端机器学习优化。

基于经过实战检验的 TensorFlow Lite 基础构建

LiteRT 不仅是新产品,还是全球部署最广泛的机器学习运行时的新一代产品。它为数以十亿计的设备提供支持,让您每天使用的应用能够以低延迟和高隐私保护的方式运行。

深受最关键的 Google 应用的信赖

超过 10 万款应用,数十亿全球用户

LiteRT 亮点

跨平台就绪

释放生成式 AI 的强大功能

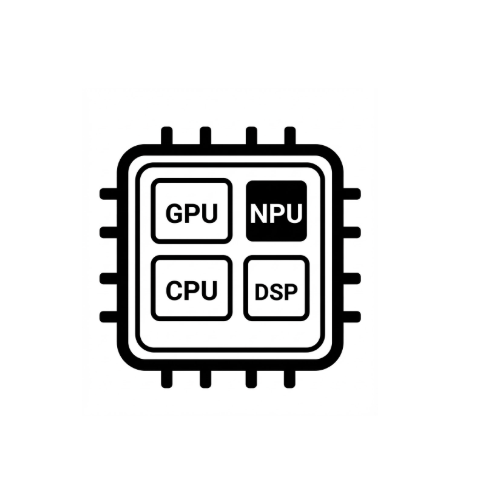

简化硬件加速

多框架支持

通过 LiteRT 部署

获取模型

使用 .tflite 预训练模型或将 PyTorch、JAX 或 TensorFlow 模型转换为 .tflite

优化模型

(可选)量化模型

运行

选择所需的加速器并在 LiteRT 上运行

示例、模型和演示

查看示例应用

教程将通过完整的端到端示例向您展示如何使用 LiteRT。

查看生成式 AI 模型

经过预先训练的开箱即用生成式 AI 模型。

观看演示 - Google AI Edge Gallery 应用

展示设备端 ML/GenAI 用例的图库